Wirtualne centra danych

-

- Krzysztof Jakubik,

- 05.10.2006

Mała wirtualizacja, duży zysk

Swoje pięć minut mają obecnie tzw. maszyny wirtualne - oprogramowanie umożliwiające uruchomienie kilku lub kilkunastu wirtualnych systemów na jednej fizycznej maszynie. W grze o ten rynek bierze udział coraz więcej producentów. I chociaż bootowanie Windows 95 pod VMware w Windows NT było czymś niesamowitym w 1998 r., to nawet wtedy nie była to żadna nowość - wirtualne partycjonowanie na mainframe'ach można było wykonać już w latach 70. Przez wiele lat komercyjni dostawcy Uniksa dodawali funkcje wirtualizacyjne do swoich produktów. Dlaczego zatem dopiero teraz wirtualizacja przeżywa taki boom?

Rynek zmienił się przez te lata. Dawniej rozpoczęcie inwestycji w wirtualną infrastrukturę było ekstremalnie drogie, a i same rozwiązania mało popularne. Dziś wirtualna technologia jest powszechnie dostępna dla platformy x86, a i sama platforma na tyle wydajna, że wirtualizację opłaca się stosować.

Wielu klientów zaczyna być zainteresowanych wirtualizacją, gdyż pozwala ona znacznie obniżyć koszty, nawet w mniejszych firmach. Nadszedł czas, gdy firmy będą aktualizować systemy z Windows 2000/2003. Dzięki wirtualnym maszynom, zamiast kupować sześć czy siedem serwerów, mogą kupić nieco droższe jeden lub dwa, dając każdemu z nich funkcjonalność kilku.

Większym firmom wirtualne maszyny oferują jeszcze więcej korzyści. Tam, gdzie pracuje kilkadziesiąt serwerów, część z nich na pewno nie jest wykorzystana w pełni. Co więcej, statystyki przeprowadzone przez producentów serwerów pokazały, że średnio moc obliczeniowa serwera jest wykorzystana w... 15%. To oznacza, że wykonując właściwą analizę wykorzystania zasobów i odpowiednio planując to wykorzystanie (np. wgrywając na serwer dwie aplikacje, z których jedna jest obciążona w dzień, a druga w nocy), nie tylko nie trzeba będzie kupować nowych serwerów, ale okaże się, że mamy ich za dużo.

Szybki rozwój procesorów i relatywnie wolny postęp w rozwoju systemów operacyjnych i aplikacji doprowadziły nas do momentu, gdy kupowanie nowego serwera do pracy ze starymi aplikacjami nie ma sensu. Gdy nasze stare serwery wymagają wymiany, kupmy jeden nowy serwer średniej klasy w miejsce kilku starych i zainstalujmy wszystkie stare aplikacje na jednym nowym serwerze, w wirtualnych maszynach. Oprócz oczywistych oszczędności przy kosztach zakupu, będzie można zaoszczędzić także na całkowitych kosztach obsługi - zasilaniu, serwisie, chłodzeniu itp.

<hr size="1" noshade>Xen 3.0

Wirtualizacja oparta na mikrojądrze kontra parawirtualizacja

Xen wrósł w kod źródłowy Linuksa jako ekwiwalent nowej architektury CPU. Skompilowanie Linuksa z Xenem jako docelową architekturą da nam Linuksa z wbudowaną parawirtualizacją. Wówczas oprogramowanie Xen będzie uruchamianie zanim załaduje się jądro Linuksa, umożliwiając uruchomienie Linuksa, BSD, NetWare lub innych systemów, które zostały przystosowane do pracy z systemem Xen.

W Xen zaskakująco prosta okazuje się migracja systemów z platformy fizycznej do wirtualnej - wystarczy zastosowanie komendy "dd" aby skopiować systemową partycję z innego serwera do lokalnego pliku maszyny wirtualnej.

Xen jest bardzo prosty w instalacji i obsłudze, ale jest też bardzo szybkim systemem, nie tylko w kontekście szybkości przetwarzania. Świetnie sprawdza się także przy operacjach związanych z siecią i SAN. Jest bardzo elastyczny jeśli chodzi o pamięci masowe. Wirtualna maszyna może korzystać z dedykowanych napędów lub macierzy, dedykowanych partycji na istniejących napędach lub obrazów dysków na jednym ze zmapowanych systemów plików hosta.

Konfiguracja parametrów Xen jest przechowywana w plikach tekstowych, a interfejs umożliwiający zarządzanie to mały zestaw prostych rozkazów wpisywanych do wierszy poleceń. Novell zapowiedział, że pracuje nad interfejsem graficznym dla Xen. Strona internetowa Xensource twierdzi, że Xen zawsze był i będzie udostępniany na bazie otwartego źródła.<hr size="1" noshade>

Wirtualna podróż

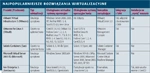

Najpopularniejsze rozwiązania wirtualizacyjne

Inne podejście może być sklasyfikowane jako wirtualizacja oparta na hoście - ten sposób wykorzystano w systemach Virtuozzo firmy SWsoft i Solaris Containers firmy Sun. W tym przypadku pojedyncza instancja systemu operacyjnego hosta wspiera wiele wirtualnych instancji, ale z wykorzystaniem tego samego jądra systemu operacyjnego, tych samych urządzeń wejścia-wyjścia i adresując zapotrzebowanie dla wirtualnych serwerów na poziomie procesów. Wszystkie platformy wirtualizacyjne to warstwa programowa umieszczona pomiędzy bazowym systemem operacyjnym i maszyną wirtualną, przekazująca zapotrzebowanie maszyny wirtualnej i wywołania urządzeń wejścia-wyjścia do bazowego systemu operacyjnego.

Maszyny wirtualne radzą sobie wyśmienicie, a przez ostatni rok nastąpiły drastyczne zmiany w praktycznie każdej dziedzinie - wzrosła wydajność i stabilność, wprowadzono integrację z sieciami SAN i wsparcie dla systemów 64-bitowych.

Z drugiej strony, posiadanie infrastruktury wirtualnej może prowokować do nadmiernej oszczędności, objawiającej się próbami umieszczenia zbyt wielu wirtualnych maszyn na jednym fizycznym serwerze. Pewną niedogodnością jest też fakt, że ewentualna awaria fizycznego serwera powoduje oczywisty przestój wszystkich serwerów wirtualnych.

Obok oprogramowania w technologie wirtualizacji zaangażowali się także najwięksi producenci procesorów - AMD i Intel. Obie firmy wprowadziły do swoich najnowszych układów technologie wspierające wirtualne maszyny. Intel VT (Virtualization Technology) i AMD SVM (Secure Virtual Machine) to rozwiązania, które przejmują na siebie część emulacji sprzętu, a także zarządzanie pamięcią w maszynach wirtualnych. Dzięki temu procesory x86 stały się chyba jedną z najlepszych platform dla małych i średnich firm do tworzenia wirtualnych serwerów, rozpoczynając nową erę w tej dziedzinie.