Jak równy z równym

-

- Tomek Janoś,

- 01.02.2002

Pora przyjrzeć się dobrze znanemu rozwiązaniu i ponownie ocenić jego możliwości przetwarzania danych, współdzielenia plików i współpracy użytkowników.

Pora przyjrzeć się dobrze znanemu rozwiązaniu i ponownie ocenić jego możliwości przetwarzania danych, współdzielenia plików i współpracy użytkowników.

Peer-to-peer pojawiło się na pierwszych stronach gazet w związku z kontrowersjami wokół internetowych serwisów wymiany plików (głównie muzycznych) i sprawą ochrony praw autorskich. W cieniu Napstera pozostają tworzone dla użytkowników korporacyjnych narzędzia oparte na technice komputerów równorzędnych. Zdaniem niektórych analityków peer-to-peer może wiele zmienić w świecie informatyki, tak jak zrobiły to pecety w latach 80. czy technologia webowa w latach 90.

Takie prognozy napotykają jednak na sceptycyzm specjalistów IT, których doświadczenia z czasów wczesnych sieci LAN sprawiły, że mają oni sieci peer-to-peer za mało bezpieczne, nieskalowalne i trudne w zarządzaniu.

Nowe możliwości, nowi sprzymierzeńcy

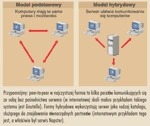

Rys. 1. Dwa modele peer-to-peer

Jeśli jednak peer-to-peer (w dalszej części artykułu oznaczane jako p2p) nie rozpowszechniło się w poprzednim wcieleniu, to dlaczego miałoby się tak stać teraz? Pamiętajmy, że w latach 80. nie istniały narzędzia katalogowe, takie jak Lightweight Directory Access Protocol (LDAP). Moc przetwarzania, przepustowość sieci i pojemność pamięci masowych były tysiące razy mniejsze. Dużo wysiłku kosztowało zarządzanie połączeniami p2p, a odpowiednie do tego narzędzia wtedy nie istniały.

Rys. 2. Model JXTA

Budowa wirtualnego superkomputera

Najbardziej spektakularne zastosowania sieci równorzędnych polegają na wykorzystywaniu wolnych zasobów w komputerach PC i skumulowaniu ich w jeden wirtualny superkomputer. Taka platforma może obsługiwać potężne aplikacje, które da się prowadzić równoległymi wątkami - po podzieleniu ich na małe kawałki i rozdzieleniu na pojedyncze maszyny.

Według analityków z Omni Consulting Group średnio ok. 47 proc. cykli obliczeniowych w firmie jest wolnych, w tym na mocno obciążonych serwerach i hostach. Kiedy weźmiemy pod uwagę tylko desktopy, to liczba ta jest dużo wyższa.

Wczesne inicjatywy łączenia rozproszonych pecetów do wspólnej pracy miały charakter non profit i skupiały dawców komputerowych cykli obliczeniowych w ramach akcji związanych z badaniami medycznymi czy np. projektu SETI@Home (obwołanego największym rozproszonym komputerem świata, z mocą ponad 25 teraflopów - 25 bilionów operacji/s), wymyślonego w celu znalezienia w przestrzeni kosmicznej śladów obcych cywilizacji.

Szybko jednak wokół tego rodzaju techniki obliczeniowej, zwanej grid computing, pojawił się biznes. Komercyjne przedsięwzięcia to obecnie ok. 20 proc. działalności w ramach Global Grid Forum (GGF). Komercyjne aplikacje typu grid computing wykorzystuje m.in. Boeing - zamiast tuneli aerodynamicznych do symulacji i analizy przepływu wiatru wokół prototypów. Podobnie rozproszone stacje robocze są wykorzystywane w prowadzeniu analiz sejsmograficznych, symulacjach wypadków i w analizie ryzyka.

Grid computing wykorzystuje się przy ustalaniu sekwencji ludzkiego genomu. Badania, które dawniej zabierały lata, teraz można ograniczyć do tygodni. Do ustalania sekwencji genetycznych służy oprogramowanie amerykańskiej firmy Entropia 3000. Jest to wielka aplikacja, podzielona na małe wątki i rozdzielona na poszczególne komputery PC. Serwer monitoruje postęp w wykonywaniu zadania i może łączyć ponownie ze sobą wątki. Wątki działają wyłącznie w tle, a technika sandboxingu izoluje je i zapobiega wglądowi serwera w pliki użytkowników pecetów. Bioinformatyka jest dziedziną, w której grid computing sprawdza się wyjątkowo dobrze. Bioinformatycy "mielą" olbrzymie ilości danych i działają raczej "in-silico" niż in vitro czy in vivo.