O tym się mówi: bezpieczeństwo GenAI

Materiał partnerski Z wyników badania wynika, że organizacje chętnie wykorzystują narzędzia oparte na generatywnej sztucznej inteligencji pomimo poważnych obaw dotyczących bezpieczeństwa

W świecie IT panuje tendencja do powtarzania własnych błędów w pośpiesznym wprowadzaniu najnowszych innowacji technologicznych. Najlepszym tego przykładem są wdrażane od roku narzędzia oparte na generatywnej sztucznej inteligencji (GenAI) — trend zainspirowany popularnością ChatGPT. Wszechobecność nowych aplikacji GenAI przypomina to, czego byliśmy świadkami w przypadku SAAS. Organizacje pospiesznie migrowały aplikacje ze swoich centrów danych do środowisk chmurowych, martwiąc się o ich bezpieczeństwo (i wydajność) dopiero po fakcie.

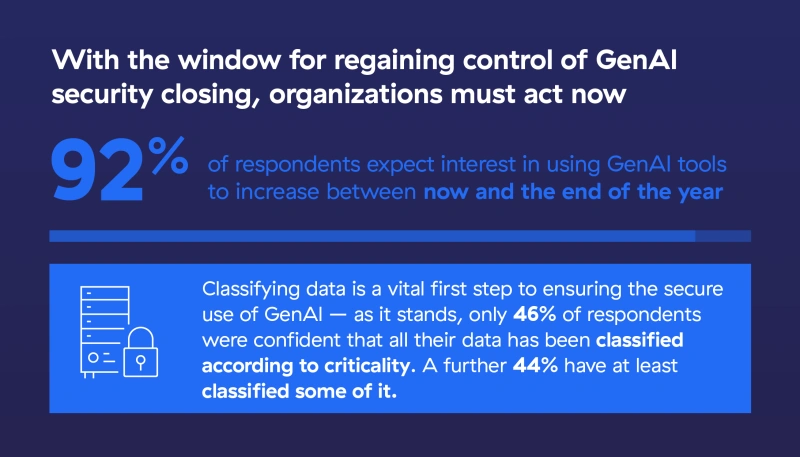

Firma Zscaler zleciła niedawno przeprowadzenie badania zatytułowanego „O tym się mówi: bezpieczeństwo GenAI”, którego celem było ustalenie, w jaki sposób przedsiębiorstwa wykorzystują obecnie narzędzia GenAI, jakie konsekwencje dla bezpieczeństwa ma szybkość ich wdrażania oraz w jaki sposób w tym procesie chroniona jest własność intelektualna i dane klientów. Wyniki, które odzwierciedlają odpowiedzi 900 liderów IT na 10 globalnych rynkach, wskazują, że organizacje znajdują się pod presją, aby jak najszybciej wdrażać narzędzia GenAI, pomimo poważnych obaw związanych z bezpieczeństwem.

Liczne wątpliwości dotyczące bezpieczeństwa

Według naszych badań, aż 95 procent organizacji już wykorzystuje w swojej działalności narzędzia GenAI pod różną postacią. 57 proc. liderów IT zezwala na ich używanie bez ograniczeń, a nieco ponad jedna trzecia (38 proc.) podchodzi do tego z ostrożnością. Pozostałe 5 procent respondentów odpowiedziało, że albo wstrzymują się, aby zobaczyć, dokąd zmierza technologia, albo całkowicie zakazali korzystania z tego rodzaju narzędzi.

Pomimo tak dużej popularności GenAI, 89% ankietowanych liderów IT przyznaje, że ich organizacja uważa generatywną sztuczną inteligencję za potencjalne zagrożenie dla bezpieczeństwa, a prawie połowa (48%) zgodziła się, że zagrożenia mogą nawet przewyższać możliwości, jakie te narzędzia oferują.

Większość firm korzysta z narzędzi GenAI

Wyniki badania wskazują, że szybkie wdrożenie GenAI nie jest tak dobrze skalkulowanym ryzykiem, jak moglibyśmy sobie tego życzyć. Wydaje się, że organizacje powinny wziąć pod uwagę zarówno kwestie bezpieczeństwa, jak i prywatności, zanim zrobią kolejny krok. Generatywna sztuczna inteligencja kusi niezwykłymi korzyściami pod względem produktywności i kreatywności, więc całkowity zakaz jej stosowania postawiłby organizacje w niekorzystnej sytuacji konkurencyjnej. Z tej perspektywy fakt, że tylko niewielka mniejszość podąża tą drogą, jest dobrą wiadomością. Jednak wdrożenie tego rodzaju rozwiązań powinno być realizowane w sposób metodyczny, z uwzględnieniem wszelkich zagrożeń, tak aby korzystanie z nowych narzędzi było odpowiedzialne i bezpieczne.

Skąd obawy o bezpieczeństwo?

Największe obawy wymieniane przez organizacje, które nie korzystają z GenAI, to potencjalna utrata wrażliwych danych, brak zrozumienia zagrożeń i korzyści związanych z GenAI oraz brak zasobów do monitorowania zastosowań. Fakt, że 23 procent organizacji korzystających z narzędzi GenAI w ogóle ich nie monitoruje, wyjaśnia, dlaczego ten ostatni punkt można uznać za szczególne zagrożenie.

Organizacje nie reagują na zagrożenia

Przy wprowadzaniu każdej nowej technologii kluczowe jest zrozumienie unikalnych wyzwań związanych z bezpieczeństwem, tak aby nie przyćmiły jej potencjału. Brak dodatkowych zabezpieczeń związanych z GenAI — do czego przyznaje się jedna trzecia korzystających z niej organizacji — jest kolejnym ryzykownym zaniedbaniem, które może narazić organizacje na ataki. I choć 31 procent organizacji z tej samej grupy uwzględniło rozwiązania specyficzne dla GenAI w swojej mapie drogowej, zamierzenia często nie przekładają się na czyny, ponieważ tymczasowe rozwiązania lubią pozostawać w użyciu na stałe.

W przypadku GenAI głównym wyzwaniem w zakresie bezpieczeństwa jest wyciek danych, co podkreśla olbrzymie znaczenie solidnych zabezpieczeń bezpieczeństwa danych. Pierwszym krokiem, jaki muszą wykonać organizacje, jest zatem uzyskanie wglądu w to, kto korzysta z jakich aplikacji AI, a następnie kontrolowanie ich użycia. Po uzyskaniu tych informacji można wdrożyć pomiary bezpieczeństwa danych, zaczynając od klasyfikacji danych, aby zapobiec wyciekom. Co zaskakujące, tylko 46 procent respondentów miało pewność, że ich organizacja sklasyfikowała wszystkie swoje dane według poziomu krytyczności. Kolejne 44 procent przynajmniej zaczęło klasyfikować niektóre dane jako warunek wstępny do wdrożenia zabezpieczeń. Ale to oznacza, że wciąż jest mnóstwo do zrobienia.

Organizacje muszą przejść do działania

IT musi przejąć kontrolę nad wykorzystaniem i bezpieczeństwem GenAI

Ponieważ organizacje wydają się w tak dużym stopniu nieprzygotowane do zabezpieczenia GenAI, można się zastanawiać, co wymusza tak szybkie przyjęcie tej technologii.

O dziwo źródło tej presji jest zupełnie inne, niż można podejrzewać. Pomimo powszechnej świadomości, to nie pracownicy są siłą napędową trwającego pędu — tylko 5 procent respondentów stwierdziło, że ta grupa wywiera największą presję. Nie są to również potencjalni klienci (21 procent). Zamiast tego, 59 procent liderów IT uznało za siłę napędową samych siebie.

W tym przypadku wydaje się, że sytuacja jest mniej związana z „presją” biznesu na wprowadzanie nowych technologii, a bardziej z „chęcią” zespołów IT do nadążania za innowacjami technologicznymi. Przy wciąż niskim zainteresowaniu liderów biznesowych wydaje się, że technologia GenAI jeszcze nie opuściła stadium inkubacji w działach IT i dopiero może się stać elementem podstawowej infrastruktury informatycznej.

Fakt, że to zespoły IT odpowiadają za wczesne wdrożenie generatywnej sztucznej inteligencji, powinien być uspokajający zarówno dla liderów IT, jak i dla liderów biznesowych. Oznacza to, że jest możliwość strategicznego ograniczenia tempa wdrażania GenAI, co da zespołom IT wystarczająco dużo czasu na wprowadzenie solidnych zabezpieczeń, zanim dojdzie do kryzysu związanego z bezpieczeństwem i prywatnością.

Wdrożeniu GenAI powinno towarzyszyć rozwiązanie oparte na zasadzie „zero zaufania”, takie jak platforma Zscaler Zero Trust Exchange, zapewniające kompleksowy nadzór nad wykorzystaniem technologii przez użytkownika oraz umożliwiające organizacjom utrzymanie bezpiecznego i kontrolowanego środowiska. Wykonanie następujących czynności pozwoli zespołom IT odzyskać kontrolę nad narzędziami GenAI:

- Przeprowadzanie dokładnej oceny ryzyka związanego z bezpieczeństwem aplikacji GenAI w celu zrozumienia zagrożeń dla bezpieczeństwa i prywatności i podjęcia odpowiednich działań

- Wdrożenie całościowej architektury zerowego zaufania w celu uzyskania widoczności i autoryzowania tylko zatwierdzonych aplikacji i użytkowników GenAI

- Ustanowienie kompleksowego systemu rejestrowania w celu śledzenia wszystkich wskazań i reakcji GenAI

- Wdrożenie zabezpieczeń opartych na zasadzie „zero zaufania”, aby monitorować wszystkie działania GenAI i zapobiec eksfiltracji danych

Za każdym razem, gdy pojawia się nowa technologia, przynosi ona zarówno pozytywne, jak i negatywne przykłady użycia. Zscaler jest pionierem rozwiązań opartych na zasadzie „zero zaufania”, które pozwolą bezpiecznie i odpowiedzialnie uwolnić olbrzymi potencjał GenAI, podobnie jak kiedyś zadbaliśmy o bezpieczeństwo powszechnej transformacji chmurowej. Zscaler pomaga przyspieszyć generatywną rewolucję AI.