ChatGPT OpenAI kończy rok; co zrobił (i czego nie zrobił)

-

- Lucas Mearian,

- 17.11.2023, godz. 11:52

W ciągu ostatnich 12 miesięcy ChatGPT zasadniczo zmienił krajobraz sztucznej inteligencji i, szerzej, technologii. Podczas gdy ostrzeżenia o zbliżającej się zagładzie ze strony samoświadomości AI wciąż wiszą w powietrzu, generatywna sztuczna inteligencja również zaskoczyła wielu, podejmując się zadań, które nigdy nie wydawały się możliwe.

Kiedy startup OpenAI z San Francisco uruchomił ChatGPT 30 listopada 2022 r., krajobraz technologiczny został poruszony do samego rdzenia - a sztuczna inteligencja (AI) szybko przeszła od idei marginesu do głównego nurtu adopcji.

"Spędziliśmy kilka dekad ucząc się, jak rozmawiać z maszynami. To, co zmieniło się w listopadzie 2022 r., to fakt, że maszyny nauczyły się rozmawiać z nami" - powiedział Fletcher Previn, CIO Cisco. "W grudniu było jasne, że [ChatGPT] będzie miał znaczący wpływ, a jak na coś, co istnieje od roku, nadal zadziwia".

Zobacz również:

- Majowa konferencja Apple może być ważniejsza niż oczekujemy

- Cisco finalizuje przejęcie Splunk

- Blaski i cienie AI

Podobnie jak inne przedsiębiorstwa, Cisco wierzy, że narzędzia generatywnej sztucznej inteligencji (gen AI), takie jak ChatGPT, zostaną ostatecznie wbudowane w każdy system IT i produkt zewnętrzny.

"Gwałtowna globalna popularność ChatGPT dała nam pierwszy prawdziwy punkt zwrotny w publicznej adopcji AI" - powiedziała Ritu Jyoti, wiceprezes grupy Worldwide Artificial Intelligence and Automation Market Research w IDC. "Wraz ze wzrostem inwestycji w sztuczną inteligencję i automatyzację, najważniejsze jest skupienie się na wynikach, zarządzaniu i zarządzaniu ryzykiem".

Sama sztuczna inteligencja nie jest niczym nowym. Firmy od lat intensywnie inwestują w predykcyjną i interpretacyjną sztuczną inteligencję; weźmy pod uwagę Microsoft Outlook i jego funkcję AutoComplete. Jednak wydanie GPT-3.5 przyciągnęło uwagę całego świata i wywołało gwałtowny wzrost inwestycji w genAI w ogóle oraz w duże modele językowe (LLM), które stanowią podstawę różnych narzędzi.

Najprościej rzecz ujmując, LLM to silniki przewidywania następnego słowa, obrazu lub kodu. Na przykład ChatGPT (skrót od "chatbot generative pre-trained transformer") jest zbudowany na GPT LLM, algorytmie komputerowym, który przetwarza dane wejściowe w języku naturalnym i przewiduje następne słowo na podstawie tego, co już widział. Następnie przewiduje kolejne słowo, kolejne słowo i tak dalej, aż do uzyskania pełnej odpowiedzi.

Źródło: Clarity Capital

Podróż sztucznej inteligencji nie jest wyjątkowa. Technolodzy tacy jak Previn porównują ją do wczesnych dni przetwarzania w chmurze, które wywołały podobne dyskusje i debaty na temat bezpieczeństwa, prywatności, własności danych i odpowiedzialności.

"Ludzie mówili, że żaden bank nigdy nie umieści swoich danych w chmurze publicznej, a żadne przedsiębiorstwo nigdy nie będzie hostować swojej poczty e-mail w internecie" - powiedział Previn. "Myślę, że było wiele podobnych obaw związanych z tym, co oznacza umieszczenie swoich koronnych zasobów danych w czyimś centrum danych".

Cała naprzód, z problemami

Większość przedsiębiorstw wciąż eksperymentuje z ChatGPT i innymi narzędziami genAI, próbując ustalić, gdzie będzie ich zwrot z inwestycji. Według Avivah Litan, wiceprezesa ds. analityki w Gartner Research, większość z nich pozostaje niepewna co do tego, jak czerpać z nich korzyści.

"Poważnie obawiają się, że pozostaną w tyle, jeśli nie przyjmą tych nowych technologii, ale nie są odpowiednio przygotowani do ich przyjęcia" - powiedziała Litan. "Gotowość organizacyjna jest niewystarczająca pod względem umiejętności, zarządzania ryzykiem i bezpieczeństwem oraz ogólnej strategii".

Wraz z obietnicą automatyzacji przyziemnych zadań, tworzenia nowych form treści cyfrowych i zwiększania produktywności w miejscu pracy, w branżach i środowiskach akademickich pojawiły się obawy, gdy ChatGPT pojawił się na scenie. W miesiącach po jego uruchomieniu niektóre z największych nazwisk w dziedzinie technologii publicznie ostrzegły świat, że może to być początek końca ludzkości; wezwali do zdecydowanej przerwy w rozwoju ChatGPT.

Luminarze technologii, tacy jak współzałożyciel Apple Steve Wozniak, CTO Microsoft Kevin Scott, a nawet CEO OpenAI Sam Altman, dołączyli do ponad 33 000 sygnatariuszy listu otwartego ostrzegającego przed zagrożeniami społecznymi związanymi z genAI. Chociaż list miał niewielki wpływ na marsz sztucznej inteligencji, pobudził inicjatywy rządowe mające na celu powstrzymanie tej technologii. Na przykład Parlament Europejski przyjął ustawę o sztucznej inteligencji.

"Źli ludzie i złośliwe państwa narodowe będą również wykorzystywać te technologie do atakowania wolności i wspierania własnych programów przestępczości, autokracji i krzywdy. Ostatecznie ChatGPT i genAI uczynią świat bardziej ekstremalnym - zarówno z negatywnego, jak i pozytywnego punktu widzenia" - powiedział Litan.

W Stanach Zjednoczonych prezydent Joseph R. Biden Jr. wydał dwa zarządzenia wykonawcze, w których zażądał między innymi, aby agencje federalne w pełni zweryfikowały generatywne aplikacje sztucznej inteligencji pod kątem wszelkich kwestii związanych z bezpieczeństwem, prywatnością i bezpieczeństwem. Jednak większość innych wysiłków sprowadza się do mozaiki regionalnych lub stanowych przepisów mających na celu ochronę prywatności i praw obywatelskich.

Źródło: Clarity Capital

Do tej pory nie uchwalono żadnych federalnych przepisów mających na celu kontrolowanie sztucznej inteligencji.

ChatGPT i inne platformy AI są "bardzo niedojrzałe" w swoim rozwoju i wysoce wadliwe, dlatego też potrzebne są regulacje, według Fridy Polli, zajmującej się etyką technologii i neurobiologią na Harvardzie i MIT.

Na przykład na początku tego miesiąca globalna firma konsultingowa KPMG złożyła skargę dotyczącą niedokładnych informacji generowanych przez narzędzie Google Bard AI; Bard opracował studia przypadków, które nigdy nie miały miejsca, co Polli przytoczyła jako przykłady, dlaczego potrzebna jest reforma strukturalna.

"Zamiast próbować naprawić wszystkie problemy z generatywną sztuczną inteligencją, ludzie po prostu idą naprzód, aby uczynić tę technologię potężniejszą z różnych powodów. To właśnie filozofia działaj szybko i psuj rzeczy okazała się być problematyczna" - powiedział Polli.

Modele LLM, które zasilają ChatGPT, Bard, Claude i inne platformy genAI, zostały również oskarżone o pobieranie z internetu dzieł sztuki, książek i filmów chronionych prawem autorskim - wszystko to jest pożywką do szkolenia modeli. Douglas Preston i 16 innych autorów, w tym George R.R. Martin, Jodi Piccoult i Jonathan Franzen, oskarżyli GPT o pochłanianie ich dzieł bez ich zgody; pozwali OpenAI o naruszenie praw autorskich.

Technolodzy pomagają artystom walczyć z tym, co postrzegają jako kradzież własności intelektualnej (IP) za pomocą narzędzi genAI, których algorytmy szkoleniowe automatycznie przeszukują internet i inne miejsca w poszukiwaniu treści. Jedna z broni, zwana "atakami zatruwającymi dane", manipuluje danymi szkoleniowymi LLM i wprowadza nieoczekiwane zachowania do modeli uczenia maszynowego. Technologia ta, zwana Nightshade, wykorzystuje "maskowanie", aby oszukać algorytm szkoleniowy genAI, aby uwierzył, że otrzymuje jedną rzecz, podczas gdy w rzeczywistości przyjmuje coś zupełnie innego.

Nowy Jork uchwalił lokalną ustawę 144, znaną również jako ustawa o audycie stronniczości, która wymaga od organizacji zatrudniających informowania kandydatów do pracy, że wykorzystywane są algorytmy AI automatyzujące proces; firmy te muszą zlecić stronie trzeciej przeprowadzenie audytu oprogramowania w celu sprawdzenia stronniczości.

Czy generatywna sztuczna inteligencja wyeliminuje twoją pracę?

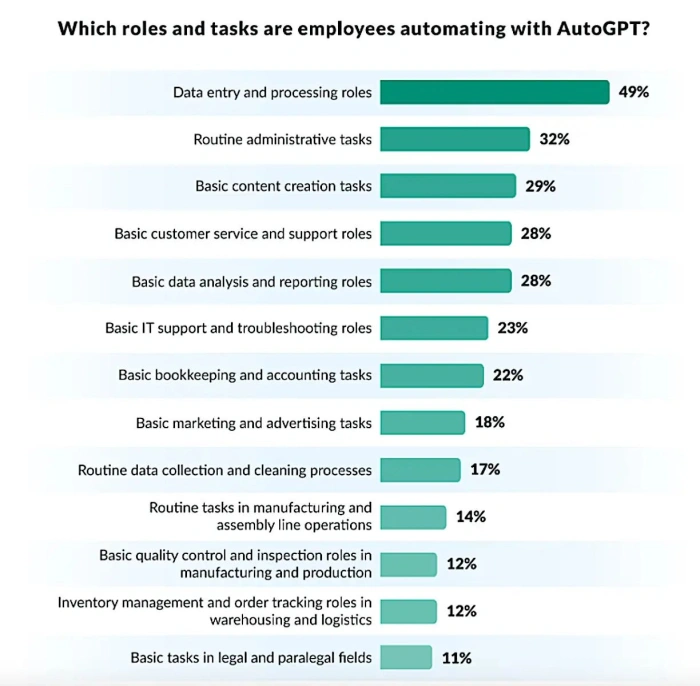

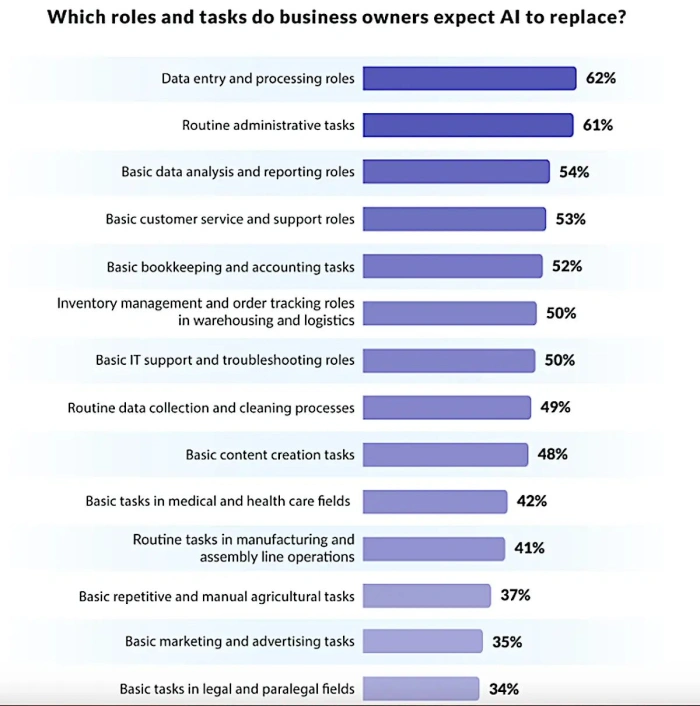

Pojawiły się również obawy, że ChatGPT i inne podobne narzędzia wyeliminują ogromne obszary rynku pracy poprzez automatyzację wielu zadań. Jednak większość analityków, ekspertów branżowych i liderów IT szydzi z groźby utraty miejsc pracy, utrzymując zamiast tego, że genAI już zaczęła pomagać pracownikom, wykonując przyziemne zadania, uwalniając ich do wykonywania bardziej kreatywnych, opartych na wiedzy zadań.

"Jedynym scenariuszem, w którym sztuczna inteligencja odbiera wszystkie miejsca pracy, jest ten, w którym zostaje uwolniona bez żadnego ludzkiego nadzoru" - powiedziała Polli. "Myślę, że wszyscy będziemy musieli wiedzieć, jak z niej korzystać, aby odnosić większe sukcesy w naszej pracy; to jasne. Będziesz musiał nauczyć się nowej technologii, tak jak musiałeś nauczyć się poczty e-mail, korzystania z internetu lub smartfona. Ale nie sądzę, że będzie to niszczyciel miejsc pracy".

Cliff Jurkiewicz, wiceprezes ds. globalnej strategii w Phenom, platformie pozyskiwania talentów opartej na sztucznej inteligencji, powiedział, że osobiści asystenci, którzy działają na genAI, staną się tak rutynowym rozwiązaniem, jak telefon.

"Będą wiedzieć o nas wszystko, im więcej dostarczymy im danych. Ponieważ żyjemy w ekosystemie zastępowania zadań, co-bot będzie wykraczał daleko poza ustalanie terminów w kalendarzu, tak jak robią to teraz Siri i Alexa, łącząc wszystkie zadania w naszym życiu i zarządzając nimi" - powiedział Jurkiewicz.

Previn z Cisco zgodził się, mówiąc, że w ciągu ostatniego roku stało się jaśniejsze, że generatywna sztuczna inteligencja będzie członkiem zespołu, który "siedzi na twoim ramieniu", a nie zabójcą zabijającym miejsca pracy. Wiara w to, że jakakolwiek technologia całkowicie wyeliminuje miejsca pracy, jest błędem opartym na koncepcji skończonego tortu pracy.

"Wierzę, że będzie to mnożnik siły, który zwiększy produktywność, odciąży od wykonywania prostych zadań i zasadniczo zwiększy tort" - powiedział Previn. "Dwadzieścia lat temu nie było czegoś takiego jak programista aplikacji mobilnych. Technologia tworzy nowe możliwości i role, i myślę, że to właśnie zaczynamy widzieć w przypadku sztucznej inteligencji".

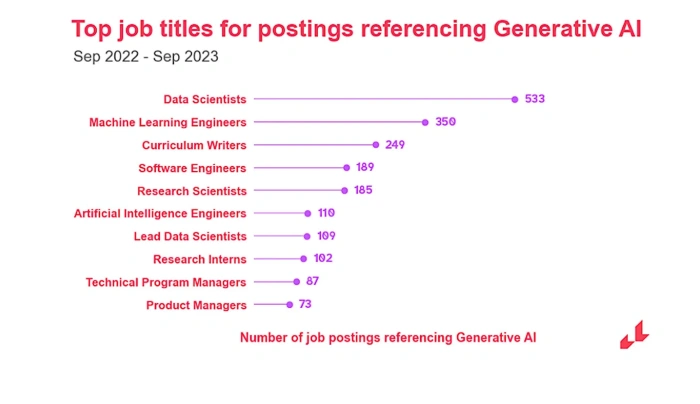

W rzeczywistości liczba ofert pracy wymagających umiejętności związanych z genAI wzrosła o 1848% w 2023 r., ponieważ firmy pracują nad rozwojem nowych aplikacji AI, zgodnie z niedawną analizą rynku pracy Lightcast.

Dane Lightcast pokazują, że w 2022 r. było tylko 519 ofert pracy wymagających wiedzy z zakresu generatywnej sztucznej inteligencji. Do tej pory w 2023 r., od debiutu ChatGPT, pojawiło się 10 113 ogłoszeń dotyczących genAI i ponad 385 000 ogłoszeń dotyczących wszystkich form ról związanych ze sztuczną inteligencją.

Według Lightcast, najlepsi pracodawcy w obszarze genAI to m.in. aplikacja Fud, firma edukacyjna Chegg, Meta, Capital One i Amazon. "Pokazuje to szeroki zakres organizacji pracujących nad integracją tej technologii ze swoimi usługami" - powiedziała Layla O'Kane, starsza ekonomistka Lightcast.

"Dodanie nowej umiejętności do opisów stanowisk jest często oznaką, że firma przeszła od eksperymentowania z nową technologią do podjęcia prawdziwego strategicznego zaangażowania w nią" - powiedziała O'Kane. "Obecnie wiele organizacji wciąż znajduje się na etapie eksperymentów. Jednak w miarę podejmowania przez nie kluczowych decyzji biznesowych, lista ta może się wydłużać".

Naturalną konsekwencją prawdziwie przełomowej technologii, jaką jest sztuczna inteligencja, jest tworzenie zupełnie nowych ról zawodowych, powiedział Jurkiewicz.

Te nowe role będą obejmować:

AI Ethicist (koncentrujący się na etycznym korzystaniu z narzędzi)

Kurator AI

Twórca polityki i doradca prawny

Trener (szybki inżynier)

Audytor

Tłumacz (ktoś, kto tłumaczy, w jaki sposób wykorzystywana jest technologia)

Zaskakujące przypadki użycia ChatGPT

Previn nigdy nie wierzył, że AI dotknie roli programisty, która - jego zdaniem - jest rodzajem sztuki wymagającej wyjątkowych zdolności twórczych. ChatGPT był jednak biegły w tworzeniu kodu, który zajmuje się higieną i bezpieczeństwem danych korporacyjnych i może ponownie wykorzystywać kod do tworzenia nowych aplikacji.

Badanie przeprowadzone przez Microsoft wykazało, że narzędzie GitHub Copilot, które jest obsługiwane przez ChatGPT, może pomóc programistom kodować do 55% szybciej - a ponad połowa całego kodu sprawdzanego obecnie w GitHub była wspomagana przez sztuczną inteligencję w jego rozwoju. Oczekuje się, że liczba ta wzrośnie do 80% całego kodu sprawdzanego w GitHub w ciągu najbliższych pięciu lat, według dyrektora generalnego GitHub Thomasa Dohmke.

"To bardzo interesujące, ponieważ w przeszłości nie było sposobu na skrócenie czasu tworzenia oprogramowania" - powiedział Previn. "Teraz okazuje się, że można znacznie przyspieszyć tempo, pomagając programistom w takich rzeczach jak Copilot do czytania kodu, higieny kodu, bezpieczeństwa, komentowania".

Previn twierdzi jednak, że wiedza o tym, jaki kod został, a jaki nie został dotknięty przez sztuczną inteligencję, będzie miała kluczowe znaczenie dla zaufania w przyszłości. Powinno być wymagane, aby każdy kod wygenerowany przez sztuczną inteligencję był oznaczony znakiem wodnym i sprawdzany przez co najmniej dwie osoby. "Człowiek powinien być w to włączony" - powiedział. (Przez "znak wodny" Previn miał na myśli albo dołączenie metadanych, albo po prostu stwierdzenie we fragmencie kodu, że sztuczna inteligencja pomagała w jego tworzeniu).

Zdolność GenAI do opracowywania lub projektowania oprogramowania zmieniła również wewnętrzny system informatyczny Cisco i zewnętrzną strategię produktową. Od listopada ubiegłego roku dział IT Previna opracował bardziej "w pełni ukształtowaną strategię" w zakresie sztucznej inteligencji jako podstawowej infrastruktury.

Źródło: Lighcast

Wewnętrznie oznacza to wykorzystanie sztucznej inteligencji do znalezienia ulepszeń produktywności, w tym obszarów takich jak zautomatyzowane funkcje pomocy technicznej. Zewnętrznie, Cisco myśli teraz w kategoriach tego, jak "wykorzystać AI w każdym portfolio produktów i rozszerzyć cały cyfrowy majątek, którym zarządzamy w cyfrowym IT".

"W jaki sposób możemy lepiej wspierać naszych klientów, skracając czas potrzebny im na uzyskanie odpowiedzi?" powiedział Previn. "Następnie [ważne jest, aby mieć] zasady, bezpieczeństwo i prawne [bariery], aby móc bezpiecznie przyjąć i wykorzystać możliwości sztucznej inteligencji, które inni dostawcy wprowadzają do narzędzi innych osób. Można sobie wyobrazić wszystkich dostawców SaaS..., wszyscy są w tej podróży. Ale czy jesteśmy przygotowani, aby skorzystać z tej podróży w sposób zgodny z naszymi odpowiedzialnymi zasadami dotyczącymi sztucznej inteligencji?".

Poza generowaniem kodu, genAI została szybko przyjęta w dziedzinie narzędzi testowych i zautomatyzowanej jakości oprogramowania. "Obserwujemy również konwergencję generatywnej sztucznej inteligencji i predykcyjnego wykorzystania sztucznej inteligencji" - powiedział Jyoti z IDC.

Ludzki nadzór pozostaje kluczowy

W ciągu najbliższych trzech lat, genAI będzie musiała znacznie zmniejszyć i ograniczyć halucynacje i inne niepożądane wyniki, aby organizacje mogły niezawodnie wykorzystywać ją do podejmowania decyzji i procesów. Jej zastosowanie w świecie rzeczywistym musi dojrzeć do tego, co Litan nazwał "przypadkami użycia zmieniającymi zasady gry", w przeciwieństwie do zwykłego korzystania z genAI w celu osiągnięcia wyższej wydajności i produktywności.

Litan uważa, że możliwości multimodalne znacznie się rozszerzą. (Multimodalna sztuczna inteligencja może przetwarzać, rozumieć i generować dane wyjściowe dla więcej niż jednego typu danych).

"Najważniejsze jest to, że nie można po prostu umieścić ChatGPT lub genAI na autopilocie" - powiedziała. "Musisz sprawdzać odpowiedzi pod kątem halucynacji, niedokładnych wyników, błędów i dezinformacji. Aby to zrobić, potrzebujesz narzędzi do wyróżniania podejrzanych transakcji i ręcznego ich sprawdzania".

Jest to jednak miecz obosieczny, ponieważ nowe narzędzia i procesy oznaczają dodatkowe wydatki, które zmniejszają potencjalny zwrot z inwestycji. Jednak bez tego rodzaju kontroli wyjątków, organizacje będą kierowane w stronę błędnego podejmowania decyzji, procesów i komunikacji.

Inną kwestią związaną z przyszłością genAI jest samoświadomość lub coś, co nazywa się ogólną sztuczną inteligencją - kiedy sztuczna inteligencja nie potrzebuje już ludzkiego wkładu, aby myśleć.

Jurkiewicz z Phenom uważa, że ogólna sztuczna inteligencja zacznie w niedalekiej przyszłości wykazywać podobne do ludzkich, "niemal infantylne reakcje na doświadczenia". "Zaczniemy widzieć niektóre z nich w przyszłym roku, ponieważ coraz więcej osób korzysta z tej technologii.

"Wcześniej sztuczna inteligencja nie mogła odpowiadać na niektóre pytania, ponieważ została zaprogramowana przez człowieka, aby nie odpowiadać" - kontynuował Jurkiewicz. "Sztuczna inteligencja dojdzie do punktu, w którym będzie mogła podejmować decyzje dotyczące tego, co uważa za stosowne. Ludzie nie mogą jej kontrolować, chyba że ją wyłączą".

Artykuł pochodzi z Computerworld.com