Techniki zwiększania efektywności

-

- 16.01.2012, godz. 13:00

Deduplikacja i optymalizacja łączy WAN to dwa sposoby zwiększania efektywności systemów IT, które do niedawna były wykorzystywane głównie w dużych systemach korporacyjnych, a ostatnio zaczynają się pojawiać w ofercie adresowanej również do segmentu MSP.

Stosowanie mechanizmów deduplikacji lub optymalizacji WAN może przynieść oszczędności, choć zależy to od wykorzystywanych aplikacji. Modernizując lub rozbudowując system IT, na pewno nie należy z góry wykluczać możliwości zastosowania tych technik nawet w małych firmach. Zwłaszcza, że obecnie na rynku dostępne są dedykowane dla tego segmentu pamięci masowe wyposażone w oprogramowanie do deduplikacji, a także usługi optymalizacji łączy internetowych i akceleracji dostępu do aplikacji.

Deduplikacja

Deduplikacja to technika eliminacji powtarzających się (zduplikowanych) informacji przez oprogramowanie, które analizuje zawartość plików lub bloków danych i zapisuje w pamięci lub przesyła w sieci tylko unikalne treści oraz odpowiednie odnośniki do powtarzających się elementów.

Zobacz również:

- Wyjaśniamy czym jest SD-WAN i jakie są zalety tego rozwiązania

- Sztuczna inteligencja pomaga rozwiązywać problemy z sieciami

Zastosowanie deduplikacji w systemach do backupu pozwala czasami nawet na 50-krotne zmniejszenie zapotrzebowania na pojemność pamięci masowej niezbędnej do przechowywania kopii zapasowych. Technologia ta sprawdza się też jako mechanizm eliminacji powtórzeń w każdym rodzaju plików, np. załącznikach poczty elektronicznej, kopiach dokumentów tekstowych, arkuszy, obrazów graficznych itp., choć tutaj jej efektywność jest znacznie niższa.

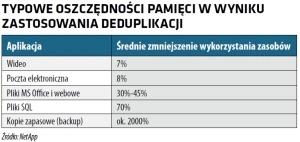

Typowe oszczędności pamięci w wyniku zastosowania deduplikacji

Oprogramowanie deduplikacyjne jest instalowane w pobliżu źródła danych, a więc na serwerze, który analizuje informacje i przesyła do pamięci masowej tylko informacje, które uległy modyfikacji. Tego typu rozwiązanie wymaga odpowiednio dużej mocy obliczeniowej, ale jednocześnie pozwala na istotne zmniejszenie wymagań dotyczących przepustowości sieci.

Innym rozwiązaniem jest przesyłanie plików do repozytorium danych i dopiero tam analiza i eliminacja powtarzających się informacji przed ich zapisem w pamięci masowej. To pozwala na odciążenie serwerów od konieczności wykonywania obliczeń, lecz powoduje wzrost obciążenia sieci.