Statystyczna jakość

-

- Tomasz Greber,

- 14.04.2003

Karta kontrolna jest narzędziem, które w sposób ciągły (na zasadzie online) pozwala oceniać, czy proces przebiega w warunkach stabilnych (tzn. czy nie jest zakłócany czynnikami zewnętrznymi, które należy zidentyfikować i dla dobra procesu usunąć). Ze statystycznego punktu widzenia karta ta jest serią prowadzonych testów statystycznych badających istotność różnicy średniej z próbki i średniej procesu.

Karty takie są bardzo dobrym sposobem na zapewnienie ciągłej kontroli procesu i są coraz częściej wymagane przez klientów jako zapis potwierdzający odpowiednią jakość kupowanych przez nich wyrobów. W przypadku procesów produkcyjnych są narzędziem w rękach operatorów, pozwalającym im na właściwe sterowanie obsługiwanymi przez nich procesami.

Dobre programy pozwalają nie tylko na wykreślanie kart kontrolnych, ale wspomagają także identyfikowanie pojawiających się w procesie zakłóceń, takich jak trendy. Co więcej, aplikacje mogą być zaprogramowane tak, aby w przypadku nieprawidłowego zachowania się procesu wymusić na operatorze podanie przyczyny problemu oraz podjętych przez niego działań. Mogą poza tym w przypadkach alarmowych uruchamiać oddzielnie stworzone aplikacje, które np. wysyłają informacje do osób odpowiedzialnych za proces (np. poprzez SMS) lub zatrzymują proces.

Zgodność z wymaganiami

Ocenę jakości wyrobów z wykorzystaniem metod statystycznych można prowadzić na dwa sposoby. Pierwszy to stosunkowo często spotykana w polskich przedsiębiorstwach statystyczna kontrola odbiorcza. Na popularności zyskuje jednak również obliczanie wskaźników zdolności procesów.

Statystyczna kontrola jakości w podstawowej wersji nie wymaga wspomagania komputerowego. Jest wyczerpująco opisana m.in. w Polskich Normach, w których podano tabele pozwalające wyznaczyć odpowiednią wielkość próbki oraz podjąć decyzję dotyczącą przyjęcia lub odrzucenia kontrolowanej partii wyrobów.

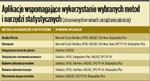

Aplikacje wspomagające wykorzystanie wybranych metod i narzędzi statystycznych

W przypadku oceny zdolności procesów trzeba sprawdzić wiele założeń, które powinny spełniać zebrane dane. W ogólnym przypadku wyniki muszą pochodzić z procesu uregulowanego statystycznie i być zgodne z rozkładem normalnym. Sprawdzanie takich założeń bez użycia komputera może być nieco pracochłonne, choć - co należy wyraźnie zaznaczyć - nie niemożliwe do zrealizowania.

Dostępne w wielu programach testy (np. w Shapiro-Wilka czy Kołmogorowa-Smirnowa) lub prosta metoda graficzna pozwalają łatwo podjąć decyzję o normalności rozkładu. Wykorzystane przy analizie danych karty kontrolne umożliwiają z kolei ocenę stabilności badanego procesu. Co w przypadku, gdy podane założenia nie są spełnione? Wtedy sprawa się komplikuje, gdyż nie można stosować standardowych wzorów i zazwyczaj wychodzić należy od skośności, kurtozy oraz percentyli rozkładu, co bez wykorzystania komputera w praktyce zarządzania procesem produkcyjnym jest już właściwie niewykonalne (głównie z uwagi na czas potrzebny na obliczenia).

Badanie niewiadomego

Planowanie eksperymentów (Design of Experiments - DOE) jest metodą lub raczej grupą metod statystycznych, które stosuje się w celu uzyskania jak największej ilości informacji o badanym procesie na podstawie jak najmniejszej liczby przeprowadzonych eksperymentów. DOE zostało stworzone w latach dwudziestych XX w. Z technicznego punktu widzenia owocem DOE jest matematyczny model opisujący zależności pomiędzy wielkościami wejściowymi procesu (ustawieniem maszyny, rodzajem surowca, itp.) a wielkościami wyjściowymi (którymi zazwyczaj są określone parametry wyrobu) i jego statystyczna weryfikacja.

Planowanie eksperymentów zostało rozwinięte głównie przez dwóch naukowców: Genichi Taguchiego oraz Doriana Shainina. Stworzyli oni dwa różniące się między sobą podejścia, które zmierzają jednak do wspólnych celów. Wśród nich najważniejsze (zestawienie za opracowaniami Adama Hamrola i Władysława Mantury Zarządzanie jakością. Teoria i praktyka wydanej przez Wydawnictwo Naukowe PWN w 1998 r. oraz książką R. Coulcott Statistics in Research and Development, której drugie wydanie opublikował Chapman and Hall w 1991 r.) to:

- znalezienie czynników sterowalnych (parametrów procesu, którymi można sterować), najsilniej oddziałujących na jakość procesu lub wyrobu;

- znalezienie czynników sterowalnych, które pozwalają skuteczniej ograniczać zmienność poziomu jakości;

- określenie optymalnego ustawienia czynników sterowalnych, przy którym uzyskuje się wymaganą jakość i maksymalną odporność wyrobu lub procesu na działanie zakłóceń;

- znalezienie czynników, które mają minimalny (pomijalny) wpływ na jakość procesu lub wyrobu i ustalenie ich na poziomie wynikającym z kryteriów ekonomicznych (można tutaj "rozluźnić" granice tolerancji);

- ustalenie takiego ustawienia czynników, które będzie redukować koszty bez niekorzystnego wpływu na jakość.