Rynek centrów danych zmierza ku chmurze

-

- 14.02.2018, godz. 00:29

Wartość i dojrzałość polskiego rynku centrów danych stale wzrastają. Dostawcy komercyjnych ośrodków przetwarzania danych coraz chętniej oferują usługi w chmurze obliczeniowej oraz możliwość ich wygodnej integracji z lokalnymi zasobami klientów. Ci modernizują własne zaplecza IT, rozwijając hybrydowe środowiska oparte na kombinacji chmur prywatnych i publicznych.

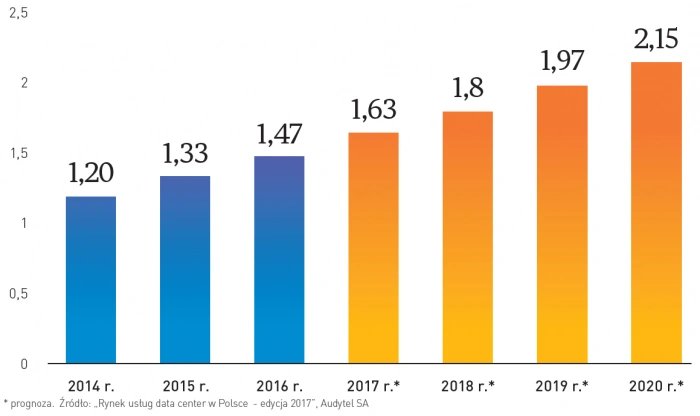

Według szacunków specjalizującej się w rynku centrów danych firmy Audytel, wartość polskiego rynku data center wyniosła w 2016 r. 1,47 mld zł, tj. o 10,7% więcej, niż rok wcześniej (1,33 mld zł). Podobna dynamika będzie utrzymywała się jeszcze przynajmniej do 2020 r., a napędzać będą ją wzrastające potrzeby polskich przedsiębiorstw, dotyczące różnorodności usług, ich dojrzałości czy poziomu bezpieczeństwa.

Całkowita wartość rynku usług Data Center i usług powiązanych w latach 2014-2020 [mld zł]

Polski rynek centrów danych wciąż pozostaje rozdrobniony zarówno pod kątem wielkości obiektów, jak i liczebności dostawców czy zakresu usług. Na koniec 2016 r. w Polsce działało ponad 80 komercyjnych centrów danych, których łączna powierzchnia IT wyniosła w tym okresie ok. 79 tys. m2. Zarazem powierzchnia większości ośrodków przetwarzania danych w Polsce nie przekracza 1000 m2. Obok największych, wyspecjalizowanych dostawców, takich jak: 3S, ATM, Beyond, Equinix, Exatel, OVH, Polcom, Sinersio czy Talex, oraz ofert centrów danych udostępnianych przez operatorów telekomunikacyjnych (Orange, T-Mobile) funkcjonuje cała rzesza mniejszych, regionalnych podmiotów, oferujących niższej jakości usługi adresowane do mniej wymagających klientów.

Zobacz również:

- AI ma duży apetyt na prąd. Google znalazł na to sposób

- Cyfrowa transformacja z AI - co nowego na Google Cloud Next 24

Dynamiczny rozwój i konsolidacja rynku centrów danych w Polsce

„Wśród dostawców prognozuję na 2018 r. dwa główne trendy: szukanie możliwości do zapełnienia wolnej przestrzeni oraz konsolidację” – mówi Grzegorz Bernatek, analityk Audytela. „Równocześnie dostawcy data center cały czas pracują nad zwiększeniem oferty z większą wartością dodaną (VPS, PaaS i SaaS)”.

Daniel Szcześniewski, dyrektor Pionu Strategii i Marketingu, Atman

W ostatnich latach oczekiwania i wybory klientów szeroko ro¬zumianego IT zmieniły się zasadniczo, co znajduje odzwierciedlenie w stałym dostosowywaniu i rozwijaniu oferty operatorów data center. Kiedyś firmy głównie kupowały produkty „pudełkowe”, o niskiej złożoności, korzystając najczęściej z wielu dostawców. Działy IT poświęcały mnóstwo czasu i energii na samodzielne tworzenie rozwiązań data center utrzymywanych wewnątrz firm, uzupełnianych usługami telekomunikacyjnymi.

Dziś te same firmy stawiają raczej na outsourcing – wolą być klientami centrum danych, dzięki czemu mają do dyspozycji rozbudowany stos rozwiązań IT, z których mogą korzystać w formie usługi. Kluczowy jest dostęp do architektury IT w spersonalizowanej konfiguracji, złożonej z dowolnych warstw stosu. Klienci oczekują więc złożonego pakietu usług przygoto-wanego pod konkretne zastosowanie – i najchętniej przez jednego dostawcę. Lubią mieć wybór, wręcz go wymagają, stąd wiele centrów danych działa w modelu carrier neutral. Jednak finalnie większość klientów woli korzystać z kompleksowej obsługi jednego dostawcy szyjącego rozwiązania na miarę.

Preferencje klientów sprawiają, że data center to obecnie złożony ekosystem usług IT: kolokacji, serwerów dedykowanych, dostępu do internetu, usług bezpieczeństwa, tzw. managed services czy wreszcie chmury. Ta ostatnia zajmuje coraz istotniejszą pozycję w ofercie DC w Polsce – mimo zmasowanego ataku globalnych dostawców chmur publicznych, takich jak: AWS, Google Cloud czy Azure. Polskie firmy chętnie wybierają usługi cloudowe od lokalnych operatorów, zwykle w postaci chmur hybrydowych, prywatnych czy tzw. virtual private cloud. Ich mocną stroną jest m.in. dużo lepsza obsługa klienta i indywidualne podejście. Istotna jest też lokalizacja infrastruktury clouda w kraju, ze względu na przepisy o ochronie danych osobowych. Doceniając rosnącą popularność i niebagatelną rolę clouda w stosie rozwiązań IT, dokonaliśmy całkowitej przebudowy naszej platformy chmurowej i z początkiem roku wystartowaliśmy z nową ofertą.

Warto odnotować, że ostatnio na cloud computing otwiera się też sektor finansowy, historycznie ostrożny wobec tego modelu przetwarzania danych. Zasadnicze w tym znaczenie ma głos zabierany przez instytucje nadzorujące rynek, takie jak zeszłoroczny komunikat KNF dotyczący wykorzystania chmur obliczeniowych w działalności podmiotów nadzorowanych. Jako operator DC trzymamy rękę na pulsie i dostosowujemy swoje usługi tak, aby klientom ułatwić spełnianie wytycznych płynących z nowych aktów prawnych, regulacji czy rekomendacji instytucji nadzorujących. Już dziś widzimy, że jest to dostrzegane przez małej i średniej wielkości firmy z sektora finansowego (np. fintechy), które doceniają nasze rozumienie ich sytuacji i stopniowo otwierają się na wykorzystanie zewnętrznych chmur.

Konsolidacja postępować będzie przede wszystkim wokół dużych dostawców, już teraz posiadających największe udziały w rynku centrów danych, ponieważ tę branżę cechują stosunkowo wysokie bariery wejścia. Wynikają one m.in.: z czaso- i kosztochłonności inwestycji, wysokich wymagań dotyczących parametrów centrum danych czy konieczności zapewnienia dużej liczby punktów styku sieci, która umożliwi zabezpieczenie wydajnej transmisji danych. Wyzwaniem są także narastające trudności w dostępie do wykwalifikowanej kadry inżynierskiej i specjalistów IT oraz rola reputacji i możliwości pochwalenia się referencjami, zwłaszcza że wybór centrum danych oznacza w praktyce związanie się z danym dostawcą na dłuższy czas.

Według Audytela, w ciągu najbliższych pięciu lat powierzchnia IT komercyjnych centrów danych w Polsce wzrośnie o blisko połowę, przy czym granicę 100 tys. ma przekroczyć już w 2019 r. Nowopowstające centra danych zapewniają coraz wyższy poziom dostępności, bezpieczeństwa i takich parametrów, jak sprawność energetyczna oraz redundancja źródeł zasilania czy dostępu do sieci. Wiele z otwieranych obecnie ośrodków przetwarzania danych jest ponadto zauważalnie większych niż obiekty powstające wcześniej – ich powierzchnia często przekracza 1 tys. m2. Są one od razu tworzone z myślą o dalszej rozbudowie (skalowalności) w przyszłości.

Według wydanego w styczniu 2018 przez Ministerstwo Cyfryzacji „Raportu o cyfryzacji kraju”, polskie jednostki publiczne dysponują aż 321 centrami przetwarzania danych, z czego jedynie 5% (16 obiektów) spełnia nowoczesne standardy. Zdecydowana większość to serwerownie urządzone w zaadaptowanych w tym celu pomieszczeniach wewnątrz budynków wykorzystywanych przez administrację publiczną, które nie spełniają wymaganych standardów technicznych (brak redundantnego zasilania, systemów przeciwpożarowych itp.). Utrzymanie infrastruktury teleinformatycznej w samej tylko administracji rządowej kosztuje rocznie ok. 450 mln zł, tymczasem wg resortu cyfryzacji rachunek ten zgodnie z aktualnymi stawkami rynkowymi nie powinien przekraczać… 100 mln zł.

Mając na względzie konieczność zoptymalizowania kosztów oraz zwiększenia wydajności i bezpieczeństwa infrastruktury IT, Ministerstwo Cyfryzacji uruchomiło projekty Wspólnej Infrastruktury Państwa (WIP) oraz Prywatnej Chmury Administracji Publicznej. Docelowo w Rządowym Klastrze Bezpieczeństwa znajdzie się sześć centrów przetwarzania danych (zamiast obecnych 321). Koszty ich obsługi mają zamknąć się w kwocie ok. 120 mln zł.

Dostawcy centrów danych rozwijają portfel usług

Dynamiczny rozwój rynku komercyjnych centrów danych wynika z rosnącego zapotrzebowania klientów. Wzrasta przy tym zainteresowanie nie tylko tradycyjnymi usługami, takimi jak: kolokacja, hosting czy dedykowane serwery, ale również dojrzałymi usługami o wartości dodanej. Dostawcy, zwłaszcza najwięksi, starają się więc nadążyć za popytem, kierując na rynek coraz bardziej rozbudowane oferty. W efekcie hosting można łatwo zastąpić rozwiązaniami VPS (Virtual Private Server), a coraz częściej wygodnymi, chmurowymi usługami IaaS czy PaaS. Dla wymagających klientów dostawcy centrów danych udostępniają rozwiązania do budowy środowisk hybrydowych, a więc łączących firmowe serwery, rozwiązania dedykowane oraz chmury publiczne i prywatne, niezależnie od ich lokalizacji. Pojedynczy panel klienta umożliwia w tym przypadku proste zarządzanie całością posiadanych zasobów IT.W ramach mechanizmów zapewniania ciągłości działania (Business Continuity) i wysokiej dostępności (High Availability) operatorzy ośrodków przetwarzania danych oferują już nie tylko różne rodzaje backupu (pełny, różnicowy, przyrostowy, migawkowy), ale także replikację asynchroniczną lub synchroniczną do położonych w innych lokalizacjach centrów danych. Coraz częstszym elementem oferty są także pełnozakresowe wsparcie zespołu inżynierów (w trybie 24/7/365) oraz usługi zarządzane i administracja wybranymi środowiskami IT (hypervisor, systemy operacyjne, bazy danych etc.). Profesjonalni dostawcy centrów danych rozszerzają ponadto mechanizmy bezpieczeństwa, wdrażając takie rozwiązania jak chmurowe platformy anty-DDoS.

Bezpieczeństwo, wysoki stopień redundancji oraz korzyści wynikające ze skali działalności to oczywiste przewagi konkurencyjne dużych, komercyjnych dostawców centrów danych. Osiągnięcie zbliżonego poziomu wymienionych parametrów w ramach własnego, firmowego ośrodka przetwarzania danych, wiązałoby się z koniecznością poniesienia wielomilionowych nakładów finansowych, co jest w zasadzie nieosiągalne dla większości polskich przedsiębiorstw, nie wspominając już o zasadności takich inwestycji.

Dojrzewanie i profesjonalizacja wachlarza usług oferowanego przez komercyjne centra danych będą napędzane rosnącymi potrzebami i świadomością klientów. Nowe i coraz bardziej zaawansowane pakiety usług centrów danych będą także efektem rozszerzania się struktury branżowej klientów oraz wzrostem ich potrzeb. O ile dotychczas większość (wg Audytela – ok 60%) przychodów komercyjnych centrów danych generowały usługi świadczone na rzecz podmiotów wywodzących się z sektorów finansowego oraz telekomunikacyjnego, o tyle w najbliższych latach wzrastać będzie udział małych i średnich przedsiębiorstw (MŚP). Wraz z postępującą cyfryzacją zarówno wewnętrznych, jak i zewnętrznych procesów, czy też rosnącą popularnością usług generujących wielkie wolumeny danych (streaming wideo, muzyki, media społecznościowe, e-handel etc.) firmy będą potrzebowały coraz bardziej zaawansowanych i skalowanych rozwiązań IT. Czynniki wpływają zwłaszcza na rozwój tych usług, które budowane są na bazie chmur obliczeniowych. To kierunek, w którym coraz śmielej zmierzają dostawcy data center.

Paweł Pytlakowski, Kierownik Działu Marketingu i Rozwoju Produktów ICT, T-Mobile Polska SA

Zapewnienie bezpieczeństwa oraz ciągłości działania aplikacji i systemów informatycznych to jedne z najważniejszych priorytetów działów IT. Jest to szczególnie trudne wyzwanie, jeśli weźmiemy pod uwagę rosnące potrzeby biznesowe, a co za tym idzie, koszty utrzymania IT w firmach.

Przez długie lata obawa przed utratą kontroli i obniżeniem poziomu bezpieczeństwa stanowiły główne bariery dla outsourcingu zasobów IT i przekazania ich do zewnętrznego data center. Obecnie obserwujemy odwrotny trend – klienci coraz bardziej doceniają zalety współpracy z zaufanym operatorem zewnętrznym, jakim jest T-Mobile.

Składa się na to kilka powodów:

Po pierwsze, klienci, którzy koncentrują się na budowaniu własnego biznesu, coraz chętniej poszukują wiedzy eksperckiej, a my posiadamy specjalistyczne kompetencje w dziedzinie utrzymania data center, wirtualizacji zasobów, sieci dostępowej oraz utrzymywania zaawansowanych systemów IT. W Grupie DT mamy 60 data center z 70 000 m2 do dyspozycji klientów w Europie Centralnej. T-Mobile dysponuje w Polsce sześcioma data center i utrzymuje powierzchnię ponad 8000 m2, na realizację usługi kolokacji, hostingu i zaawanso¬wanych rozwiązań typu cloud computing.

Po drugie, jesteśmy operatorem telekomunikacyjnym, więc możemy zapewnić naszym klientom kom¬pleksowość usług – od dostępu do mocy obliczeniowej i storage po szerokopasmowe łącza oraz zaawansowane usługi bezpieczeństwa, m.in. ochrona przed atakami DDoS, Zarządzany Firewall i Zarządzamy Firewall Aplikacyjny, a także Security Operation Center (SOC) z ekspertami bezpieczeństwa monitorującymi incydenty bezpieczeństwa i przeciwdziałającymi im w trybie 24/7. Tego klienci nie znajdą u firm oferujących tylko data center i IT. Są to usługi, które dostarczyć może jedynie operator telekomunikacyjny klasy T-Mobile.

Więcej informacji na temat usług centrum danych T-Mobile jest dostępnych pod adresem: kolokacja-serwerow.biz.pl

Według Audytela, najwięcej komercyjnych centrów przetwarzania danych (40%) znajduje się w Warszawie i jej bliskim sąsiedztwie: Piasecznie, Sękocinie, Błoniu, Grodzisku Mazowieckim. Koncentracja na rynku warszawskim jest pochodną specyfiki głównych odbiorców usług oferowanych przez dostawców centrów danych, tj. przede wszystkim przedsiębiorstw z sektora finansowego oraz operatorów telekomunikacyjnych, którzy prowadzą biznes ze stolicy. Polskie firmy nie są przyzwyczajone do wykorzystywania ośrodków w innych miastach niż te, w których mieści się ich główna siedziba (czy polski oddział). Między innymi z tego powodu 3S Data Center, dostawca dotąd skoncentrowany na południu Polski, otworzył niedawno nowe centrum danych na warszawskim Annopolu.

Dużym ośrodkiem skupiającym centra danych jest także Kraków (12%) i jego bliskie okolice, np. Skawina. Na dalszych miejscach plasują się: Trójmiasto i Poznań (po 7%) oraz Łódź i Katowice (po 6%). Pozostałe centra danych rozproszone są po reszcie kraju, przy czym jedynie nieliczne z nich w oddaleniu od największych aglomeracji (co notabene jest korzystne zarówno dla bezpieczeństwa, jak i kosztów). W tyle pod względem usytuowania komercyjnych centrów danych pozostaje wschodnia część Polski.

Akcenty przesuwają się ku chmurze

„Oczekiwania klientów stale rosną, szczególnie w kontekście wdrożenia w firmie cloud computingu lub migracji od innego dostawcy. Objawia się to nie tylko w wielu audytach i wizytach kontrolnych, które odbywają się w Data Center 2 Beyond.pl, ale także w skrupulatności klientów przy porównywaniu ofert” – mówi Michał Grzybkowski, prezes zarządu Beyond. „W kontekście chmury obliczeniowej na pewno dużo większą rolę niż w przypadku kolokacji odgrywa otwartość operatora centrum danych na realne potrzeby klientów. Konfiguracji infrastruktury cloudowej może być mnóstwo, dlatego tak ważne jest, aby jeszcze bardziej wsłuchiwać się w oczekiwania klientów i być ich zaufanym doradcą na każdym etapie rozmów biznesowych”.

Zalety chmury obliczeniowej są znane: elastyczność, wysoka niezawodność, prostota uruchomienia i użytkowania oraz potencjalna redukcja kosztów. Liczba dostępnych rozwiązań chmurowych oraz stopień ich dojrzałości stale się zwiększają, a rosnące zainteresowanie cloud computingiem przekłada się na zmiany w ofercie dostawców centrów danych oraz potrzeby formułowane przez klientów. Przykładowo coraz częstszą alternatywą dla kolokacji staje się zakup usługi IaaS (Infrastructure-as-a-Service).„Klienci, którym skończyła się gwarancja na kolokowany sprzęt, zazwyczaj nie decydowali się na kolejne inwestycje, tylko wybierali usługę IaaS w abonamencie. Dzięki temu firmy mogą zaoszczędzić już na samym zakupie sprzętu od kilkudziesięciu do kilkuset tysięcy złotych” – mówi Tomasz Stępski, prezes Sinersio Polska. „Jak dotąd najwięcej takich zmian odnotowaliśmy w 2017 r. Następuje naturalne przejście w nową usługę, nadal oferowaną przez dotychczasowego, już wypróbowanego dostawcę” – dodaje.

„Z biznesowego punktu widzenia to właśnie chmura jest przyszłością. Operatorom centrów danych daje ona możliwość rozsądnego gospodarowania posiadanymi zasobami technologicznymi, a klientom skalowalną moc obliczeniową, gwarantującą ciągłość działania” – podkreśla Michał Grzybkowski. Jednocześnie chmura obliczeniowa ułatwia współpracę i łączenie lokalnych środowisk IT budowanych w przedsiębiorstwach z usługami oferowanymi przez dostawców komercyjnych centrów danych.

Tomasz Rzepkowski, Technical Account Manager, OVH

Rynek centrów danych rozwija się dwutorowo. Jest napędzany z jednej strony przez przedsiębiorców, z drugiej przez dostawców, którzy obserwując oczekiwania klientów oraz dostępne rozwiązania, optymalizują ofertę centrów danych. Biznes natomiast formułuje konkretne potrzeby, generując popyt.

Potencjał tego rynku będą niezmiennie pobudzać rozwiązania chmurowe, zwłaszcza ich hybrydo¬we warianty. Usługi cloud umożliwiają uruchomienie środowisk łączących centra danych budowanych wewnątrz firm (on-premise) z częścią usługi lokowaną u jej dostawcy. Przykładem realizacji konkretnych potrzeb biznesu i udo¬stępnionych w formie usługi przez providera jest vRack Connect. To rozwiązanie pozwala na bezpośrednie połączenie firmowej sieci klienta – w sposób całkowicie odizolowany i bezpieczny – z jego prywatną siecią w data center OVH.

Wzrost popularności outsourcingu usług IT nie wyhamuje, ponieważ sprawił m.in., że sektor MŚP zyskał olbrzymie możliwości zarządzania danymi, zarezerwowane niegdyś dla największych graczy. Warto pamiętać, że z wyjątkiem korporacji rzadko którą firmę stać na wprowadzenie niezbędnych zaawanasowanych mechanizmów zarządzania dostępem do danych, od wyspecjalizowanego oprogramowania, które wykrywa i blokuje cyberataki, po kilkupoziomowy system zabezpieczeń fizycznego przebywania na obiekcie.

U dostawcy wielowarstwowa ochrona wliczona jest w cenę korzystania z zasobów. Jeśli firma chce utrzymywać serwerownię we własnym zakresie, musi zainwestować we wszystkie niezbędne rozwiązania i utrzymywać je samodzielnie.

Mówiąc o bezpieczeństwie centrum danych, warto wspomnieć o polityce certyfikacji. Przykładowo OVH, które ma 27 centrów danych na czterech kontynentach, realizuje globalnie strategię certyfikacji, w celu zapewnienia zgodności infrastruktur oraz usług ze standardami międzynarodowymi. To oznacza m.in., że wszystkie instalacje OVH korzystają z takiej samej ochrony bez względu na lokalizację. To też sprawia, że z uwagi na restrykcyjną politykę bezpieczeństwa w OVH – w przeciwieństwie do niektórych ośrodków – nie jest praktykowane zwiedzanie centrum danych.

Postępująca integracja środowisk lokalnych i usług w chmurze

Mimo zalet publicznych chmur obliczeniowych, niektóre dane i procesy z różnych powodów (np. regulacji prawnych, polityk bezpieczeństwa czy żądań kontrahentów) pozostaną w firmowych centrach danych. Część obciążeń można jednak z powodzeniem przesunąć do zewnętrznego dostawcy. To racjonalne podejście, pozwalające zaoszczędzić pieniądze i zredukować nakład pracy niezbędnej do zapewnienia prawidłowego działania zaplecza IT.

Wzrost popularności środowisk hybrydowych, które łączą lokalną infrastrukturę firmy z zewnętrznymi usługami w chmurze, przewidują zarówno analitycy, jak i najwięksi dostawcy IT.

„Dostawcy mają możliwość sprzedaży usług o większej wartości dodanej oraz wchodzą szerzej na rynek integracji. Klienci oczekują natomiast rozwiązań zbliżonych do oferty np. AWS oraz dużej wiedzy integratorskiej po stronie dostawców” – podkreśla Grzegorz Bernatek z Audytela.

Publiczne chmury obliczeniowe będą coraz częściej wspierały lokalne środowiska IT, np. w obsłudze okresowo zwiększającego się ruchu, składowaniu danych czy tworzeniu kopii zapasowych. „Dostępne na rynku technologie pozwalają na uproszczenie procesów. Przykładem jest choćby Disaster Recovery, gdzie stroną nie musi być już drugie data center, wyposażone przez klienta w zapasową infrastrukturę, a usługa, którą jest w stanie dostarczyć provider w modelu IaaS” – mówi Tomasz Rzepkowski, Technical Account Manager w OVH.

Wzrost popularności rozwiązań definiowanych programowo

Chcąc zapewnić wygodę i elastyczność firmowego zaplecza IT, decydenci IT będą inwestować w środowiska ułatwiające z jednej strony zarządzanie własnymi zasobami, a z drugiej strony łączenie ich z ofertą zewnętrznych usługodawców za pomocą łatwo konfigurowalnych interfejsów API.

Do popularnych już systemów wirtualizacji serwerów coraz częściej dołączają rozwiązania programowo definiujące sieci komputerowe (Software Defined Networks) czy pamięć masową (Software Defined Storage). Najwięksi dostawcy infrastruktury IT promują obecnie kompletne rozwiązania SDDC (Software-Defined Data Center), które natywnie i w całości traktują zasoby obliczeniowe, pamięciowe i sieciowe jako jedną, łatwo definiowalną pulę.

Popularność rozwiązań programowalnych będzie stale wzrastać. Według ośrodka analitycznego IDC, obecnie już kilkanaście procent nakładów na serwery oraz macierze przeznaczanych jest na platformy konwergentne. Wartość rynku tego typu rozwiązań szacowana jest obecnie na ok. 500 mln USD. Szybkie wzrosty zapewniać będzie coraz bardziej uświadamiana przez decydentów IT potrzeba standaryzacji infrastruktury, która umożliwi elastyczne i szybkie dostosowywanie zasobów do dynamicznie zmieniających się potrzeb, a dzięki temu sprawną obsługę środowisk chmurowych czy IoT. Ważną zaletą rozwiązań definiowanych programowo jest także systemowa redukcja ryzyka narastania silosów informacyjnych w organizacji.

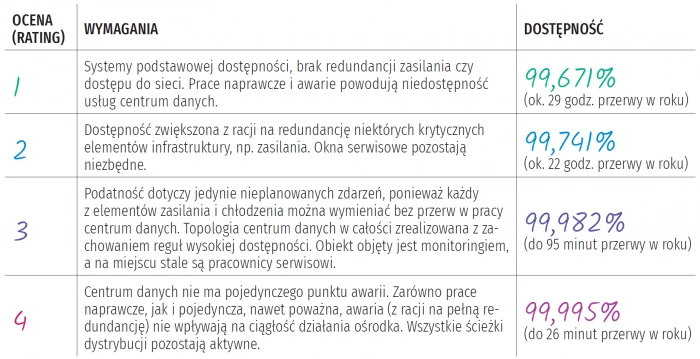

Najbardziej rozpoznawalne oraz najczęściej stosowane (choć nie jedyne) są standardy centrów danych wypracowane przez Uptime Institute oraz Stowarzyszenie Przemysłu Telekomunikacyjnego (Telecommunications Industry Association, TIA). Klasyfikacje wypracowane przez oba podmioty dzielą ze sobą wiele założeń (np. czteropoziomowy podział dostępności wraz z odpowiadającą mu infrastrukturą, systemami bezpieczeństwa, zasilaniem, monitoringiem, redundancją etc.), ale równie wiele je dzieli. Uptime Institute to komercyjna, amerykańska firma, certyfikująca centra danych za opłatą. Jej założeniem jest uzależnienie poziomu działania ośrodków przetwarzania danych nie tylko od ich specyfiki technicznej, ale i branżowego czy biznesowego kontekstu. TIA to z kolei organizacja normalizacyjna, zaś norma ANSI/TIA-942 ma ogólnodostępny charakter.

W Polsce najczęściej przywoływane są właśnie standardy wypracowane przez TIA: „Telecommunications Infrastructure Standard for Data Centers” (ANSI/TIA-942:2014). Według tej klasyfikacji, najniższym poziomem dostępności centrum danych jest Rated-1 (do marca 2014 roku – Tier-1), w którym usługi hostowane są ze zwykłego pomieszczenia, wyposażonego w podstawową infrastrukturę. Najbardziej zaawansowany jest poziom czwarty, zaprojektowany pod kątem hostowania aplikacji krytycznych dla przedsiębiorstwa. Takie centrum danych ma zwielokrotnione podsystemy, wydzielone strefy kontroli dostępu z dwuskładnikowym, często biometrycznym uwierzytelnieniem. Poszczególne poziomy dostępności uwzględniają także poziom potencjalnych zagrożeń zewnętrznych (takich jak: pożar, powódź czy akty terroru) wynikających z położenia ośrodka przetwarzania danych.

Różnica w dostępności między poszczególnymi poziomami może być istotna w przypadku aplikacji krytycznych dla działania przedsiębiorstwa. W ciągu roku aplikacja hostowana w centrum danych klasy Rated-1 może mieć przerwy liczone w godzinach, z kolei w ośrodku poziomu 4 ogólny czas niedostępności zakłada się na poziomie nie wyższym niż 26 minut rocznie. Niedostępność aplikacji przekłada się wprost na straty przedsiębiorstwa, a zatem przy określaniu potrzeb biznesowych w zakresie dostępności usługi świadczonej przez IT na rzecz biznesu należy uwzględnić także przestoje spowodowane przez infrastrukturę centrum danych. W przypadku aplikacji krytycznej dla pracy przedsiębiorstwa należy wyeliminować wpływ nie tylko planowanych działań związanych z konserwacją (to zapewnia poziom Rated-3), ale także nieplanowanych, nawet poważnych awarii. Dodatkowym kryterium jest monitoring i obecność personelu serwisowego w obiekcie. Jest to reguła przy data center na poziomie Rated-3 oraz 4. Z racji na koszty oraz czas budowy całej niezbędnej infrastruktury zakupienie usług w profesjonalnym i dobrze wyposażonym centrum przetwarzania danych jest często bardziej opłacalne niż utworzenie i utrzymanie centrów danych własnego ośrodka.

Klasyfikacja centrów danych według standardu ANSI/TIA-942:2014