Przyszłość z laboratorium

-

- 14.10.2010

Czy "prawo Moore’a" zostanie złamane i jak?

W 1965 r. Gordon Moore, jeden z założycieli firmy Intel, przedstawił prognozę rozwoju technologii wytwarzania układów scalonych przewidującą wykładniczy wzrost gęstości upakowania elementów półprzewodnikowych. Prognoza ta dotyczyła przede wszystkim układów pamięciowych, które początkowo były jednym z głównych produktów Intela, ale później została zaadaptowana również do ocen szybkości wzrostu upakowania tranzystorów w mikroprocesorach oraz ich wydajności. Z czasem okazało się, że przewidywanie Gordona Moore’a sprawdza się z zadziwiającą dokładnością i powszechnie zaczęto określać je jako "Prawo Moore’a", choć sensu stricto nie jest to prawo, np. w znaczeniu praw fizyki.

Ale już w 2007 r. pracujący w Intelu Justin Rattner powiedział: "Elektronika oparta na kontroli i sterowaniu ładunkami elektrycznymi zaczyna tracić perspektywy rozwoju. Dlatego też naukowcy starają się wykorzystać efekty kwantowe, takie jak spin, a wyniki ich badań są obiecujące".

W efekcie, jak sądzą niektórzy naukowcy, prawo Moore’a przestaje znajdować zastosowanie. Nie dlatego, że wydajność mikroprocesorów przestanie rosnąć, lecz dlatego, że nastąpi rewolucyjna transformacja technologii i zamiast klasycznych tranzystorów mikroprocesory będą wykorzystywały zjawiska kwantowe. Perspektywa stosowania zjawisk kwantowych w konstrukcji komputerów wciąż wydaje się jednak dość odległa. Można oczekiwać, że pierwsze takie rozwiązania pojawią się za 10 lat. Jak dotąd, nawet w najbardziej udanych eksperymentach, komputery kwantowe były w stanie wykonywać tylko podstawowe, jedno lub dwubitowe obliczenia.

Jednocześnie w laboratoriach prowadzone są doświadczenia z wieloma innymi technikami, które mogą mieć równie lub bardziej rewolucyjne znaczenie w rozwoju mikroprocesorów.

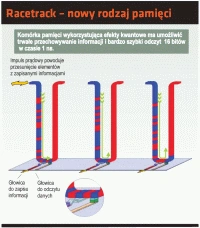

Racetrack - nowy rodzaj pamięci

Z kolei zespoły naukowców z Michigan Technological University i japońskiego National Institute for Materials Science opracowują inne, bardziej radykalne rozwiązanie. Do budowy mikroprocesorów, zamiast krzemu chcą wykorzystać DDQ - związek składający się z węgla, azotu, tlenu i chloru, by zbudować komputer molekularny, pozwalający na prowadzenie obliczeń równoległych przy wykorzystaniu mechanizmów podobnych w swojej zasadzie do działania mózgu ludzkiego.

Ponieważ komputer taki będzie się składał z molekuł organicznych, być może w przyszłości będzie możliwa jego "hodowla" zamiast wytwarzania w przemysłowych fabrykach wykorzystujących procesy chemiczne.