Pamięć masowa przełamuje bariery technologiczne

-

- 16.05.2018, godz. 00:31

Cyfrowa transformacja powoduje lawinowy przyrost danych. Dyski talerzowe są za wolne, pamięci SSD wciąż zbyt drogie, a na rynku pojawiają się nowe obiecujące technologie, takie jak 3D XPoint. Natomiast klienci zwiększają inwestycje w pamięć sterowaną programowo i w hiperkonwergencję.

Zapotrzebowanie na pojemność pamięci masowych rośnie systematycznie, a firmy analityczne zapowiadają jeszcze większy wzrost ilości danych generowanych m.in. przez systemy IoT (internet rzeczy), smartfony, autonomiczne samochody itd.

Czy rozwój technologii nadąży za tymi trendami i pamięć masowa nie okaże się barierą hamującą wprowadzanie nowych rozwiązań i aplikacji? Na razie nie widać takiego zagrożenia, bo postęp w opracowywaniu nowych, zarówno sprzętowych, jak i programowych technologii jest wciąż szybki.

Zobacz również:

- Brak miejsca na dysku? Najlepsze metody na zwiększenie pamięci

- Nowa era w pojemności dysków twardych

- Windows 11 zauważalnie zwolnił - to wina błędu dysków SSD

Jeśli chodzi o sprzęt, to podstawowym elementem wykorzystywanym do przechowywania danych są wciąż klasyczne dyski magnetyczne. Jest to jednak technologia, której korzenie sięgają początków IT. Konkurencją dla niej w coraz większym stopniu są pamięci Flash (dyski SSD), choć wciąż nie widać, by w bliskiej perspektywie miały one zastąpić klasyczne HDD. Nie ulega jednak wątpliwości, że zbliża się czas, gdy dyski magnetyczne zaczną być urządzeniami przestarzałymi, których zastosowania będą się kurczyć. Trzecią technologią, która już w 2017 r. pojawiła się na rynku, są pamięci nowej generacji 3D XPoint. Stanowią one pierwszy praktyczny przykład nowych układów pamięciowych, które w przyszłości mogą zastąpić nie tylko HDD i SSD, ale również DRAM.

Ale nie tylko rozwiązania sprzętowe decydują o kierunku rozwoju rynku pamięci masowych. Równie ważne są nowe koncepcje architektury i programowego sterowania systemem pamięci masowej. Popularyzacja systemów chmurowych, technologie wirtualizacji i zarządzania pamięciami SDS (Software Defined Storage) to istotne czynniki mające wpływ na trendy rynkowe.

Z badania przeprowadzonego przez 451 Research wynika, że głównym problemem jest wciąż konieczność sprostania wzrostowi wymagań na pojemność pamięci, choć spada liczba respondentów, którzy go wskazują, z 55% w 2016 roku do 47% w roku 2017. Zmniejszają się też wyzwania związane z zapewnieniem odpowiedniej wydajności pamięci masowej. Liczba ankietowanych zgłaszających ten problem spadła z 29% do 22%.

Dyski HDD i SSD

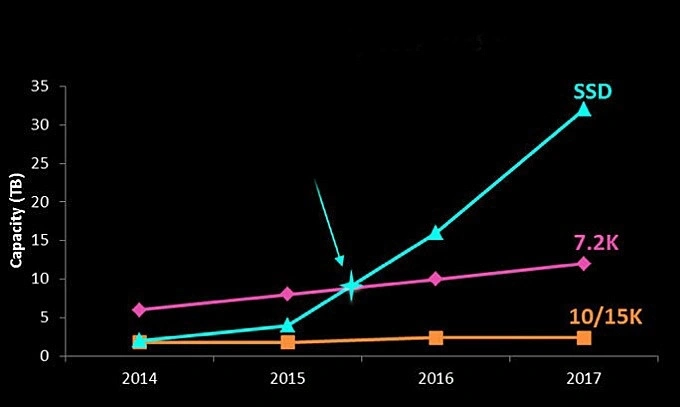

Pojemność dysków HDD nieustannie rośnie i wciąż są one podstawą systemów pamięci masowej wykorzystywanej w firmowych centrach danych. Jedyną konkurencją dla nich są obecnie półprzewodnikowe dyski SSD, a należy zauważyć, że technologie związane z pamięciami flash rozwijają się znacznie szybciej i nie tylko pod względem wydajności, ale również pojemności dyski SSD zaczęły niedawno górować nad HDD.

Wzrost pojemności dysków HDD i SSD. Źródło: Samsung Semiconductor.

Dyski SSD z reguły wykorzystują układy pamięci flash NAND. Około 6 lat temu miniaturyzacja komórek pamięci w układach flash dotarła do granic fizycznych możliwości i dalsze zwiększanie ich gęstości, a więc pojemności pamięci, stało się niewykonalne przy zastosowaniu standardowych metod. Problem ten został jednak dość szybko rozwiązany przez wprowadzenie nowej technologii określanej jako 3D lub Vertical NAND – zamiast zmniejszania wymiarów pojedynczych komórek pamięci są one umieszczane w wielu warstwach, co pozwala na istotne zwiększenie pojemności pojedynczych układów flash. Na razie nie widać fizycznych ograniczeń dotyczących liczby warstw, które można w ten sposób nałożyć i wszystko zależy od rozwoju technologii umożliwiających efektywne i masowe wytwarzanie takich układów.

Pojemność dysków HDD nieustannie rośnie i wciąż są one podstawą systemów pamięci masowej wykorzystywanej w firmowych centrach danych. Jedyną konkurencją dla nich są półprzewodnikowe dyski SSD. Technologie związane z pamięciami flash rozwijają się znacznie szybciej i nie tylko pod względem wydajności, ale również pojemności dyski SSD zaczęły niedawno górować nad HDD.

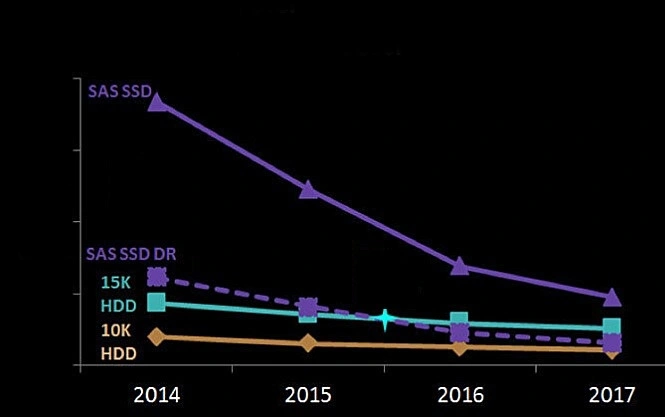

Popularyzacja SSD wciąż hamowana jest jednak przez barierę ekonomiczną. Mimo że ceny pamięci flash w przeliczeniu na gigabajt spadają szybciej niż dysków HDD, to pamięci masowe wykorzystujące SSD są wciąż droższe niż te wykorzystujące HDD. Producenci pamięci podają oczywiście przykłady podważające tą opinię, np. mówiące o możliwości zastosowania technologii kompresji i deduplikacji danych, które zmniejszają rzeczywiste zapotrzebowanie na pojemność pamięci masowej. Można też znaleźć wyliczenia, z których wynika, że w systemach pamięci wymagających szczególnej wydajności i szybkości dostępu do danych zastosowanie SSD jest tańsze niż zestawów dysków HDD 15K, o ile oczywiście nie są to macierze o bardzo dużej pojemności. Popularyzacji zastosowań pamięci flash sprzyja wzrost wdrożeń narzędzi analitycznych, które wymagają szybkiego dostępu do dużej liczby danych.

Względne koszty pamięci HDD i SSD [USD/GB]. Źródło: Samsung Semiconductor.

Według Samsung Semiconductor, w standardowym serwerze o wysokości 2U można zainstalować 12 3,5-calowych dysków HDD o pojemności 10 TB lub 24 2,5-calowe dyski SSD o pojemności 16 TB każdy. W efekcie całkowita pojemność zainstalowana w serwerze to odpowiednio 120 i 384 TB. Różnica na korzyść SSD jest więc ponad trzykrotna.

Nowa technologia 3D XPoint

Przykładem technologii, która może już wkrótce zmienić obraz rynku i standardowy wybór między dyskami HDD i SSD, jest 3D XPoint. Wykorzystujące ją dyski wprowadziły już w 2017 r. firmy Intel i Micron.

Pamięci Intel 900P Optane z interfejsem PCi Express. Według nieoficjalnych informacji wkrótce mają pojawić się ich modele o pojemności 960 GB, a nawet 1,5 TB. Źródło: Intel.

Dyski Intel Optane to nieulotne pamięci, które mają parametry gorsze niż układy DRAM, ale znacznie lepsze niż dyski HDD lub SSD. W październiku 2017 r. Intel wprowadził do sprzedaży dyski Optane 900P SSD o pojemnościach 280 GB i 480 GB. W tym roku firma zamierza wprowadzić pamięci Optane w formie przeznaczonych do instalacji w serwerach modułów DRAM.

Intel i Micron wspólnie opracowały technologię 3D XPoint. Podobne technologie rozwija wiele innych firm, ale Intel i Micron już wprowadziły produkty na rynek i pod tym względem brakuje im na razie konkurentów. Oznacza to, że mają pełną kontrolę i możliwość dopasowywania tempa rozwoju technologii, wprowadzania nowych produktów oraz kształtowania ich cen zgodnie z własnymi kalkulacjami biznesowymi.

Przedstawiciele Intela prezentują wizję, że pamięci Optane staną się za kilka lat jedyną formą lokalnej pamięci masowej instalowanej w notebookach i komputerach PC. Będą przeznaczone do przechowywania najczęściej wykorzystywanych danych, a pozostałe informacje będą przechowywane w chmurze. Wizja ta opiera się na założeniu, że w 2020 r. rozpocznie się popularyzacja technologii 5G oferującej wysoką przepustowość. „Gdy stanie się ona powszechna, to lokalne przechowywanie danych na dyskach HDD SATA straci znaczenie, bo szybkość dostępu będzie podobna” – twierdzi Rob Crooke z Intela.

Problemy i kierunki rozwoju pamięci masowych

Największe problemy z zarządzaniem pamięcią masową w firmach są związane ze wzrostem liczby danych, które muszą być przechowywane w systemie, spełnieniem wymagań dotyczących odtwarzania danych po awarii oraz wysokimi kosztami pamięci masowej. Takie są wyniki ankiety przeprowadzonej w 2017 r. przez 451 Research opublikowanej w raporcie „Top Three Storage Pain Points for Enterprise Customers”. W ankiecie wzięło udział blisko 500 specjalistów odpowiedzialnych za pamięci masowe w firmach.

„W porównaniu z wcześniejszymi badaniami widać, że nastąpiła wyraźna zmiana. Systemy pamięci w chmurze zaczynają być postrzegane jako rozwiązanie pozwalające na efektywne zrównoważenie rosnącego zapotrzebowania na pojemność pamięci masowej, a ciężar problemów przesuwa się w kierunku zarządzania danymi przechowywanymi w lokalnym systemie i chmurze” – mówi autor raportu Simon Robinson, wiceprezes 451 Research.

Choć problemem numer jeden jest wciąż konieczność sprostania wzrostowi wymagań na pojemność pamięci, to liczba respondentów, którzy go wskazują, spadła z 55% w 2016 r. do 47% w roku 2017. Z ankiety wynika też, że zmniejszają się wyzwania związane z zapewnieniem odpowiedniej wydajności pamięci masowej. Liczba ankietowanych zgłaszających ten problem spadła odpowiednio z 29% do 22%. Migracja danych między różnymi systemami pamięci masowej to zadanie, z którym musi sobie radzić coraz większa liczba menedżerów IT. Liczba przyznających to respondentów wzrosła z 13% do 21%.

„Coraz więcej firm zaczyna wykorzystywać hybrydowe środowiska chmurowe i pamięci dostarczane przez różnych dostawców. W efekcie ciężar zadań spoczywających na administratorach IT zaczyna się przesuwać w kierunku efektywnego zarządzania hybrydowym systemem składającym się z różnych pamięci masowych, a nie tylko z reguły jednolitym systemem firmowym” – zwraca uwagę Simon Robinson.

Podobne badanie (State of Software-Defined Storage, Hyperconverged and Cloud Storage) przeprowadziła firma DataCore, dostawca pamięci masowych. Jedno z pytań ankiety dotyczyło praktycznych doświadczeń i problemów związanych z wdrażaniem systemów SDS (Software Defined Storage), pamięci działających w chmurze oraz systemów hiperkonwergentnych.

Najczęściej sygnalizowanym problemem było uzyskanie oszczędności mniejszych od oczekiwanych – 31% ankietowanych przyznało, że migracja do chmurowego systemu pamięci masowej nie przyniosła efektów ekonomicznych, a dodatkowo 29% stwierdziło, że pamięci obiektowe okazują się trudne w zarządzaniu.

Niektórzy z ankietowanych są rozczarowani systemami pamięci półprzewodnikowych, twierdząc, że nie dostarczają one oczekiwanego wzrostu wydajności. Aż 16% respondentów odpowiedziało, że migracja z systemu wykorzystującego klasyczne dyski do pamięci opartych na układach flash nie spowodowała zwiększenia szybkości działania aplikacji.

Z badania DataCore można też wyciągnąć inne ciekawe wnioski:

* Hiperkonwergentne systemy pamięci spotykają się z mniejszym zainteresowaniem, niż można oczekiwać. 33% ankietowanych w ogóle nie rozważa możliwości ich zastosowania, a 34%, choć bierze je pod uwagę, ale nie podejmuje wdrożeń. 20% przyznaje, że wykorzystuje kilka takich węzłów, a tylko 6% wdrożyło systemy hiperkonwergentne jako podstawowe rozwiązanie w firmie.

* Zaledwie 3% ankietowanych firm wykorzystuje dyski SSD jako podstawową pamięć masową w firmie zapewniającą przynajmniej 90% wykorzystywanej pojemności, a 7% deklaruje, że pamięci flash stanowią ponad jej połowę (51%–89%). Najwięcej, bo aż 62% wykorzystuje pamięci flash na poziomie nieprzekraczającym 10% całkowitej pojemności systemu pamięci masowej, a 14% firm w ogóle nie korzysta z dysków SSD.

* Rosną wydatki na systemy SDS (Software-Defined Storage). 13% firm deklaruje, że ponad 25% budżetu na pamięć masową przeznaczy na inwestycje w SDS, a 16% firm – do 25% dostępnych środków finansowych. Główne powody zainteresowania systemami SDS to: możliwość uproszczenia zarządzania systemem wykorzystującym różne rodzaje pamięci (55%), zapewnienie dobrego działania infrastruktury w przyszłości niezależnie od zmian technologicznych i organizacyjnych (53%), możliwość uniknięcia uzależnienia od jednego dostawcy pamięci masowych (52%) oraz przedłużenia czasu życia istniejących zasobów pamięci (47%).

Rośnie popularność SDS

IDC prognozuje, że wydatki na systemy SDS (Software-Defined Storage) będą rosły o 13,5% rocznie w latach 2017–2021. Wynika to z już obserwowanego trendu migracji ze sprzętowo zdefiniowanego systemu pamięci masowej do infrastruktury wykorzystującej pamięć zwirtualizowaną oraz oferowaną w chmurze.

Systemy SDS mogą być uruchamiane w standardowych, fizycznych serwerach, wirtualizując pamięć masową i dostarczając takich funkcji jak programowa deduplikacja danych i dynamiczne przydzielanie zasobów, co umożliwia automatyzację zarządzania systemem, a w efekcie zwiększenie jego wydajności.

„Dla firm wdrażających cyfrową transformację, SDS jest przydatnym rozwiązaniem ułatwiającym zwiększenie elastyczności systemu IT, a także zmniejszenie kosztów kapitałowych dzięki możliwości wykorzystania standardowych pamięci masowych powszechnie dostępnych na rynku” – mówi Eric Burgener, dyrektor w IDC.

SDS znajduje zastosowanie w trzech segmentach: pamięciach plikowych, obiektowych oraz systemach hiperkonwergentnych HCI (Hyper-Converged Infrastructure).Według IDC, do 2021 r. najszybciej, w tempie 26,6%, rocznie będzie się rozwijał segment HCI (w 2021 r. obroty osiągną 7,15 mld USD). Obroty na rynku pamięci obiektowych będą rosły o 10,3%, plikowych – 6,3%, a wykorzystujących zapis danych w formie bloków o 4,7% rocznie.

Praktycznie wszyscy najwięksi dostawcy serwerów i pamięci masowych koncentrują się na rozwijaniu systemów hiperkonwergentnych, które zastąpią przestarzałe obecnie systemy oparte na sieciach SAN i pamięciach NAS. Oprócz tego pamięci flash będą coraz częściej zastępowały klasyczne dyski, a zwłaszcza najwydajniejsze z nich (i najdroższe) napędy 15K.