Okablowanie w nowym centrum danych

-

- 18.02.2013

Kolejne generacje okablowania miedzianego i optycznego zapewniają większą niż dotąd przepustowość, a rozwój technologii wciąż nie napotyka na istotne ograniczenia. Ale projektowanie infrastruktury sieciowej i systemu okablowania wcale nie jest łatwiejsze, a przeciwnie, wymaga analizy wielu dodatkowych parametrów, które w klasycznych rozwiązaniach i zasadach dobrego projektowania infrastruktury centrum danych nie były brane pod uwagę.

Zaprojektowanie centrum danych, które intensywnie wykorzystuje technologie wirtualizacyjne jest trudniejsze niż mogłoby się wydawać. Dotyczy to m.in. infrastruktury fizycznej, a w szczególności systemu okablowania. Jeśli komuś wydaje się, że podstawą nowoczesnego projektu może być zestaw odpowiednio wyposażonych szaf stelażowych i arbitralnie zaprojektowana, łącząca je standardowa sieć o przepustowości 10 Gb/s to jest w błędzie, uważa Justin Stoner z firmy LVW Electronics.

Niezależnie, jakie rozwiązania zostaną zaakceptowane w projekcie budowy lub modernizacji centrum przetwarzania danych, nie ulega obecnie wątpliwości, że zastosowanie technologii wirtualizacyjnych ma istotny, bezpośredni wpływ na taki projekt.

Zobacz również:

Wirtualizacja i fizyczna warstwa systemu IT

Niektórzy specjaliści uważają, że popularyzacja łączy 40 i 100 Gb/s oraz związanych z nimi systemów okablowania jest ściśle związana z wirtualizacją systemów IT, która istotnie wpływa na wzrost zapotrzebowania na wyższą niż dotąd przepustowość sieci wykorzystywanej w centrach danych.

Czy związek między wdrożeniem systemów wykorzystujących technologie wirtualizacyjne o wysokiej gęstości oraz wymaganiami na sieć i parametry związane z przepustowością okablowania jest oczywisty? Wydaje się, że te dwa elementy często są postrzegane jako mające ze sobą niewiele wspólnego.

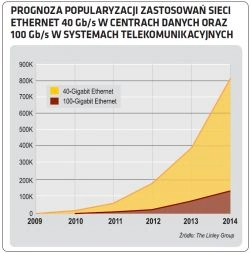

Prognoza popularyzacji zastosowań sieci Ethernet 40 Gb/s w centrach danych oraz 100 Gb/s w systemach telekomunikacyjnych

Budowa środowiska zwirtualizowanego centrum danych zaczyna się od instalacji fizycznych serwerów, które mają być hostami dla uruchamianych później maszyn wirtualnych obsługujących aplikacje i świadczących usługi. A podstawowe elementy fizycznego serwera to procesor, pamięć RAM, dysk (lokalna pamięć masowa) i interfejs sieciowy NIC (Network Interface Card) umożliwiający komunikację i wymianę danych z innymi urządzeniami działającymi w systemie.

W klasycznym rozwiązaniu, administrator z reguły instaluje w serwerze jeden system operacyjny, a następnie zestaw aplikacji działających na tej platformie, np. bazy danych, aplikacje biurowe, oprogramowanie serwerów webowych itd. Zainstalowane w ten sposób oprogramowanie najczęściej nie wykorzystuje w pełni zasobów fizycznego serwera, a więc dostępnej mocy przetwarzania, pamięci RAM i pojemności dysków.