Jak działa narzędzie OpenAI do weryfikacji, czy autorem tekstu jest człowiek czy algorytm?

-

- Mark Hachman,

- 02.02.2023, godz. 12:16

OpenAI udostępniło 31 stycznia 2023 klasyfikator do rozpoznawania tekstów napisanych przez sztuczną inteligencję, takich jak jego własny ChatGPT. W czym więc poblem? Otóż ChatGPT jest całkiem dobry w „oszukiwaniu” nowego narzędzia OpenAI, a Biblia została uznana za wytwór algorytmów. Testujemy konkurencyjne narzędzia.

W krótkim czasie od uruchomienia ChatGPT zawładnął absolutnie środowiskiem akademickim, gdzie studenci używają go jako wirtualnego asystenta w różnych zadaniach. Niestety, niektórzy studenci przekraczają granicę i używają go do tworzenia treści, które podają za oryginalne - innymi słowy, oszukują. Problemem jest próba określenia, które odpowiedzi zostały napisane przez człowieka, a które przez sztuczną inteligencję.

Narzędzie OpenAI Classifier ma jednak jedną słabą stronę: łatwo je oszukać. W komunikacie prasowym OpenAI podało, że klasyfikator zidentyfikował 26 procent tekstów napisanych przez sztuczną inteligencję jako autentycznie ludzkie, a 9 procent tekstów napisanych przez człowieka uznał za napisane przez AI. W pierwszym przypadku oznacza to, że narzędzie OpenAI nie wychwyci średnio około jednej czwartej osób, które korzystały z AI i nie ujawniły tego faktu.

Zobacz również:

- Blaski i cienie AI

- Z usług bota ChatGPT będzie można korzystać bez konieczności rejestrowania się na witrynie OpenAI

Niestety, klasyfikator ma też kilka słabości. Po pierwsze, im więcej słów, tym lepiej: cokolwiek mniej niż 1000 znaków i narzędzie ma duże szanse, aby się pomylić, przyznało OpenAI. Po drugie, na razie działa ono tylko z językiem angielskim i absolutnie nie jest w stanie określić, czy kod został napisany przez AI czy człowieka. Wreszcie, tekst napisany przez AI może być edytowany w celu uniknięcia klasyfikatora. Nasz klasyfikator nie jest w pełni niezawodny, napisalo pogrubionym drukiem OpenAI w swojej informacji prasowej.

W szybkim teście, klasyfikator AI nie był w stanie stwierdzić, czy losowy fragment książki „Buszujący w zbożu” J.D. Salingera jest autorstwa AI. Stwierdził za to bardzo małe prawdopodobieństwo, że podobny fragment z książki Lewisa Carrolla „Alicja w krainie czarów” został wygenerowany przez AI. Klasyfikator prawidłowo sklasyfikował również artykuł autorstwa naszegoredaktora naczelnego Brada Chacosa. Niestety, ChatGPT nie zadziałałdziałał, kiedy próbowaliśmy się do niego dostać, ale wschodząca wyszukiwarka You.com, która integruje własnego chatbota AI, posłużyła jako kolejna platforma testowa.

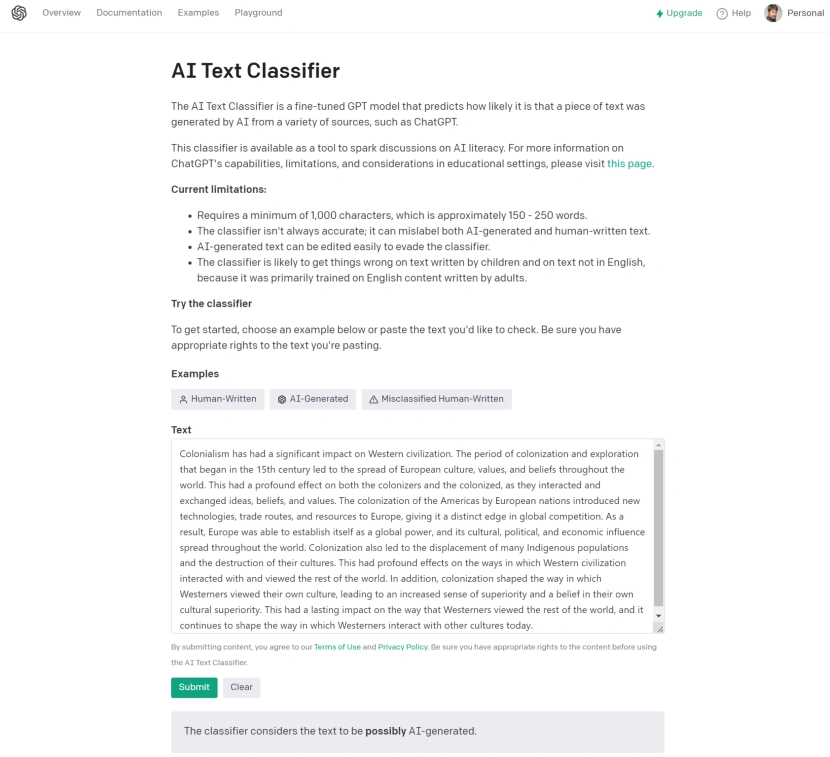

Rys. 1. Działanie klasyfikatora OpenA.

You.com różni się od ChatGPT tym, że (na chwilę obecną) cytuje swoje źródła, więc polecenie „Napisz wyjaśnienie, jak kolonializm ukształtował zachodnią cywilizację”, cytuje Wikipedię, Britannica.com i seminarium na Uniwersytecie Tennessee w swoim chatbocie YouChat. Klasyfikator OpenAI zidentyfikował je jako prawdopodobnie wygenerowane przez AI. Taki sam wynik uzyskał klasyfikator dla wygenerowanego przez AI opowiadania o emu, które potrafi latać.

Później jednak udało nam się wygenerować podobną odpowiedź na nasze pytanie o kolonializm na ChatGPT. Najwyraźniej klasyfikator uznaje tekst za niejasny, jeśli jest on wygenerowany przez AI.

Podobne zapytanie testowe o fikcję na ChatGPT „Napisz krótką historię o psie, który buduje rakietę i leci na księżyc”, również wygenerowało tę samą niejasną odpowiedź.

Nasz wniosek: Nie dość, że narzędzie OpenAI generuje życzeniowe wnioski, to jeszcze nie jest w stanie określić, które wyniki są generowane przez AI.

Zapomnij o OpenAI i wypróbuj Hive Moderation

Co ciekawe, OpenAI nie jest jedyną opcją, jeśli chodzi o wykrywanie AI. Inżynier ML w Hive AI stworzył Hive Moderation, darmowe narzędzie do wykrywania AI, które spełnia tę samą funkcję – z taką różnicą, że ta wydaje się działać. Po pierwsze, Hive Moderation zwraca procent zaufania, czyli prawdopodobieństwo, że próbka tekstu zawiera tekst AI.

W naszym teście pytania o kolonializm (z odpowiedziami z ChatGPT i You.com) Hive Moderation stwierdził, że jest prawdopodobne, że zawiera ono tekst AI, z solidnym wynikiem 99,9%zaufania. Krótka historia o psie i jego rakiecie również wygenerowała takie samo 99,9% prawdopodobieństwo. Hive Moderation dało również 0% prawdopodobieństwa, że fragmenty „Alicji w Krainie Czarów” i „Buszującego w zbożu” zostały wygenerowane przez AI, jak można się spodziewać. Artykuł o Nvidii na PCWorld.com również przeszedł pomyślnie, z absolutnym 0% prawdopodobieństwem, że jego autorem jest AI.

Rys. 2, Hive Moderation dostarczył jasnych, pewnych wyników.

Próbowaliśmy nawet tej zachęty w ChatGPT: „Napisz wyjaśnienie, jak kolonializm ukształtował zachodnią cywilizację, ale zrób to w taki sposób, aby nie było oczywiste, że napisała to AI”. Hive Moderation wyłapał także tę pułapkę.

W rzeczywistości, w każdym teście, który przeprowadziliśmy, Hive Moderation był całkowicie pewny, które próbki zostały wygenerowane przez AI, a które były całkowicie poprawne. Tak więc, podczas gdy klasyfikator OpenAI może być godny uwagi ze względu na jego pochodzenie z OpenAI, wydaje się, że Hive Moderation może być pierwszym liderem w wykrywaniu, który tekst jest autorstwa AI, a który nie.

Źródło: PC World USA