Infrastruktura wirtualna

-

- Jarosław Badurek,

- 30.04.2014

Po wirtualizacji serwerów działy IT przystępują do optymalizacji środowiska desktopów, wychodząc poza proste rozwiązania terminalowe. Optymalna wirtualizacja wymaga kwalifikowanego porównywania architektur uniwersalnych z implementacjami hybrydowymi.

W rozwoju informatyki można dostrzec trzy przenikające się megatrendy: miniaturyzację, mobilność i sieciowość. W układach technicznych dąży się do minimalizacji parametrów materialno-energetycznych. Komputery przeszły ewolucję od „szaf“ wielkości lokomotywy, do wersji, dosłownie, noszonych przy sobie urządzeń (wereable) – choćby w postaci okularów typu HuD (Head up Display) GoogleGlass. Coraz mniejsze urządzenia elektroniczne zyskują na mobilności. Z kolei te niewielkie i przenośne urządzenia chcemy łączyć w teleinformatyczne sieci. Powstająca na naszych oczach sieciowa gospodarka (network economy) wymusza jednak jeszcze jeden trend integrujący trzy poprzednie: wirtualizację.

Efektywność i bezpieczeństwo

Stosowanie podobnych technik to nie tylko kwestia oszczędności, ale wręcz sprawa życia lub śmierci. Marcowa katastrofa malezyjskiego samolotu pokazała, że są sytuacje, w których celowe byłoby przejęcie kontroli lotu przez obsługę naziemną (np. brak łączności z kokpitem). Podobny przypadek wystąpił podczas katastrofy greckiego Heliosa w pobliżu Aten (sierpień 2005, zginęło 121 osób). Samolot gwałtownie uległ dekompresji, co spowodowało stopniową utratę przytomności wszystkich osób na pokładzie. Piloci nie byli już zdolni do kontrolowania lotu. Wojskowe myśliwce towarzyszące samolotowi mogły tylko bezradnie krążyć z nim w autopilotowym kręgu przez trzy godziny aż do wyczerpania się paliwa. A wystarczyłoby zdalne kliknięcie myszką, aby uruchomić procedury sprowadzania samolotu na ziemię. Naturalnie, możliwość zdalnego przejęcia sterów samolotu to także niebezpieczeństwa, ale te można eliminować odpowiednimi procedurami organizacyjnymi i technicznymi.

Z podobnymi, choć nie tej klasy problemami spotykamy się także w przedsiębiorstwach: jaki jest bilans korzyści i strat w elastyczności podejścia do „weź do pracy swój komputer“ BYOD (Bring Your Own Device)? Czy lepiej jest serwisować bankomaty z tracącym wsparcie producenta WindowsXP poprzez internet (USA) czy bezpośrednio, bo pracują bez dostępu do sieci (Niemcy)? Widzimy, że kwestie efektywności zdalnego dostępu mogą kolidować z zagadnieniami bezpieczeństwa. Oba wymiary są istotne takż podczas planowania przedsięwzięć VDI (Virtual Desktop Infrastructure), czyli alternatyw dla komputerów osobistych z oprogramowaniem lokalnym.

Cechy i rodzaje wirtualizacji

Jednocześnie analizie należy poddać możliwe wymiary wirtualizacji:

Serwery – zastąpienie serwerów fizycznych jednostkami wirtualnymi (VM – Virtual Machine), co pozwala na równoległe korzystanie z wielu różnych systemów operacyjnych na jednolitej platformie hardwarowej. VM może być postrzegany jako obiekt software’owy, co zapewnia jego elastyczność w odniesieniu do warstwy hardware’owej. Za przydział zasobów odpowiada specjalne oprogramowanie – hypervisor.

Pamięci – w porównaniu do wersji a) wymaga podejścia bardziej zintegrowanego (możliwie do całości infrastruktury pamięci firmy), co gwarantuje wyraźniejsze efekty konsolidacji. Hybrydowe zestawy różnych jednostek pamięci stają się jednolitym nośnikiem wirtualnym, umożliwiającym optymalizację podsystemów SAN (Storage Area Networks). Dane mniej krytyczne mogą być przyporządkowywane korzystniejszym kosztowo obszarom pamięci.

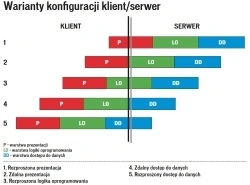

Aplikacje – upraszcza czy wręcz eliminuje instalacje lokalne, a co za tym idzie, konsoliduje zarządzanie licencjami i aktualizacjami (update/upgrade), zwiększając bezpieczeństwo (malware) oprogramowania. Możliwe warianty zorientowane serwerowo (całkowicie rozłączne warstwy C/S, wymagany permanentny dostęp sieciowy) oraz streaming, czyli wirtualizacja klienta z synchronizacją dla trybu offline.

Pulpity (desktop) – zaawansowana wersja c), w której wirtualizowane jest także środowisko klienckiego systemu operacyjnego. Wirtualny pulpit nowoczesnej aplikacji (również zwirtualizowanej) można uruchamiać też ze starszego peceta, względnie oszczędnościowej wersji „szczupłego klienta” (thin/slim client).

Sieci – również w tym obszarze możliwe stosowanie logicznej konsolidacji fizycznych komponentów do postaci VLAN (Virtual Area Network) lub VPN (Virtual Private Networks).

O ile wirtualizacja serwerów nie budzi większych wątpliwości implementacyjnych i kontrowersji organizacyjnych (ergonomicznych, finansowych), o tyle zaawansowana wirtualizacja środowiska desktopowego (VDI) wymaga kwalifikowanych szacowań TCO/ROI uwzględniających całość cyklu życia (life cycle) wszystkich komponentów infrastruktury wirtualnej oraz opcje rozwiązań hybrydowych (patrz ramka).

Konsekwencje i uwarunkowania

- Teoretyczny wzrost elastyczności dostępu dla użytkownika może wiązać się z ograniczeniami wydajności lub (psychologicznej) swobody korzystania z aplikacji (indywidualne instalacje).

- Analiza porównawcza architektur nie zawsze uwzględnia dodatkowe koszty implementacji, np. konieczność stosowania pamięci SSD (Solid State Disk) dla poprawy szybkości aplikacji.

- Brak uniwersalnych modeli kosztowych dla różnych grup użytkowników uwzględniających różnice, np. między stanowiskami CAD a medycznymi czy wymagania dotyczące wideokonferencji bądź platform mobilnych.

Krytyczne pytania organizacyjne

- Czy wirtualizacja pomoże nam w osiąganiu celów biznesowych?

- Czy mamy zespół o wystarczających kwalifikacjach i doświadczeniu w zakresie wirtualizacji?

- Czy użytkownicy gotowi są na akceptację „politycznych“ konsekwencji wirtualizacji?

- Czy dokonaliśmy kalkulacji kosztowych oraz rodzajów ryzyka związanych z wirtualizacją?