Flink konkurencją dla Hadoop

-

- Kamil Folga,

- 20.01.2015, godz. 11:47

Na rynku narzędzi do rozproszonej analizy dużych zbiorów danych Big Data pojawiła się ciekawa nowość w postaci oprogramowania Flink.

Apache Software Foundation przedstawił projekt Apache Flink, jako najnowszy TLP (Top-Level Project). Warto zaznaczyć, że Apache jest także domem dla Hadoop, Cassandra, Lucene i wielu innych narzędzi open source, realizujących zadania przetwarzania danych. Flink stanowił niespodziankę dla całego środowiska Big Data. Podobnie jak inna platforma do przetwarzania danych o nazwie Spark, Flink potrafi analizować dane w przypadku przetwarzania wsadowego, jak i strumieniowego. Narzędzie zostało opracowane w ramach projektu badawczego na Technical University of Berlin w 2009 roku i zostało skomercjalizowane przez firmę dataArtisans.

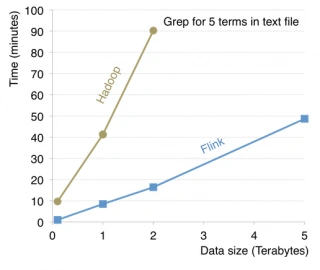

Dlaczego użytkownicy powinni wybrać Flink zamiast Hadoop? Twórcy oprogramowania twierdzą, że tym względem jest wydajność i łatwość użycia. Silnik Flink przetwarza i analizuje strumienie danych w pamięci, co zdecydowanie zwiększa szybkości pracy. Może stanowić idealną alternatywę dla Hadoop w przypadku wszystkich użytkowników, którzy potrzebują narzędzi o szczególnie wysokiej wydajności. Inną zaletą Flink jest łatwość użycia. Szczególnie przy dużych projektach, dostarczany z oprogramowaniem interfejs API (Application Programming Interfaces) jest łatwiejszy do wykorzystania, niż narzędzia Hadoop MapReduce. API oprogramowania Flink jest dostarczane dla języka Java oraz Scala.

Zobacz również:

Porównanie szybkości przetwarzania Flink i Hadoop. Źródło: flink.apache.org

Dostawca usług strumieniowego dostarczania muzyki Spotify oraz dostawca oprogramowania dla firm turystycznych i transportowych Amadeus, przeprowadzili z powodzeniem testy oprogramowania. Flink został także zastosowany w ResearchGate, społecznościowej sieci dla naukowców. Warto zauważyć, że w momencie gdy Hadoop oraz Spark stają się coraz bardziej popularne, Flink będzie musiał stoczyć prawdziwą bitwę o względy użytkowników. Historia pokazuje, ze projekty pracujące w oparciu o inteligentną optymalizację, rzadko kiedy pracują poprawnie, gdy zostaną wykorzystane w praktycznych warunkach do wykonywania rzeczywistych zadań. Przykładem mogą być problemy jakie dotykają oprogramowanie IBM Learning Optimizer for DB2 lub HP NeoView.