Ewolucja złożoności

-

- Jarosław Badurek,

- 06.03.2007

Wszechzwiązek zjawisk prowadzi niekiedy do zaskakujących wniosków - komputery wykazują cechy paranoidalne, a sztuczna inteligencja wymaga rozwiązania problemów kosmologicznych.

Wszechzwiązek zjawisk prowadzi niekiedy do zaskakujących wniosków - komputery wykazują cechy paranoidalne, a sztuczna inteligencja wymaga rozwiązania problemów kosmologicznych.

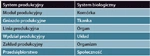

Tab. 1. Hierarchia systemu produkcyjnego i biologicznego

Z chwilą pojawienia się na Ziemi człowieka i tworzonej przez niego cywilizacji, darwi-nowska ewolucja, dotycząca wcześniej tylko procesów naturalnych, rozszerzyła się także na efekty naszej działalności, tj. technikę (maszyny) i sferę społeczną (organizacja grup ludzkich). Mechanizmy ewolucyjne znajdziemy zatem w trzech wymiarach: świecie biologicznym, świecie technologii i świecie relacji międzyludzkich. Praktyka potwierdza przypuszczenia formułowane już przed stuleciami, że człowiek działa w obszarze techniki w sposób rekurencyjny, tzn. wedle reguł, które były przyczyną nie tylko naszego powstania, ale także powstania fauny i flory, a nawet przyrody nieożywionej.

Latające ryby

Spekulowano w przeszłości, że skoro istnieją ryby, to kiedyś i my zbudujemy łodzie podwodne, a istnienie ptaków sprowokowało do wynalazku samolotu. Na podobnej zasadzie pojawiła się idea sztucznego mózgu (komputera) czy sztucznego człowieka, prowadząca w prostej linii do współczesnych robotów przemysłowych. Także rozwój systemów społecznych oraz osiągnięcia nauk organizacji i zarządzania w obszarze produkcji potwierdzają uniwersalność reguł ewolucyjnych dokumentowanych na gruncie teorii systemów. Stwarza to dogodny punkt wyjścia do prognozowania dalszego rozwoju naszej cywilizacji. Można zauważyć, że rozwój systemu oznacza wzrost jego złożoności w dwóch wymiarach: ilościowym i jakościowym, przy czym mogą się one kompensować.

Rośnie zatem ilość elementów systemu (wzrost ilościowy) oraz liczba połączeń między nimi (nowa jakość). W ten sposób z prostszych organizmów powstają bardziej złożone. Podobnie jest w technice (od prostych narzędzi do skomplikowanych urządzeń), przyrodzie nieożywionej (związki chemiczne czy kosmologia) i sferze społecznej - od jednostki, przez rosnące grupy, plemiona, społeczności lokalne czy regionalne do państw narodowych i wreszcie grup państw, międzynarodowych organizacji, społeczeństwa globalnego. Zatem rozwój systemu to rozwój jego "sieciowości" (networking).

Tę metaregułę odnajdziemy w każdej biologicznej komórce. Wyspecjalizowane struktury komórek tworzą tkanki, będące na wyższym poziomie podstawą dla organów i w końcu ich układów składających się na całość organizmu. Dostrzeżenie tych zależności w połączeniu z organizacją wytwarzania (produkcji) doprowadziło do krytyki tradycyjnych, scentralizowanych i reaktywnych systemów zarządzania, owocując alternatywnym modelem BMS (Bionic Manufacturing System, tab.1.) opartym na biorarchii (bionic hierarchy, biorarchy) i genetyczną reprezentację informacji (GRI), odpowiadającą dynamicznym strukturom DNA.

Coś albo nic

W tym miejscu nasuwa się pytanie o genezę przyszłej, "silnej" sztucznej inteligencji. Czy należy spodziewać się jej wskutek powstawania coraz bardziej wyrafinowanych algorytmów, czy też raczej jako efekt łączenia się ich ze sobą, nawet jeśli nie są zbyt wyrafinowane jednostkowo? I tu można dostrzec analogię do procesów, którym sami podlegamy jako gatunek: jesteśmy odrębnymi jednostkami, ale istnieje też wymiar świadomości zbiorowej. Ten ostatni, potęgując się, będzie powodował także wzrost i zmianę owego indywidualnego. Działanie podobnego sprzężenia można już dziś zaobserwować w globalnych sieciach teleinformatycznych.

Jeden z prekursorów sztucznej inteligencji, angielski filozof Thomas Hobbes (połowa XVII w.),jeszcze przed Gottfriedem Leibnizem, sprowadzał procesy myślowe do operacji arytmetycznych, mówiąc: "przez rozumowanie rozumiem rachowanie" (per ratiocinationem autem intelligo computationem). Oczywiście, że na niskim poziomie abstrakcji można dopatrzyć się takich mechanizmów w mózgu, choćby stosując logikę zero-jedynkową. Tak prosta logika może być dostrzeżona wszędzie, skoro opisuje różnicę między "czymś" a "niczym".

Neuron może być aktywny lub nieaktywny. Impuls elektromagnetyczny może zostać przesłany lub nieprzesłany. Kation wapnia może być transportowany lub nie. Jednak niewiele z tego wynika dla bardziej złożonych zjawisk, takich jak fenomeny wyższych stanów świadomości. Równie dobrze można by je sprowadzić do jakiegoś innego, prostego i powszechnie występującego zjawiska, mówiąc np., że "rozumowanie to ruch atomów". Owszem, też, ale nie tylko. Na tym właśnie polega istota systemowości, że system jest czymś więcej niż tylko sumą jego elementów składowych.

Informatyczna kosmologia

Nie każde zagadnienie daje się rozwiązać drogą redukcjonizmu, tj. rozkładu kompleksowego problemu na coraz prostsze problemy cząstkowe. Takie podejście nasuwa skojarzenia z matematycznym indukcjonizmem, a zatem nadaje się do rozwiązywania dość wąskiej klasy problemów - matematycznych czy logicznych właśnie. A więc takich, w których dysponujemy formalnie zdefiniowanymi modelami o jednoznacznych warunkach brzegowych i stanach wewnętrznych, co umożliwia ich przetwarzanie na drodze aksjomatyczno-dedukcyjnej. Tymczasem praktyka obfituje w sytuacje charakteryzujące się wysokim stopniem niepewności, wybitnie kontekstowej wiedzy, która może być różnorodnie interpretowana - od medycyny do ekonomii i od socjologii do sfery prawnej.

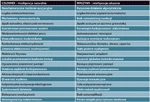

Tab. 2. Charakterystyka różnic między człowiekiem a maszyną

Wystarczy zacytować stosowną definicję encyklopedyczną: "paranoja należy do grupy przewlekłych psychoz z charakterystyczną obecnością rozbudowanego systemu, logicznie powiązanych i spójnych z osobowością chorego, urojeń; systemowi temu podporządkowana jest cała aktywność chorego". Centralną częścią tej definicji jest "spójność i logiczność systemu", co znakomicie pokrywa się z charakterystyką komputera (czy szerzej każdego mechanizmu); paranoja to przecież "obłęd systematyczności". Sztuczna inteligencja, jeśli chce być uniwersalnie efektywna, musi przekształcać się w naturalną, zacierając różnice między człowiekiem a maszyną (tab. 2). Czy jest to w ogóle możliwe?

Tak. Wynika to z pokazanej wcześniej zasady rekurencyjności ewolucyjnej. Nasza świadomość wyewoluowała z materii nieożywionej, a więc całkowicie nieświadomej. Dlaczego zatem w podobnym procesie martwe maszyny nie miałyby przekształcić się z czasem w rodzaj inteligentnego organizmu? W końcu najbardziej złożony obiekt wszechświata, ludzki mózg, powstał w efekcie procesu zapoczątkowanego bigbangowym ruchem atomów najprostszego z pierwiastków - wodoru.

Ale tu docieramy jednocześnie do granic naszego poznania. Nie wiemy bowiem, co było przed Wielkim Wybuchem (o ile słowo "przed" jest stosowne w obliczu wydarzenia, które było także początkiem czasu), jaka była jego przyczyna, a zwłaszcza jak wygląda "program" sterujący całym dalszym rozwojem materii. Być może bez odpowiedzi na te pytania utrudnione będą dalsze postępy prac nad sztuczną inteligencją. Okazuje się zatem, że z pozoru "niepraktyczne" obszary nauki, takie jak kosmologia zajmująca się odległymi galaktykami, wykazują związki z bardzo użytecznymi, czy wręcz komercyjnymi pytaniami, które tu, na Ziemi, ciągle czekają na odpowiedź.