Droga energio! Co oznaczają podwyżki cen prądu dla centrów danych

-

- 17.03.2020, godz. 06:59

Rozwój technologii procesorów, systemów chłodzenia i zasilania awaryjnego, a także wirtualizacja i chmura zahamowały wzrost zużycia energii przez centra danych. Wydaje się jednak, że już wkrótce rosnące zapotrzebowanie na moc przetwarzania oraz ilość przechowywanych i przesyłanych danych może zmienić tę korzystną tendencję.

Rosnące ceny energii elektrycznej mają duży wpływ na koszty funkcjonowania centrów danych, bo ich średni udział w tych kosztach to ok. 40%. Takich kwot nie można nie uwzględnić w długofalowym planowaniu biznesu. Firmy nie mają bezpośredniego wpływu na ceny energii, ale ich wzrost powoduje, że wciąż zmieniają się kalkulacje opłacalności inwestycji w rozwiązania zapewniające większą energooszczędność.

Jak rosną ceny energii

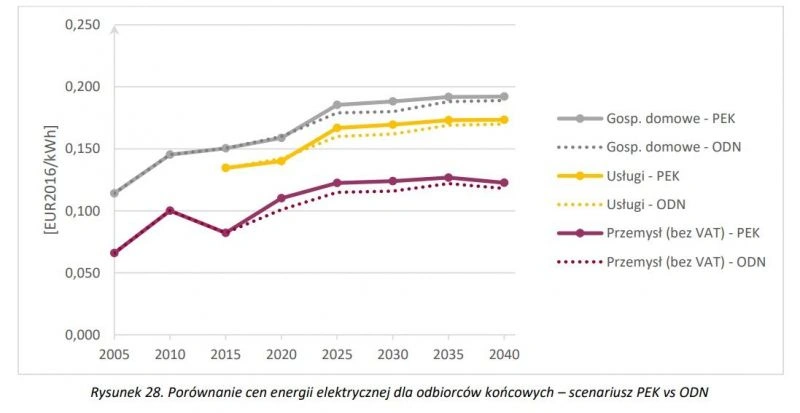

Według wyników analiz opublikowanych przez Instytut Energii Odnawialnej w raporcie „Prognoza cen energii elektrycznej do 2040 roku” wzrost kosztów produkcji energii, a w efekcie jej cen dla odbiorców jest nieunikniony i będzie trwałym trendem w dającym się przewidzieć okresie.

Zobacz również:

- AI ma duży apetyt na prąd. Google znalazł na to sposób

- Zasilanie infrastruktury IT - oto najpopularniejsze zagrożenia

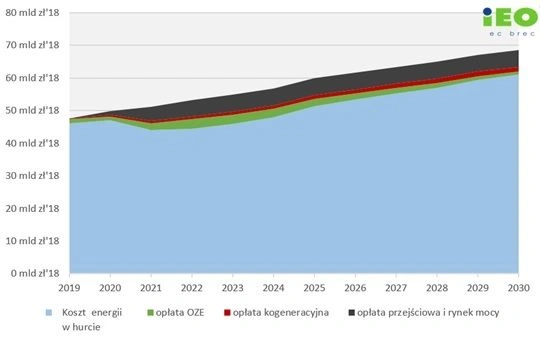

Prognoza wzrostu kosztów wytwarzania energii w Polsce. Źródło – IEO „Średnio okresowa prognoza kosztów wytwarzania i cen na energie elektryczną do 2040 roku”.

Zdaniem analityków z IEO największego wzrostu kosztów energii należy spodziewać się w latach 2020-2025, z 284 do 318 zł/MWh (w cenach stałych, bez uwzględnienia inflacji). W raporcie wykorzystano dane zawarte w rządowych projektach takich jak „Krajowy plan na rzecz energii i klimatu na lata 2021-2030” oraz scenariuszach PEK (Polityki Energetyczno-Klimatycznej).

Prognoza wzrostu cen energii elektrycznej. Źródło: Krajowy plan na rzecz energii i klimatu na lata 2021-2030.

Zużycie energii przez centra danych

Kilkanaście lat temu w mediach pojawiały się alarmujące prognozy o przewidywanym wzroście zużycia energii przez centra danych i infrastrukturę sieciową, który może doprowadzić do sytuacji, gdy teoretycznie prawie cała wytwarzana globalnie energia byłaby niezbędna do utrzymania systemów IT. Analizy te były jednak oparte na prostej ekstrapolacji znanych wówczas technologii oraz obserwowanych trendów.

Teraz analitycy są nieco ostrożniejsi, choć od czasu do czasu znów pojawiają się kolejne niepokojące prognozy dotyczącej wzrostu zużycia energii w sektorze IT. W ostatniej dekadzie globalne zużycie energii przez infrastrukturę IT ustabilizowało się. Wynosi ono średnio ok. 1% całej produkowanej energii elektrycznej, choć w niektórych krajach, np. w Stanach Zjednoczonych, jest wyraźnie większe i sięga nawet 3%.

Dane takie są prezentowane w raporcie "Global data centre energy demand by end use" opublikowanym przez International Energy Agency, która systematycznie śledzi zużycie energii w różnych obszarach gospodarki światowej.

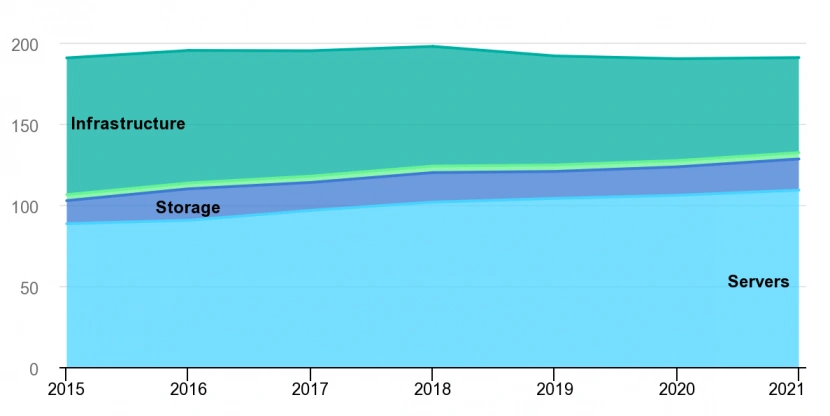

Rozwój technologii pozwolił na zahamowanie globalnego wzrostu zapotrzebowania na energię elektryczną mimo znacznego zwiększenia mocy przetwarzania systemów IT, pojemności pamięci masowych oraz wzrostu transmisji danych w sieciach. W latach 2015-2020 energia pobierana przez centra danych utrzymywała się na stabilnym poziomie poniżej 200 TWh rocznie.

Mimo systematycznego wzrostu mocy przetwarzanie, pojemności zasobów pamięci i przepustowości sieci, ich zużycie w ostatnich latach nie wzrosło, a nawet nieco spadło. Źródło: Raport „Global data centre energy demand by end use”, IEA, Paris, styczeń 2020.

Zahamowanie zużycia energii przez centra danych wynikło z rozwoju energooszczędnych technologii oraz pojawienia się nowych modeli biznesowych. Systematyczny spadek poboru mocy przez procesory, pamięci masowe, popularyzacja wirtualizacji i chmury oraz pojawienie się tzw. hiperskalowych centrów przetwarzania danych o wysokiej efektywności energetycznej to główne przyczyny tej stabilizacji.

Wirtualizacja pozwala na zwiększenie wykorzystania serwerów i zmniejszenia strat energii związanych z utrzymywaniem maszyn bezczynnych lub mało wykorzystywanych. Jeśli chodzi o pamięci masowe to systematycznie rośnie popularność energooszczędnych pamięci półprzewodnikowych, takich jak dyski SSD, a także nowej generacji pamięci SCM (np. Intel Optane).

Utrzymanie obecnego poziomu zużycia energii nie będzie jednak łatwe. Na przykład upowszechnienie wirtualizacji dało efekty, ale obecnie, gdy prawie wszystko zostało zwirtualizowane, nie można oczekiwać kolejnych korzyści.

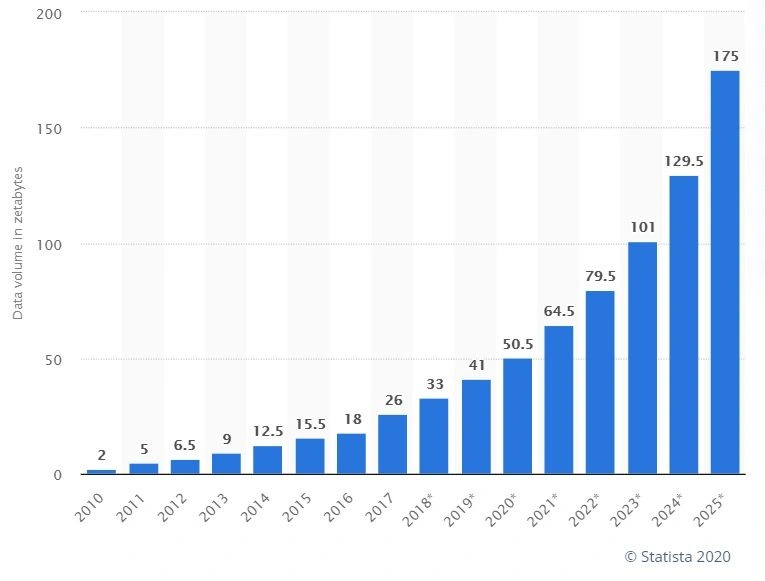

A według prognoz liczba danych, a więc też zapotrzebowanie na pojemność pamięci masowych, będzie szybko rosła. Firma analityczna Statista przewiduje, że w latach 2020-2025 wzrośnie około 3,5-krotnie do poziomu 175 zetabajtów. Czy efektywność energetyczną pamięci masowych uda się zwiększyć w podobnym stopniu? Jest to możliwe jeśli dyski mechaniczne będą masowo zastępowane przez energooszczęden pamięci półprzewodnikowe, ale tu będą decydować kalkulacje ekonomiczne.

Perspektywy wzrostu liczby danych generowanych w systemach IT. Źródło: Statista.

Natomiast według Cisco globalny ruch w internecie w latach 2015-2022 wzrośnie6-krotnie, liczba mobilnych użytkowników internetu zwiększy się z 3,6 mld w 2018 roku do 5 mld w roku 2025. Z kolei liczba połączeń z urządzeniami IoT w tym okresie wzrośnie z 7,5 mld do 25 mld, jak przewiduje GSM Association. Choć w porównaniu do energii zużywanej przez procesory i pamięci masowe systemy sieciowe mają wciąż względnie mały udział, tak szybko rosnąca transmisja danych też może się przyczynić do istotnego wzrostu zapotrzebowania na energię.

Jednocześnie warto zwrócić uwagę, że pojawiają się nowe aplikacje o bardzo dużych wymaganiach na moc przetwarzania, na przykład oprogramowanie bazujące na algorytmach sztucznej inteleigencji. Ich popularyzacja może istotnie wpłynąć na wzrost poboru mocy przez centra danych. Za to rozwój technologii umożliwiających zmniejszanie poboru mocy przez procesory, generatory i zasilacze UPS oraz systemy chłodzenia ma też fizyczne granice. A w przypadku klasycznych rozwiązań nie można ich przekroczyć.

Dlatego perspektywy utrzymania obecnego poziomu zużycia energii poniżej 200 TWh rocznie mogą być krótkotrwałe. Niektórzy specjaliści przewidują, że już w 2022 roku rozpocznie się kolejna faza wzrostu i wrócimy do sytuacji, która miała miejsce w pierwszej dekadzie XXI wieku.

Czy liczba centrów danych będzie rosła?

Na całkowity poziom zużycia energii wpływ ma też liczba centrów danych i ich wielkość, bo przekłada się na średnią wielkość poboru mocy przez systemy ICT w skali globalnej lub regionalnej. Czy więc liczba centrów danych będzie się zwiększała? Prognozy są różne i czasami na pozór sprzeczne.

Na przykład według raportu Gartnera „The Data Center Is (Almost) Dead” opublikowanego w lutym 2019 roku, w skali globalnej zaledwie 17% budżetów IT jest przeznaczanych na inwestycje w firmowe centra danych, a aż 80% firm planuje zamknąć własne ośrodki przetwarzania danych do roku 2025.

Jak uważają analitycy Gartnera klasyczne centra danych są zastępowane głównie przez firmy świadczące usługi kolokacyjne i chmurowe, które oferują wysoką dostępność, niezawodność, efektywność energetyczną, możliwość skalowania systemów oraz zapewniają dostępność wysoko wykwalifikowanych specjalistów od zarządzania infrastrukturą. W efekcie własne, firmowe centra danych będą coraz częściej wykorzystywane do obsługi jedynie najważniejszych, krytycznych procesów biznesowych wymagających szczegółowej kontroli, która często nie jest dostępna na odpowiednim poziomie w przypadku rozwiązań hostowanych lub chmurowych.

Natomiast w raporcie „Data Center 2025: Closer to the Edge” opublikowanym w czerwcu 2019 roku przez firmę Vertiv prezentowana jest prognoza, że do 2025 roku liczba serwerowni wzrośnie aż o 226%.

Nie są to jednak sprzeczne prognozy, bo Gartner skupił się na dużych centrach danych, a Vertiv na widocznym ostatnio wzroście popularności rozwiązań wykorzystujących przetwarzanie danych na brzegu sieci (Edge Computing), gdzie wykorzystywane są małe lub miniaturowe centra danych (serwery).

Czy woda zastąpi powietrze?

Według analityków z organizacji Association For Computer Operations Management, w przypadku typowych aplikacji biznesowych średnia niezbędna moc zasilania to ok. 7 kW na jedną szafę stelażową. Ale uruchomienie aplikacji wykorzystujących mechanizmy sztucznej inteligencji może zwiększyć zapotrzebowanie na moc nawet do poziomu 30 kW dla jednej szafy.

Sztuczna inteligencja to jeden z przykładów aplikacji wymagających szczególnie dużej mocy zasilania, bo z reguły wykorzystuje maksymalną dostępną moc przetwarzania procesorów, a często też dodatkowe układy graficzne. GPU w porównaniu do układów CPU pozwalają o rzędy wielkości zwiększyć moc przetwarzania, ale niestety pobierają nawet 2 razy więcej energii. A wzrost gęstości mocy przetwarzania zwiększa wymagania na chłodzenie co oznacza dodatkowe zużycie energii.

Typowe, powszechnie wykorzystywane systemy do chłodzenia powietrzem mogą niezawodnie pracować do poziomu ok. 15 kW na szafę stelażową. A ponieważ płyny takie jak woda mają pojemność cieplną nawet 3 tys. razy większą niż powietrze, ich wykorzystanie umożliwia znacznie bardziej efektywne i energooszczędne chłodzenie procesorów.

Systemy chłodzenia wodą nie są nowością. Są znane i wykorzystywane od wielu lat, ale wciąż jeszcze ich populartność jest względnie mała i nie znajdują masowych zastosowań. Dlatego najwięksi producenci infrastruktury zasilania i chłodzenia dopiero się przymierzają do wprowadzenia do oferty tego typu rozwiązań.

Obecnie oferowane są one głównie przez mniejsze firmy, a czasami samodzielnie opracowywane i wdrażane na przykład przez dużych dostawców usług chmurowych i kolokacyjnych. Na przykład, w centrach danych OVH wykorzystujących setki tysięcy serwerów wykorzystywany jest samodzielnie opracowany system chłodzenia procesorów przy pomocy wody. Na pozór mogłoby się wydawać, że nie jest to trudne. W praktyce wdrożenie takiego systemu wymaga rozwiązania wielu problemów technicznych.

Układy chłodzące muszą być odpowiednio dopasowane do różnego typu procesorów, których parametry i wymiary fizyczne się zmieniają. Dodatkowo trzeba zapewnić mechanizmy filtrowania wody by osadzający się kamień nie spowodował zatorów, opracować niezawodne połączenia przewodów przepływowych by serwery można było łatwo wymieniać itp. A wszystko to przy założeniu, że nie pojawią się awarie zagrażające bezpieczeństwu infrastruktury, a jednocześnie koszty wdrożenia będą uzasadnione ekonomicznie.

Pamiętajmy, że większość centrów danych była projektowana pod kątem wykorzystania klasycznych systemów chłodzenia powietrzem i ich przystosowanie do chłodzenia wodą wymaga często istotnej i kosztownej modernizacji infrastruktury. Dlatego chłodzenie wodą jest obecnie stosowane głównie w systemach High Performance Computing lub systemach hiperkonwergentnych o dużej gęstości upakowania serwerów.

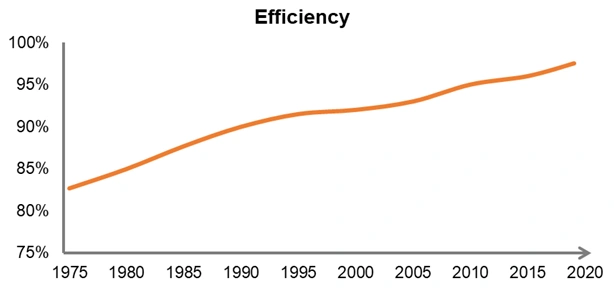

Praktyczna efektywność zasilania i chłodzenia

W przypadku współczesnych zasilaczy awaryjnych ich efektywność to 97-99%, inaczej mówiąc straty energii są mniejsze niż 3%. Ale można je jeszcze nieco ograniczyć. Przykładowo, system Vertiv Dynamic Online, składający się z kontrolerów zasilaczy awaryjnych oraz specjalnego oprogramowania sterującego ich pracą, wedle zapewnień producenta pozwala na uzyskanie do 2% oszczędności w zużyciu energii. W wypadku dużych serwerowni te 2% może być warte dodatkowej inwestycji.

Ale przy efektywności 99% trudno będzie opracować nowe rozwiązania, które będą na tyle tanie by oszczędność energii na poziomie ułamka procenta dała zwrot z inwestycji w sensownym czasie. Poza tym podawane parametry odpowiadają obciążeniom zbliżonym do wartości maksymalnej, a jeśli pobór mocy spadnie poniżej założonego poziomu, to z reguły rosną straty energii.

Podobnie jest w przypadku systemów chłodzenia, których efektywność zależy od warunków panujących w otaczającym środowisku, jak temperatura lub wilgotność. W efekcie podawane przez producentów nominalne parametry systemów zasilania i chłodzenia mogą się znacząco różnić od praktycznie uzyskiwanych w zależności od obciążenia systemu, pory roku lub regionu w którym jest zlokalizowane centrum danych.

Wzrost efektywności zasilaczy UPS na przestrzeni ostatnich 40 lat spowodował, że zbliżyła się ona do ostatecznej granicy 100%. Źródło: Vertiv.