Data center – perspektywy rozwoju

-

- Sylwester Igras,

- 21.01.2014

Pierwsza dekada XXI wieku to ciągły wzrost znaczenia systemów teleinformatycznych w organizacjach zarówno biznesowych, jak i administracyjnych, który skutkuje zwiększaniem wymagań, jakie są stawiane przed centrami danych,w tym również infrastrukturze fizycznej.

Rozwój technologii serwerowych i popularyzacja rozwiązań wirtualizacyjnych powoduje, że stosuje się coraz częściej technologie wysokiej gęstości, które mają wyższe wymagania dotyczące zasilania i stwarzają większe wyzwania przed systemami chłodzenia. Infrastruktura fizyczna, w tym systemy zasilania i chłodzenia, musi się więc dostosować do zmian technologicznych urządzeń IT oraz zwiększonych wymagań w zakresie

wydajności i dostępności systemów teleinformatycznych dla przedsiębiorstw. Odejście od utrwalonych rozwiązań klasycznych nie postępuje jednak zbyt szybko i nowe rozwiązania w zakresie infrastruktury dość

Zobacz również:

powoli zdobywają rynek.

BARIERY MODERNIZACJI

Według Google w ponad połowie obecnie funkcjonujących na świecie centrów przetwarzania danych w dalszym ciągu wykorzystywane są klasyczne rozwiązania. Częstą przyczyną tego jest fakt, że modernizacja infrastruktury przed upływem okresu amortyzacji, czyli zwykle około kilku lat, jest z oczywistych względów dość trudna do zaakceptowania przez decydentów. W związku z tym większość spośród istniejących obecnie obiektów CPD to ośrodki, które nie są wyposażone w najnowsze rozwiązania, jakie są obecnie dostępne na rynku. Jednak wielu użytkowników zaczyna już dzisiaj odczuwać ograniczenia, wynikające ze stosowania technologii starszych generacji, takie jak problemy z zaspokojeniem zapotrzebowania na coraz większą ilość energii i równoczesne trudności z odpowiednim schłodzeniem urządzeń oraz niską efektywnością energetyczną. Aby sprostać wymogom instalacji sprzętu teleinformatycznego nowej generacji, często muszą oni przeprowadzać gruntowną modernizację oraz przebudowę infrastruktury zasilania i chłodzenia.

INFRASTRUCTURE AS A SERVICE

Najbardziej innowacyjne systemy zasilania i chłodzenia zapewniają wysoką sprawność energetyczną oraz możliwość obsługi urządzeń o wysokiej gęstości upakowania, lecz są najczęściej stosowane w centrach nowo budowanych oraz w tych, gdzie od podstaw modernizuje się infrastrukturę. W tym miejscu warto wspomnieć, iż dla modernizacji bądź rozbudowy infrastruktury centrów danych pojawiła się ostatnio alternatywa w postaci cloud computing (polegająca na outsoursowaniu części zasobów IT na zewnątrz w formie usług), w szczególności usług określanych skrótem IaaS (Infrastructure as a Service), polegających na udostępnianiu przez usługodawcę serwerów wraz z pozostałą infrastrukturą.

SCENTRALIZOWANY SYSTEM ZARZĄDZANIA

Od współczesnych systemów zarządzania infrastrukturą zasilania i chłodzenia oczekuje się kompleksowej informacji oraz monitorowania wielu parametrów już na poziomie pojedynczej szafy, w celu zapewnienia

niezawodnego działania sprzętu teleinformatycznego. Scentralizowany system zarządzania układami zasilania i chłodzenia w znaczący sposób zmniejsza bowiem ryzyko wystąpienia przestojów. Wszystkie zasoby

w tym parametry zasilania i chłodzenia, powinny być monitorowane, koordynowane i zarządzane przez zintegrowany system centralny. W ostatnim okresie wzrasta więc zapotrzebowanie na takie rozwiązania, wpływając na znaczący rozwój nowego segmentu rynku, tj. oprogramowania DCIM (Data Center Infrastructure Management) – umożliwiającego zaawansowane monitorowanie i inteligentne zarządzanie całą infrastrukturą fizyczną, w tym systemami zasilania i chłodzenia. Motorem wpływającym na zwiększenie zainteresowania oprogramowaniem do centralnego zarządzania jest również coraz powszechniejsze stosowanie

wirtualizacji, która redukując liczbę potrzebnych serwerów fizycznych w centrum danych lub serwerowni, jednocześnie zwiększa poziom złożoności zarządzania zarówno nimi, jak i pozostałą infrastrukturą. Aby więc zapewnić wysoką dostępność i efektywność energetyczną centrum przetwarzania danych po przeprowadzonej wirtualizacji, konieczne staje się zapewnienie jak najściślejszej współpracy infrastruktury fizycznej z systemem teleinformatycznym. Oprogramowanie zarządzające systemami zasilania i chłodzenia powinno współpracować z systemami zarządzania maszynami wirtualnymi, takimi jak np. VMware VCenter, Microsoft

SCVMM i XenCenter, integrując z nimi funkcje zarządzania zasilaniem i chłodzeniem. Dzięki takiej funkcjonalności wszystkie zasilacze UPS i jednostki dystrybucji mocy PDU, będące w sieci wirtualnej, mogą być monitorowane przy użyciu jednej aplikacji, w której będą również dostępne informacje o fizycznym serwerze sieciowym i systemach pamięci.

Scentralizowany system zarządzania układami zasilania i chłodnienia w znaczący sposób zimniejsza bowiem ryzyko wystąpienia przestojów. Wszystkie zasoby, w tym parametry zasilania i chłodzenia, powinny być monitorowane, koordynowane i zarządzane przez zintegrowany system centralny.

ZIELONE DATA CENTER

Efektywność energetyczna jest obecnie jednym z głównych kryteriów uwzględnianych przy budowie i modernizacji centrów przetwarzania danych. Centra danych oraz serwerownie pracują bowiem w trybie ciągłym, tj.przez całą dobę, siedem dni w tygodniu, tak więc moc i sprawność zainstalowanych tam urządzeń, w tym infrastruktury zasilania i chłodzenia, ma decydujący wpływ na rachunki za energię elektryczną. Mimo iż

obecnie ceny energii w naszym kraju nie należą do najwyższych w Europie, to prognozy nie są zbyt optymistyczne, co wynika chociażby z konieczności modernizacji krajowej elektroenergetyki czy sfinansowania takich projektów, jak budowa masowych systemów do odczytów energii elektrycznej, tzw. Smart Metering. Wzrastające koszty utrzymania coraz bardziej wydajnych, lecz wymagających również jak najskuteczniejszego chłodzenia systemów informatycznych zmuszają do szybkiego podjęcia kroków zmierzających do ograniczenia poboru energii. W wielu przypadkach, w wyniku przeprowadzenia analiz, okazuje

się, iż przebudowa istniejącego centrum danych jest nieopłacalna. Niektóre firmy decydują się więc na wybudowanie całkiem nowych obiektów zaprojektowanych zgodnie ze współczesnymi normami i zaleceniami technicznymi, uwzględniającymi kwestie wydajności energetycznej. Autorzy raportu 2012 Energy Efficient IT (www.cdw.com.EnergyEfficient) opublikowanego przez firmę CDW podkreślają, że wdrożenie energooszczędnych rozwiązań oraz uzyskanie realnych korzyści z tego typu inwestycji jest dużo łatwiejsze, niż się obiegowo sądzi. Koszty budowy tzw. zielonego centrum danych nie są wiele wyższe (średnio

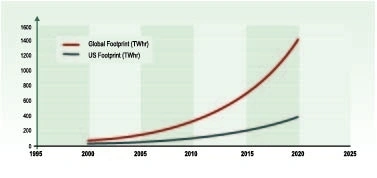

jedynie o ok. 10%) niż w przypadku centrum opartego na rozwiązaniach tradycyjnych. Największe firmy informatyczne są więc w trakcie wdrażania programów – lub już je przeprowadziły – mających na celu poprawę efektywności energetycznej swoich obiektów. Taki punkt widzenia coraz częściej podzielają nie tylko giganci z branży teleinformatycznej, posiadający największe centra danych, lecz również mniejsze firmy z branży IT. Najnowocześniejsze i najbardziej wydajne energetycznie centra danych wykorzystują sprzęt o największej wydajności, a także odnawialne źródła energii. Wartość współczynnika PUE – Power Usage Effectiveness (obecnie najczęściej używanego wskaźnika efektywności) dla obecnie funkcjonujących data center zawiera się zwykle w przedziale pomiędzy 2,0 a 2,5, lecz dla tych nowo budowanych lub modernizowanych oczekuje się już wartości znacznie niższych, tj. w granicach 1,0–1,3. Innym ważnym powodem stosowania energooszczędnych systemów zasilania i chłodzenia jest kwestia ochrony środowiska naturalnego, jak bowiem powszechnie wiadomo, produkcja energii elektrycznej jest najczęściej związana z jego zanieczyszczaniem (wyjątkiem są oczywiście tzw. odnawialne źródła energii, jak np. elektrownie wiatrowe i wodne). W raporcie Worldwide Electricity Used in Data Centers udział energii konsumowanej przez centra przetwarzania danych w całkowitym zużyciu szacuje się na 1,1 do 1,5%, a wzrost konsumpcji energii przez CPD w latach 2005–2010 w ujęciu globalnym na 56%. Należy jednak zauważyć, iż w ostatnim okresie znacznie spadła dynamika wzrostu, gdyż jeszcze w latach 2000–2005 zużycie energii przez centra danych wzrosło aż dwukrotnie. Spadek dynamiki wzrostu zużycia energii przez centra danych wynika niewątpliwe w znacznej mierze z faktu, iż systematycznie rośnie liczba firm, które decydują się na inwestycje w energooszczędną infrastrukturę fizyczną oraz stosowanie coraz powszechniej techniki wirtualizacji. Najbliższa przyszłość raczej nie przyniesie rewolucyjnych zmian, a obecnie występujące trendy będą wkrótce kontynuowane.

EFEKTYWNIEJSZE SYSTEMY ZASILANIA

Rosnące zapotrzebowanie na energię elektryczną w związku z modernizacją i konsolidacją centrów przetwarzania danych wpływa niewątpliwe na tendencję wzrostową sprzedaży zasilaczy awaryjnych, szczególnie

tych dużych mocy, które zasilają serwerownie i centra przetwarzania danych. Według danych Frost & Sullivan obecna wartość europejskiego rynku UPS wynosi prawie 2 mld dol., a w 2015 roku prawdopodobnie osiągnie poziom 2,3 mld dol. Najnowsze UPS-y zbudowane w technologii „on-line” mają efektywność na poziomie 95%, a zatem jedynie ok. 5% energii jest tracone bądź pobierane na potrzeby własne zasilacza. To duża różnica w stosunku do wcześniej stosowanych rozwiązań, dla których górną granicą sprawności był poziom pomiędzy 85 a 90%. Najnowocześniejsze centra uwzględniają możliwości wykorzystania odnawialnych źródeł energii, takich jak ogniwa słoneczne czy ogniwa paliwowe. Ogniwo paliwowe (Fuel cell) jest urządzeniem, w którym podczas elektrochemicznej reakcji łączenia wodoru z tlenem powstaje prąd elektryczny, a odpadowym produktem jest woda. Istnieje wiele typów ogniw paliwowych, różniących się rozwiązaniami konstrukcyjnymi, elektrolitem czy temperaturą pracy (80ºC ÷ 1000ºC), jednak na razie są to urządzenia dużo droższe od konwencjonalnych źródeł energii elektrycznej, takich jak np. generatory prądotwórcze. Dla akumulatorów powszechnie stosowanych w zasilaczach UPS też pojawiła się alternatywa w postaci np. ultrakondensatorów. Wśród wielu firm zajmujących się produkcją zasilaczy UPS daje się zauważyć tendencja wzbogacania oferty produktów w kierunku rozwiązań integrujących systemy klimatyzacji oraz kompleksowego zarządzania infrastrukturą serwerowni.

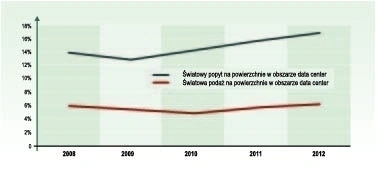

Przyrost popytu i podaży powierzchni w data center

WYDAJNE SYSTEMY CHŁODZENIA

Postępujący wzrost zagęszczenia urządzeń teleinformatycznych prowadzący do większej ilości wydzielanego ciepła stawia znacznie wyższe wymagania przed systemami chłodzącymi. Dodatkowym problemem jest

to, iż urządzenia, które wydzielają duże ilości ciepła są zwykle nierównomiernie rozłożone w pomieszczeniu, powodując powstawanie miejsc, w których temperatura może być znacznie wyższa od wartości średniej.

Stosowane do tej pory typowe rozwiązania chłodzące nie radzą sobie w wystarczający sposób z obciążeniem cieplnym na takim poziomie. Coraz częściej stosuje się więc systemy chłodzenia przeznaczone dla systemów teleinformatycznych (CRAC – Computer Room Air Conditioner), które są w stanie zapewnić nie tylko wyższą efektywność, ale również wilgotność na poziomie zgodnym z zaleceniami producenta sprzętu

teleinformatycznego. Obecnie można zaobserwować trend podnoszenia wartości dopuszczalnej temperatury w pomieszczeniu serwerowni, dzięki czemu ogranicza się potrzebną moc systemu chłodzenia, co oczywiście wpływa na zmniejszenie kosztów. Według Intela, w Europie w zdecydowanej większości centrów danych temperatura jest utrzymywana na poziomie 19–21ºC. Rośnie jednak liczba firm, które decydują się na jej podniesienie przynajmniej do poziomu 27ºC, który już obecnie jest zgodny z aktualnymi standardami. Jako przykład można tutaj podać Microsoft, który zwiększył temperaturę w swoich centrach o 4ºC, uzyskując

oszczędność 250 tys. dol. w skali roku. Wyższa dopuszczalna temperatura zwiększa również możliwość zastosowania tzw. free-coolingu, polegającego na wykorzystaniu do chłodzenia niskiej temperatury występującej w chłodnych porach roku. Dodatkową zaletą tej technologii jest to, iż w przypadku braku zasilania z sieci energetycznej, aby podtrzymać system chłodzenia, wystarczy zastosować zasilacze UPS do zasilania pompy wodnej oraz wentylatorów. Obecnie najbardziej wydajne systemy chłodzenia to układy z wodą lodową, które pozwalają na dodatkowe zwiększenie efektywności poprzez wykorzystanie technologii free--coolingu.

KOMPAKTOWOŚĆ

Zwiększanie upakowania i kompaktowości systemów infrastruktury fizycznej będzie najprawdopodobniej jednym z ważniejszych trendów w najbliższych latach, aż do momentu, gdy gęstość mocy serwerów

osiągnie ponad 40 kW na szafę. Obecnie wydaje się to barierą ekonomiczną, po przekroczeniu której dalsze zwiększanie gęstości stanie się nieopłacalne ze względu na problemy z zapewnieniem zasilania i chłodzenia

takich środowisk.

UPROSZCZENIE OBSŁUGI SPRZĘTU

Innym, coraz wyraźniej zaznaczającym się trendem, jest dążenie do maksymalnego uproszczenia obsługi sprzętu, która coraz częściej odbywać się będzie bezpośrednio z urządzeń IT (np. funkcja plug-and-

-play), kosztem obsługi stricte technicznej. Obecnie funkcjonujące systemy monitorowania i zarządzania umożliwiają odwzorowanie stanów oraz parametrów urządzeń i środowiska, Przyrost popytu i podaży powierzchni w data center Testy a także ich rejestrowanie i raportowanie oraz zapewniają integracje z istniejącymi systemami (np. BMS – Building Management System, ES – Enterprise Systems). Należy podkreślić

iż integracja z ww. systemami zarządzania w sposób umożliwiający bezpośrednią wymianę informacji pomiędzy nimi stwarza pewne trudności, gdyż dla zarządzania poszczególnych grup urządzeń wykorzystuje

się specjalne oprogramowanie. W niedalekiej przyszłości systemy monitorowania i zarządzania infrastrukturą fizyczną, oprócz realizowanych dziś funkcji wglądu w stan środowiska IT, będą najprawdopodobniej

także wspomagać projektowanie i sugerować działania optymalizujące bieżące funkcjonowanie centrum danych. Zdaniem analityków, w najbliższym okresie będzie postępował znaczący wzrost popytu na centralne

systemy zarządzania DCIM, którego głównym powodem będzie właśnie funkcjonalność ułatwiająca efektywne planowanie i skalowanie zasobów. Według badań przeprowadzonych przez 451 Research, rynek

tego oprogramowania, choć w tej chwili niezbyt duży (w 2012 r. był szacowany na ok. 430 mln dol.), będzie rósł w tempie 40% rocznie. W związku z coraz większą popularyzacją rozwiązań mechanizmów cloud computing, w najbliższej przyszłości coraz więcej usług teleinformatycznych będzie outsoursowanych. Budowane więc w tym modelu potężne serwerownie muszą być tak projektowane, aby mogły być elastycznie dopasowywane do aktualnych potrzeb. Ważną korzyścią dla klienta, wynikającą z korzystania z chmury jest skalowalność, która oznacza możliwość zapewnienia szybkiego alokowania zasobów.

WIELOFUNKCYJNE MODUŁY

Obserwując kierunki rozwoju i zachodzącą integrację poszczególnych systemów można przewidywać, że już w niedalekiej przyszłości większość centrów danych będzie budowana na bazie wielofunkcyjnych modułów

co określa się terminem: data center in a box, a których nieodłącznym elementem będą systemy zasilania i chłodzenia, wykorzystujące technologie, które wyewoluują z tych, już istniejących. Najbardziej

innowacyjną obecnie architekturą wydają się być modularne centra danych PFM (Pre-Fabricated Modular Data Center). Podstawową zaletą tego typu rozwiązań jest zwolnienie użytkowników z konieczności

wykonywania kosztownej i nierzadko bardzo żmudnej integracji elementów pochodzących od wielu producentów, gdyż wszystkie komponenty są testowane pod kątem zapewnienia współpracy już na

etapie produkcji. W rezultacie, czas wdrożenia powinien być skrócony, a jego koszt dużo mniejszy. Dodatkowo w przypadku sprzętu od jednego producenta skraca się zwykle czas usuwania potencjalnej awarii

gdyż mamy gwarancję na prawidłowe działanie całego zintegrowanego systemu i kontaktujemy się tylko z jedną linią wsparcia. Systemy zintegrowane mają jednak również wady – są z zasady mniej elastyczne

pod wzglądem konfiguracji zarówno oprogramowania, jak modułów sprzętowych, gdyż są one przeważnie budowane pod najczęściej spotykane potrzeby na rynku. Innym problemem jest uzależnienie się użytkownika od jednego producenta i brak możliwości doboru poszczególnych elementów, np. według kryterium najlepszego rozwiązania dostępnego na rynku w swojej klasie. Przy modernizacji lub rozbudowie systemu zbudowanego na podstawie innej architektury może wystąpić również problem z zapewnieniem współpracy pomiędzy systemami. Według opublikowanego przez The Green Grid raportu Deploying

and Using Containerized/Modular Data Centre Facilities architektura ta wpływa na zmniejszenie zużycia energii i ograniczenie potrzebnej powierzchni oraz zapewnia możliwość skalowania sytemu do aktualnych wymagań. Choć rozwiązania tej klasy wydają się być bardzo atrakcyjne, to jednak obecnie dużą barierą dla ich popularyzacji jest wciąż względnie wysoka cena, która jednak wraz ze wzrostem liczby zrealizowanych instalacji powinna zacząć spadać. Tego rodzaju rozwiązania wprowadzają już tacy potentaci rynku jak HP, Dell czy SGI.

Zużycie prądu w centrach danych – główny składnik kosztowy

i mogranicznik wzrostu

DEZAGREGACJA

Inną nowatorską metodą pozwalającą na ograniczenie wydatków dotyczących kosztów energii jest dezagregacja, czyli rozdzielenie zasobów obliczeniowych i pamięciowych w szafie serwerowej. Dezagragacja

pozwala przenieść do oddzielnych modułów zasoby technologiczne, które obecnie wchodzą w skład szafy, w tym komponenty obliczeniowe, pamięciowe i sieciowe oraz dystrybucję zasilania. Rozproszenie

umożliwia grupowanie różnych typów zasobów i ich dystrybucję do wszystkich serwerów w szafie, co obniża koszty utrzymania, a zarazem zwiększa elastyczność i niezawodność.