Ciepła woda chłodzi superkomputerową gorączkę w Monachium

W 2018 r. superkomputery w niemieckim Leibniz Supercomputing Center w Monachium zostaną zmodernizowane. Ich moc wzrośnie o ponad 26 petaflopsów. W listopadzie wejdą do pierwszej dziesiątki najszybszych komputerów na świecie. Lenovo chłodzi ich blisko 13 tys. procesorów za pomocą gorącej wody – są ku temu dobre powody.

W grudniu 2017 r. podpisano w Monachium umowy na budowę i dostawę wysokowydajnego superkomputera SuperMUC Next Generation (NG), który zostanie zainstalowany w Leibniz Supercomputing Center. Instytut przeniósł się w 2006 r. z centrum Monachium do Garching. Natomiast Uniwersytet Techniczny w Monachium i Uniwersytet Ludwig Maximilian od 1993 r. prowadziły badania wykorzystując superkomputery w specjalnie zbudowanej w tym celu "Twin Cube". W 2012 r. uruchomiono poprzednią platformę SuperMUC, która została rozbudowana w 2015 r. Obecnie posiada ona pojemność obliczeniową na poziomie 6,4 petaflopsa. Nawet w oryginalnym wydaniu był to najszybszy komputer w Europie.

Teraz jego moc będzie jeszcze większa. Kiedy budowany właśnie SuperMUC-NG zostanie uruchomiony z końcem 2018 r. będzie posiadał teoretyczną moc szczytową wynoszącą 26,7 petaflopsów.

Na aktualnej liście Top500 najszybszych superkomputerów na świecie, system znalazłby się na trzecim miejscu. Szybsze są tylko dwie chińskie maszyny: Sunway Taihu Light i Tianhe-2. Naukowcy z Monachium potrzebują takiej wydajności na potrzeby klasycznych zastosowań wysokowydajnych systemów komputerowych, w tym astrofizyki i mechaniki płynów.

Badania medyczne koncentrujące się na środowisku naturalnym, również mają coraz większe wymagania wobec technologii. Przykładowo, przeprowadzona w Leibniz Supercomputing Center symulacja trzęsienia ziemi na Sumatrze w 2004 roku, które spowodowało poważne zniszczenia na wybrzeżach Oceanu Indyjskiego, została nagrodzona tytułem "Best Paper" podczas konferencji Super Computing w 2017 r. Osiągnięcie takiego sukcesu było możliwe dzięki stworzeniu interdyscyplinarnego zespołu, w którego skład weszli przedstawiciele dwóch monachijskich uniwersytetów LMU i TUM. Efektem ich pracy była najbardziej wszechstronna symulacja trzęsienia ziemi w historii nauki. Kluczową rolę odegrała w tym przedsięwzięciu maszyna SuperMUC.

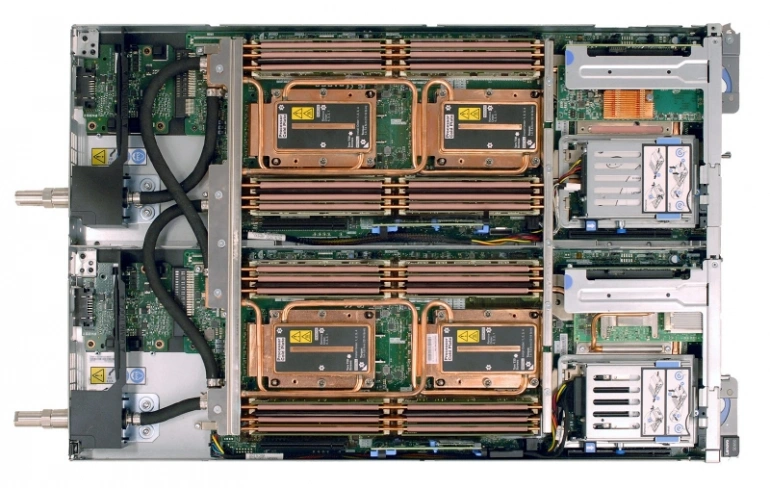

Chcąc zagwarantować, że tego typu badania będzie można prowadzić także w przyszłości, Leibniz Supercomputing Center, wraz z partnerami - Intelem i Lenovo, podjęli pracę nad budową SuperMUC-NG. Jednym z najważniejszych elementów nowego komputera, jest system chłodzenia wodą nie wymagający schłodzenia jej do temperatur typowych dla świeżej wody. Ta technologia, potocznie określana również jako "chłodzenie gorącą wodą", ma istotne zalety pod względem wydajności energetycznej. W przypadku poprzednich generacji SuperMUC osiągnięto oszczędności energii na poziomie około 35 procent w porównaniu do konwencjonalnych systemów chłodzenia. W przypadku SuperMUC-NG, powinny one przekroczyć - w porównaniu do konwencjonalnego układu chłodzenia o porównywalnej wielkości - około 45 procent. Takie podniesienie wydajności powinno również wystarczyć do zajęcia dobrego miejsce na liście najbardziej ekologicznych superkomputerów Green500.

Lenovo pomaga w maksymalnym wykorzystaniu możliwości nowych procesorów Xeon Scalable (Skylake-SP). Również w tym obszarze naukowcy z Leibniz Supercomputing Center korzystają z innowacyjnego chłodzenia zastosowanego w SuperMUC-NG. Dzięki wydajnemu chłodzeniu układów, można zastosować overclocking - procesory mogą być znacznie szybciej taktowane, a wydajność może zostać okresowo, jeszcze bardziej zwiększona. Parametry działania procesorów - szybkość zegara i zużycie energii - można zmieniać w czasie ich pracy. Umożliwia to oprogramowanie Lenovo Aware Run-Time (EAR). Zmiany można wprowadzać nawet jeśli uruchomione zostały wcześniej aplikacje. W rezultacie wymagania energetyczne dotyczące zadań obliczeniowych można również precyzyjnie z góry zdefiniować. Wcześniejsze partycjonowanie superkomputera, prowadzone zwykle wyłącznie w oparciu o dostępną moc obliczeniową, może zatem zostać rozszerzone o nowy, kluczowy element. Zadania są dystrybuowane przez system kolejkowania wsadowego oparty na SLURM, który działa pod kontrolą Suse Enterprise Linux 12 z modułem HPC.

W przypadku SuperMUC-NG ważne jest kontrolowanie zapotrzebowania na energię nie tylko w odniesieniu do chłodzenia procesorów. Od czasu instalacji pierwszego bezpośredniego systemu chłodzenia wodą w 2012 r, ciepło odpadowe jest wykorzystywane do ogrzewania budynków LRZ; w międzyczasie niektóre pobliskie gospodarstwa domowe również zostały wyposażone w centralne ogrzewanie.

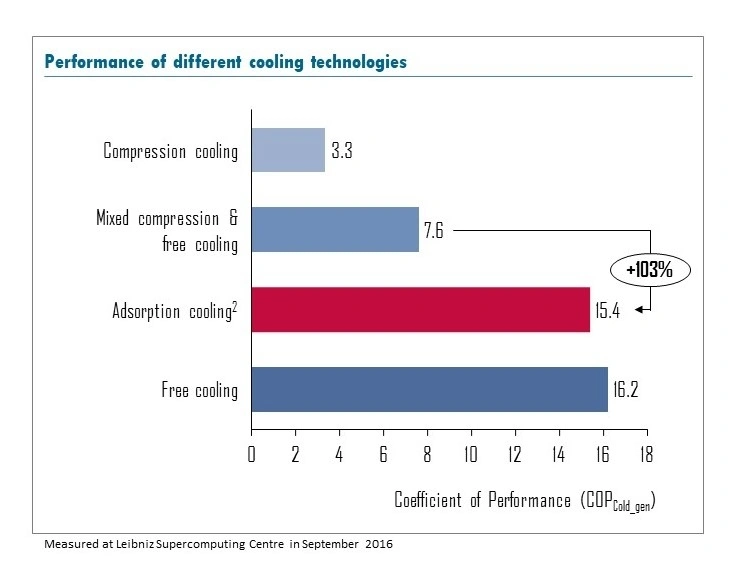

NG jest dodatkowo wyposażony w agregat adsorpcyjny, który służy do chłodzenia nie tylko procesorów, ale także innych komponentów Centrum Supercomputing Leibniz. Agregat adsorpcyjny został wyprodukowany przez niemiecką firmę Fahrenheit. Ten układ chłodzenia wykorzystuje ciepło odpadowe z SuperMUC-NG do generowania chłodzenia, oszczędzając w ten sposób dużą część energii elektrycznej i świeżej wody, która byłaby w przeciwnym wypadku niezbędna do realizacji tego procesu. Maszyna wykorzystuje mechanizm chłodzenia wodą do odprowadzenia ciepła odpadowego z procesorów przy ok. 52 ° C i do wytworzenia zimnej wody o temperaturze ok. 21 ° C. Zimna woda służy do chłodzenia komponentów pamięci masowej i sieci, które muszą działać w niższych temperaturach niż procesory.

Rysunek 1: Dzięki przemyślanemu wymiarowaniu chłodzenie adsorpcyjne osiąga wartości porównywalne z free coolingiem

Zasada działania chłodzenia adsorpcyjnego opiera się na chłodzeniu ewaporacyjnym. Specjalna substancja wiążąca wodę, tak zwany adsorbent, zasysa parę wodną z wymiennika ciepła. Woda wyparowuje, wydobywając ciepło i tworząc efekt chłodu. Adsorbent jest regenerowany przez dostarczanie ciepła, co podtrzymuje proces chłodzenia.

Szczególnym wyzwaniem dla SuperMUC-NG jest obsługa adsorpcji przy relatywnie niskich temperaturach ciepła odpadowego procesorów. W tym celu Fahrenheit opracował na zamówienie specjalne adsorbenty do takich zastosowań. W ich skład wchodzą m.in. kryształy zeolitu, grupy substancji, która jest bardzo dobrze dostosowana do adsorpcji. Fahrenheit, w zastrzeżonym procesie, nakłada warstwę zeolitu na wymienniki ciepła w celu maksymalizacji wydajności całego systemu.

Nowy system HPC zapewni wydajność nie tylko pod względem energetycznym, ale także pod względem możliwości dostosowania go do bardzo różnych zadań naukowych. Dlatego poszczególne węzły różnią się między sobą. Chociaż wszystkie węzły są wyposażone w dwa gniazda dla 24-rdzeniowego procesora Xeon, mają różną konfigurację pamięci RAM. 6,4 tys. serwerów Lenovo ThinkSystem SD 650 DWC ma 96 GB i jest wykorzystywane jako tzw. "chude" węzły. Ponadto działają także 144 węzły "grube". Każdy z nich posiada 768 GB pamięci. Porównajmy to z komputerem stacjonarnym: w przypadku "grubych" węzłów, daje to 16 GB na rdzeń, czyli znacznie więcej niż większość dzisiejszych komputerów biurowych. W NG istnieje również komponent chmurowy, który stanowi niezależny klaster. Składa się on z 64 węzłów, z których połowa jest wyposażona w dwa procesory graficzne Volta-100 firmy Nvidia.

Rysunek 2: Przepływ wody przez system CPU

Szybki system pamięci masowej

Tak duża moc obliczeniowa wymaga szybkiej sieci i szybkiej pamięci masowej. Architektura Intel Omnipath Fabric o przepustowości 100 GBit/s, która jest bezpośrednio podłączona do procesora w nowych Xeonach, zapewnia bardzo dużą szybkość pamięci masowej. Jednocześnie gwarantuje małe opóźnienia i mniejsze zużycie energii. Dotyczy to również sieci, ponieważ można pominąć dodatkowe moduły nadajnika-odbiornika. Rozwiązanie to jest również ekonomiczne, ponieważ można zastosować konwencjonalne światłowody ze złączami QSFP28. Podobnie jak w przypadku węzłów, są różne konfiguracje pamięci masowej: 50 petabajtów do typowych zadań, dodatkowe 20 petabajtów jest dostępnych do długoterminowego przechowywania z wysoką niezawodnością. Drugi system jest przeznaczony przede wszystkim do prowadzenia analiz dużych zbiorów danych. GPFS, znany również jako IBM Spectrum Scale, jest używany jako równoległy system plików.

Perspektywy: nowa lista

Wszyscy jesteśmy ciekawi, jak bardzo SuperMUC-NG może namieszać na liście Top500. Kolejna edycja listy uwzględniająca ten komputer zostanie opublikowane w listopadzie 2018 roku.

Redaktor: Dr. Jörg Schröper, redaktor naczelny LanLine

Współautor: Paul Hoecherl, Product Manager Group Data Center, Niemcy, Austria i Szwajcaria