VISC – nowa koncepcja wirtualnej maszyny

-

- Janusz Chustecki,

- 03.11.2014, godz. 09:00

Soft Machines (firma produkująca układy scalone) zmierzyła się z problemem wirtualnej maszyny i opracowała architekturę, która w jej opinii zapoczątkuje nową erę w dziedzinie przetwarzania danych. Głównie dzięki temu, że systemy oparte na tej architekturze mają wysoką wydajność, a ich moc obliczeniową można elastycznie skalować.

Soft Machines jest twórcą architektury noszącej nazwę Virtual Instruction Set Computing (VISC). Firma zapowiada, że będzie oferować dostawcom komputerów układy scalone oparte na tej architekturze oraz sprzedać licencje na ich stosowanie.

Analitycy twierdzą, że architektura VISC ma szansę odnieść sukces pod warunkiem, że zaczną ją wspierać liczący się na świecie producenci procesorów, tacy, jak AMD, ARM, Intel czy Qualcomm. W przeciwnym przypadku będzie jej trudno przebić się na rynku. Mogą się nią też zainteresować producenci urządzeń mobilnych, pod warunkiem jednak, że zostanie ona wzbogacona o rozwiązania wspierające sieci radiowe.

Zobacz również:

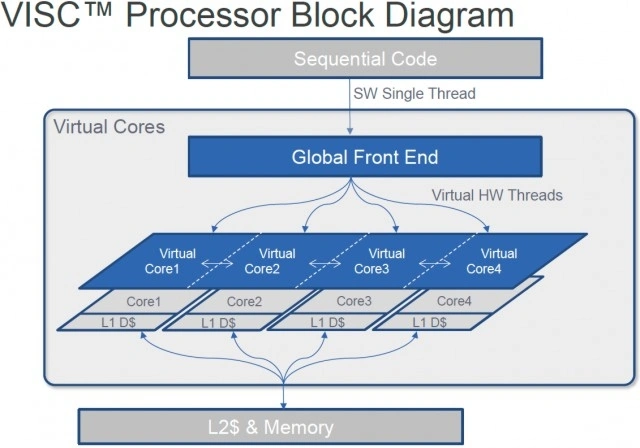

Wszyscy wiedzą, jak wyglądają wirtualne maszyny konfigurowane na fizycznym serwerze. Tworzą one oddzielne, wirtualne komputery, każdy dysponujący swoim własnym systemem operacyjnym i przypisanym mu przez administratora zasobom sprzętowym wchodzącym w skład danego fizycznego komputera. Architektura VISC oferuje takie same możliwości, z tą jednak istotną różnicą, iż może postawić do dyspozycji wirtualnej maszyny więcej niż jeden dedykowany jej rdzeń CPU i następnie wykorzystać je do wykonywania jednego zadania.

To koncepcja oferująca odmienną logikę postępowania niż ta stosowana przy tradycyjnym programowaniu, a więc takim gdy mamy do czynienia z jednym procesorem (względnie rdzeniem), któremu program przesyła do wykonania ciąg instrukcji, które są wykonywane w określonej kolejności, jedna po drugiej. Po wprowadzeniu do komputerów procesorów wyposażonych w kilka rdzeni, program mógł wysyłać do układu kilka instrukcji jednocześnie zakładając iż będą one wykonywane równolegle i zlecone poszczególnym rdzeniom zadania zostaną wykonane mniej więcej w tym samym czasie. Z czasem techniki programowania i kompilatory zostały udoskonalone, tak aby mogły efektywniej wykorzystywać wszystkie rdzenie wchodzące w skład układu CPU (obciążając je np. w miarę równomiernie zadaniami). Jednak niezoptymalizowany kod ma i tak wtedy tendencję do tego, aby korzystać z usług jednego rdzenia.