Cyfrowe słońce binarne chmury

-

- Jakub Chabik,

- 25.03.2002

W czasach PRL-u mówiono, że informacje w dzienniku telewizyjnym dzielą się na prawdziwe, wątpliwe i nieprawdziwe. Do tych pierwszych zaliczano nekrologi, do ostatnich - całą resztę z wyjątkiem prognozy pogody, którą zaliczano do informacji wątpliwych. Od tego czasu zmieniły się dwie rzeczy: telewizyjne dzienniki stały się bardziej wiarygodne, a ponadto wzrosła sprawdzalność prognozy pogody. Wielkie zasługi położyły tu metody numerycznego modelowania klimatu.

W czasach PRL-u mówiono, że informacje w dzienniku telewizyjnym dzielą się na prawdziwe, wątpliwe i nieprawdziwe. Do tych pierwszych zaliczano nekrologi, do ostatnich - całą resztę z wyjątkiem prognozy pogody, którą zaliczano do informacji wątpliwych. Od tego czasu zmieniły się dwie rzeczy: telewizyjne dzienniki stały się bardziej wiarygodne, a ponadto wzrosła sprawdzalność prognozy pogody. Wielkie zasługi położyły tu metody numerycznego modelowania klimatu.

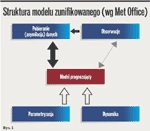

Struktura modelu zunifikowanego

Zastosowanie matematyki w tej fazie rozwoju prognoz pogody to przede wszystkim statystyczne metody obróbki danych historycznych i wyprowa-dzania pewnych prawidłowości ilościowych z tych danych (np. metodą regresji liniowej). Aby przewidzieć pogodę w kolejnym okresie, synoptyk dokonywał mniej lub bardziej intuicyjnej ekstrapolacji na podstawie sytuacji aktualnej, trendów długofalowych oraz swojej wiedzy na temat typowych zachowań klimatu.

Można powiedzieć, że prognozowanie w erze przedkomputerowej polegało w znacznej mierze na doświadczeniu osoby przepowiadającej pogodę i było mało precyzyjne. Wicherek był być może bardziej wiarygodny niż dziennikarze dziennika telewizyjnego, ale dziś wystawilibyśmy mu najwyżej trójkę z plusem. Do rangi symbolu tej epoki urasta baca z Zakopanego, który potrafił często trafniej prognozować niż meteorolodzy Instytutu Meteorologii i Gospodarki Wodnej.

Numeryczne modelowanie klimatu

W tym czasie w laboratoriach powstawały podwaliny numerycznego modelowania klimatu. Matematycy, fizycy i klimatolodzy wyszli z jednego, prostego założenia: zachowanie obiektów makroskopowych, takich jak chmury i wielkie masy powietrza, jest konsekwencją sił działających na obiekty mikroskopowe, czyli pojedyncze cząsteczki gazów czy wody. W dużym uproszczeniu można powiedzieć, że zachowanie się chmury (czyli zbiorowiska cząstek wody) jest sumą (dokładniej: całką) zachowań każdej cząsteczki z osobna. Jeżeli więc potrafimy zamknąć w równaniach zachowania drobin powietrza, pyłu i wody, to rozwiązania równań różniczkowych dadzą nam odpowiedź na to, jak zachowują się tornada, fronty atmosferyczne i burze śnieżne.

Naukowcy zastosowali więc kilka podstawowych praw fizycznych do odzwierciedlenia zachowania obiek- tów mikroskopowych. Te prawa to np. zasada zachowania energii, prawo powszechnego ciążenia, zasada zacho- wania pędu, równania stanu gazu dos- konałego, druga zasada dynamiki, pierwsza zasada termodynamiki i równania hydrostatyki.

Postępując w ten sposób, do grona naukowców musi czym prędzej dołączyć informatyk wyposażony w komputer, bo pojawia się problem złożoności i skali. Złożoności, gdyż rozwiązywanie równań różniczkowych to sprawa, oględnie mówiąc, niebanalna. Konieczne jest więc przybliżone wyznaczanie rozwiązań za pomocą metod numerycznych. Problem skali to oczywiście konieczność zbierania setek tysięcy danych pomiarowych (tzw. warunków brzegowych), przekazywania ich do ośrodków obliczeniowych, gdzie następnie zostaną podstawione do wspomnianych równań. Do tych wszystkich zadań zaprzęgnięto komputery.

Mówiąc dokładniej, superkomputery. Modelowanie klimatu ma bowiem pewną feralną cechę, która różni je od modelowania innych złożonych zjawisk, np. przepływu powietrza wokół nowego modelu nart dla skoczka narciarskiego. Prognoza pogody ma konkretny horyzont czasowy i obliczanie jej nie może trwać dłużej niż ten horyzont. Informacja o temperaturze "przewidzianej" na trzy dni temu nie ma żadnej wartości z praktycznego punktu widzenia. Dlatego czas trwania obliczeń musi być istotnie krótszy niż moment postawienia prognozy, inaczej bowiem cała zabawa służy tylko teoretykom do sprawdzania poprawności modeli, nie zaś ludziom do decyzji, czy idąc na spacer powinni wziąć parasol.