Kompresja informacji w sieciach

-

- Adam Urbanek,

- 01.02.2004

Kompresja pozwala nawet dziesięciokrotnie zwiększyć przepływność istniejącej sieci telekomunikacyjnej, jednak pod warunkiem zastosowania metody o odpowiedniej skuteczności i z niewielkim opóźnieniem w procesie translacji.

Kompresja pozwala nawet dziesięciokrotnie zwiększyć przepływność istniejącej sieci telekomunikacyjnej, jednak pod warunkiem zastosowania metody o odpowiedniej skuteczności i z niewielkim opóźnieniem w procesie translacji.

Gdy zapotrzebowanie aplikacji na szerokość pasma rośnie szybciej niż przepływność w sieciach WAN, coraz ważniejsze jest dla operatorów udostępnianie większych przepływności w istniejącej infrastrukturze sieciowej. Zagęszczanie informacji jest metodą podwyższania przepływności użytkowej w sieciach teleinformatycznych (i oczywiście jednym ze sposobów zwiększenia pojemności systemów serwerowych, bazodanowych, archiwizacyjnych itp.).

Rodzaje kompresji

W pojęciu ogólnym kompresja informacji źródłowej może być stratna lub bezstratna. Bezstratna kompresja informacji redukuje objętość przesyłanego zbioru informacji w taki sposób, aby jej treść nie uległa żadnej zmianie po operacji dekompresji. Jej przeciwieństwem są algorytmy kompresji stratnej, które w wyniku przetworzenia informacji (kompresji i dekompresji) nie dają identycznego zbioru danych po stronie odbiorczej.

Skuteczność kompresji danych (aplikacje)

Większość algorytmów dotyczących kompresji obrazu, dźwięku i głosu ma z natury charakter kompresji stratnej. Nie jest to wcale przeszkodą w rejestracji i odbiorze tak zmienionych sygnałów, gdyż czułość ludzkiego ucha i oka ma ograniczoną rozdzielczość, niewielkie straty w odbieranej informacji pozostają więc niezauważalne przez zmysły człowieka. Eliminowanie niedostrzegalnych dla oka i ucha elementów powoduje jednak, że sumaryczna wielkość przesyłanej informacji jest mniejsza, pasmo potrzebne do jej przesłania - węższe, a kanał transmisyjny potrzebny do jej przesłania jest wykorzystany bardziej efektywnie.

W komunikacji multimedialnej (głos z danymi) przez sieci transportowe zwykle brak rozróżnienia, które elementy można przesyłać ze stratami, a które bez strat, co praktycznie oznacza, że podstawowym sposobem kompresji w sieciach pozostaje wyłącznie bezstratna kompresja informacji. Bezstratne technologie kompresji dzielą się obecnie na dwie kategorie, różniące się sposobem tworzenia tablic kompresji wg algorytmów kompresji statystycznej lub podstawieniowej.

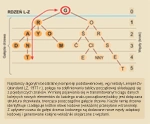

Proces kodowania metodą Huffmana (dla 6 znaków o różnym prawdopodobieństwie)

Najbardziej popularna do tej pory kompresja statystyczna oblicza w początkowej fazie kompresji (lub korzysta z gotowych szablonów wzorcowych) częstość występowania poszczególnych symboli znaków w zbiorze wejściowym, a następnie przypisuje im odpowiednio krótsze kody kompresji - ważne dla całego zbioru podlegającego kompresji. Liczba bitów konwersji przypisana poszczególnym komprymowanym znakom jest określana matematycznie na zasadzie prawdopodobieństwa ich występowania. Skuteczność tego rodzaju kompresji jest tym większa, im częściej w procesie kompresji pojawiają się znaki o przypisanych im krótszych kodach, niż miały one w oryginalnej postaci źródłowej.

Współcześnie funkcjonują dwie odmiany kompresji statystycznej: kompresja realizowana wg algorytmów statycznych lub dynamicznych (czyli adaptacyjnych). W statycznej kompresji, takiej jak kompresja Huffmana, mamy do dyspozycji zdefiniowaną jedną tablicę dla całego pliku lub obiektu podlegającego kompresji. Nie zmienia się ona podczas procesu kompresji kompletnego zbioru danych.

Algorytmy kompresji bezstratnej

Patrząc od strony szybkości przetwarzania, nie jest to jednak najbardziej optymalny sposób kompresji, gdyż czas potrzebny do przeliczania tablic algorytmów kodowania kontekstowego rośnie wykładniczo wraz z liczbą kontekstów. Wada ta pomniejsza korzyści wynikające ze skuteczności kompresji i powoduje, że ta kompresja nie jest stosowana praktycznie w aplikacjach czasu rzeczywistego. Potwierdza się w ten sposób ogólna zasada, że im bardziej skuteczna kompresja informacji, tym więcej wymaga czasu, aby uzyskać mniejszą zajętość kanału transmisyjnego.

Drzewiasta struktura algorytmu Lempel-Ziv

Zamiast obliczania prawdopodobieństwa występowania pojedynczego znaku w zbiorze (wymagającego odpowiednio długiego czasu przetwarzania), algorytm podstawieniowy zastępuje zidentyfikowane długie sekwencje prostym odnośnikiem wskazującym konkretny szablon w tablicy kompresji.

Ponieważ detekcja szablonów jest szybsza niż kontekstowe obliczanie prawdopodobieństwa w algorytmach dynamicznej kompresji, algorytmy te są współcześnie stosowane do kompresji pasma w sieciach z aplikacjami czasu rzeczywistego.

Większość współczesnych metod kompresji bezstratnej w sieci używa algorytmów podstawieniowych, które przy niewielkiej mocy przetwarzania dają zadowalający współczynnik kompresji. Mimo ciągłego ulepszania, tradycyjne rozwiązania kompresji podstawieniowej mają znaczące ograniczenia i nie mogą sprostać rosnącym wymaganiom aplikacji we współczesnym środowisku sieciowym.

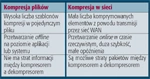

Cechy kompresji

Cechy tradycyjnej kompresji plików i kompresji sieciowej

Ponadto, w wyniku fragmentacji informacji w sieciach pakietowych WAN, pakiety są zwykle transmitowane w trybie bezpołączeniowym - w otoczeniu innych pakietów pochodzących od wielu użytkowników. Powoduje to dalszy wzrost dystansu między powtarzającymi się elementami w pliku oraz istotnie komplikuje algorytm przeszukiwania powtarzających się wzorców kompresji konkretnego zbioru. Dodatkową trudność stanowi wzrost szybkości łącza WAN (więcej nowych aplikacji i większa liczba innych użytkowników). W wyniku takiego agregowania informacji z wielu źródeł jeszcze bardziej wzrasta dystans między poszukiwanymi wzorcami zbioru, istotnie pogarszając proces kompresji.