Hadoop World 2014

-

- Janusz Chustecki,

- 20.10.2014

Prezentacje najnowszych wersji środowiska Hadoop, aplikacji Big Data oraz narzędzi do wirtualizacji danych to najważniejsze tematy październikowej konferencji Strata + Hadoop World 2014 w Nowym Jorku.

Głównym tematem trzydniowej konferencji Strata + Hadoop World 2014 była oczywiście otwarta platforma obliczeniowa Hadoop oraz aplikacje Big Data. Uczestnicy konferencji przedstawili dokonania w tej dziedzinie, prezentując najnowsze wersje aplikacji pozwalających analizować olbrzymie porcje danych - zarówno strukturalnych, niestrukturalnych, jak i mających postać pół-strukturalną.

Konferencję otworzył Mike Olson, szef firmy Cloudera, który powiedział coś, co wszystkich zaskoczyło. A zdanie to brzmiało, ”myślę, że jeszcze w tym roku Hadoop zniknie”. Deklaracja ta zabrzmiała tajemniczo i można powiedzieć, że wyglądała na prowokację. Mike Olson w następnych zdaniach wytłumaczył, co miał na myśli mówiąc w ten sposób. Nie chodziło mu o samą technologię, bo ta absolutne nie zniknie, ale o to, że środowisko będzie ewoluować i przyjmie już w ciągu następnych kilku miesięcy postać niewidocznej dla użytkownika infrastruktury, w ramach której firmy będą uruchamiać aplikacje Big Data.

Zobacz również:

Brzmi to cokolwiek skomplikowanie, ale Mike Olson posłużył się takim przykładem. Dzisiaj firmy nie myślą o tym, skąd pochodzą dane. Mogą one być pobierane z hurtowni danych Teradata lub z baz danych Oracle. Najważniejsze, że są, a to iż są przechowywane w repozytoriach Oracle czy Teradata jest sprawą drugorzędną. Tak samo stanie się z platformą Hadoop. Będzie to uniwersalny sposób przetwarzania dużych porcji danych, a fakt że stoi za tym Hadoop, zejdzie na drugi plan.

Pierwsza konferencja Hadoop World odbyła się w 2009 roku i brało w niej udział 400 osób. Od 2012 roku konferencja nosi nazwę Strata + Hadoop World, a w tym roku, czyli sześć lat później, liczba gości przekroczyła 5 tys. Już ten fakt udowadnia, jak długą drogę przebyła technologia. Dzisiaj zna ją właściwie każdy informatyk i wizerunek żółtego słonia już nikogo nie dziwi. A słoń, mający ten dziwny kolor, prze do przodu. Jak podaje Gartner, 73% firm albo już posiada aplikacje Hadoop, albo zamierza przejść na tę platformę w najbliższym czasie. A oznacza to, że na naszych oczach rodzi się sektor IT, na którym już wkrótce obroty przekroczą jeden bilion USD.

Wielu prelegentów namawiało gości, aby bacznie się przyglądali poczynaniom firmy Google. W ich opinii to właśnie Google wyznacza obecnie kierunku rozwoju wielu technologii IT, w tym tych, które pozwalają przetwarzać duże porcje danych. Kto jak kto, ale Google jest obecnie jedną z tych firm, która gromadzi tak wiele danych, jak mało kto na świecie.

A ilość danych, które gromadzą obecnie firmy, rośnie w lawinowy sposób. Na konferencji wymieniano firmy, które potrafią w ciągu jednego dnia zapisać na swoich systemach pamięci masowych 4 TB danych zawierających informacje o swoich klientach. I tak dzień po dniu, co oznacza, że po miesiącu przybywa 120 TB nowych danych. Inne firmy, takie jak Cisco, odbierają olbrzymie porcje danych ze swoich zapór, które są rozmieszczone na wszystkich kontynentach. Jest tego bardzo wiele. Cisco odbiera agreguje w ten sposób w ciągu jednej sekundy ponad milion zdarzeń odnotowanych przez jego zapory sieciowe.

Collaborative Storyboards

Ale gromadzenie danych to tylko pierwszy etap. W kolejnym trzeba w jakiś sposób poddać je analizie. Tu platforma Hadoop ma wiele do powiedzenia. Specjaliści twierdzą, że najlepiej jest wizualizować wyniki takich analiz. Żadne suche liczby nie są w stanie dostarczyć analitykowi tyle informacji, co dobrze opracowany i zaprezentowany wykres. Na konferencji przedstawiono narzędzia takie, jak np. aplikacja Mizzbee używana przez genetyków, które potrafią doskonale wizualizować dane.

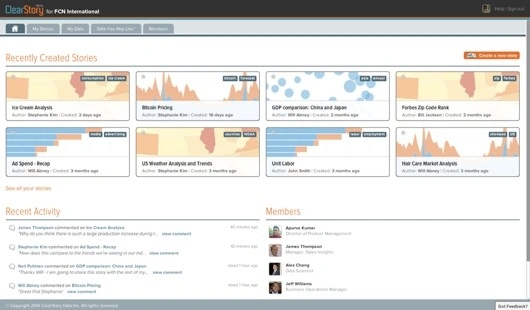

Uczestnicy konferencji mogli się też zapoznać z jednym z najciekawszych narzędzi do wirtualizowania danych, jakie ostatnio stworzono. To rozwiązanie typu „interactive storytelling” noszące nazwę Collaborative Storyboards, opracowane przez firmę ClearStory Data. Bazuje ono na oprogramowaniu Apache Spark, używanym do analizowania i obrazowania danych. Rozwiązanie to może być dobrym symbolem tej konferencji, bowiem żadnemu innemu tematowi nie poświęcono na niej tyle czasu, co wirtualizowaniu danych.

Intel i Hortonworks wspierają Hadoop

Platforma Hadoop dobrze nadaje się do wyszukiwania informacji czy też uruchamiania zaawansowanych aplikacji analitycznych. Warto przypomnieć, że na początku tego roku pojawiła się jej wersja 2.0, a we wrześniu użytkownicy mieli już do dyspozycji wersję 2.5.1 tego rozwiązania.

Hadoop rozwija się ostatnio bardzo dynamicznie i wiele firm przekonuje się powoli, że jest to użyteczne narzędzie, które pozwala zarządzać dużymi zbiorami danych dużo efektywniej, niż jakakolwiek inna platforma tego typu. Wspierają ją nie tylko czołowi dostawcy oprogramowania, ale również producenci sprzętu IT. Przykładem może być Intel, który zainwestował kilka miesięcy w firmę Cloudera, specjalizującą się w projektowaniu oprogramowania open source przetwarzającego duże porcje danych. Powód takiego kroku wydaje się być jasny – Intel chce w ten sposób przekonać użytkowników serwerów opartych na procesorach Xeon, że potrafią one bardzo dobrze obsługiwać aplikacje Big Data.

Jakby tego było mało, Intel oferuje od niedawna użytkownikom własną, firmową dystrybucję platformy Hadoop. Zawiera ona programy analityczne (oferowane oczywiście w postaci otwartego oprogramowania) oraz dodatkowe narzędzia nie należące już niestety do rozwiązań open source. Są to takie programy, jak Intel Manager for Apache Hadoop oraz Active Tuner for Apache Hadoop, które ułatwiają wdrażanie platformy oraz jej strojenie.

Kolejną firmą, która wspiera technologię Hadoop, jest Hortonworks. Oferuje ona użytkownikom, którzy chcieliby przetestować możliwości Hadoop, bezpłatne rozwiązanie Hortonworks Sandbox. Jest to jednowęzłowa implementacja platformy mająca postać wirtualnej maszyny, która zawiera wszystkie typowe elementy środowiska takie, jak Apache HCatalog, Apache Hive i Apache Pig. Budowanie środowiska opartego na Hadoop wymaga normalnie sporo czasu i nie jest prostą sprawą. Oprogramowanie Hortonworks Sandbox znacznie przyspiesza i upraszcza ten proces.

Wirtualna maszyna tworzona jest na bazie oprogramowania CentOS Linux i można ją instalować w jednym z dwóch środowisk: VMware albo Oracle Virtual Box. Oprogramowanie Sandbox Hortonworks jest bezpłatne i można je pobierać z witryny firmy Hortonworks. Producent tego testowego rozwiązania oferuje jednocześnie użytkownikom swój flagowy produkt, jakim jest korporacyjna, płatna już wersja platformy Hadoop. Mowa o oprogramowaniu Hortonworks Data Platform 2.2.