Dyski typu solid-state

-

- NetWorld,

- 01.11.2001

Gigabitowy Ethernet i pojawiające się technologie wielogigabitowe mogą przenosić dane z ogromnymi szybkościami. Jednak często nie można ich wykorzystać, ponieważ wąskim gardłem są urządzenia pamiętające.

Gigabitowy Ethernet i pojawiające się technologie wielogigabitowe mogą przenosić dane z ogromnymi szybkościami. Jednak często nie można ich wykorzystać, ponieważ wąskim gardłem są urządzenia pamiętające.

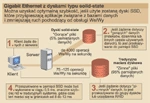

Zazwyczaj żądanie danych pojawia się w serwerze lub w urządzeniu SAN (Storage-Area Network), które z kolei wyszukują dane z pamięci systemowej lub z pamięci podręcznej (cache) sterownika pamięci, a następnie zwracają potrzebne dane z pamięci podręcznej.

Jak to działa

Przeciętnie ponad 50 proc. ruchu związanego z We/Wy wynika z transmisji zaledwie 5 proc. danych systemowych. Przedsiębiorstwa koncentrujące się na przetwarzaniu dużych plików odkrywają, że przeniesienie tych trudno dostępnych, "gorących" plików do pamięci typu SSD (Solid-State Disk) przyspiesza wykonywanie operacji czytaj/pisz do szybkości pamięci RAM. Zwykle "gorące" pliki zawierają pliki temp, log i swap, tudzież tablice i indeksy oraz informacje logon. Zastosowanie pamięci SSD przynosi natychmiastowe skrócenie czasu odpowiedzi terminalu, przyspieszenie zapytań i szybsze wykonywanie zadań wsadowych.

Pamięci SSD likwidują wąskie gardła We/Wy i zapewniają wielokrotnie szybszy dostęp do danych w porównaniu z pamięciami z dyskami wirującymi. Zatory We/Wy, wywoływane przez wielu użytkowników próbujących uzyskać dostęp do danych na twardym dysku, pogarszają wydajność systemu, opóźniają dostęp abonentów do poczty elektronicznej, handlu elektronicznego, wyszukiwania itp.

Pamięci SSD są bardzo szybkimi pamięciami zewnętrznymi o dostępie bezpośrednim, używanymi do przyspieszenia aplikacji operujących na bazach danych. We współczesnych pamięciach z wirującymi dyskami nawet ponad 90 proc. czasu potrzebnego na transfer bloku 4 kB pochłania przesuwanie głowicy i obrót dysku. Pamięci SSD nie mają ruchomych elementów i dlatego mogą odpowiadać znacznie szybciej. Najszybsze pamięci magnetyczne udostępniają dane z prędkością od 8 do 13 ms. Pamięci SSD wykonują te operacje ponad 300 razy szybciej.

W pamięciach magnetycznych liczba operacji WE/Wy przypadająca na sekundę osiąga wartość w granicach 75-125, w pamięci SSD natomiast, w zależności od aplikacji, liczba tych operacji zbliża się do 4000.

Znaczny wpływ na wydajność sieci można uzyskać lokalizując stosunkowo małą część plików w pamięci SSD. Często by uzyskać pożądany wzrost wydajności, wystarczy umieścić w pamięci SSD nie więcej niż 5 proc. plików.

Najczęściej w pamięciach SSD umieszcza się tymczasowe tablice, dzienniki transakcyjne, dzienniki poprawek, indeksy i tablice indeksów. Wielkość tych plików będzie rosła wraz ze wzrostem całej bazy danych.

Specjaliści szacują, że w ciągu kilku najbliższych lat rozmiary plików baz danych będą rosnąć o 100 proc. rocznie. Przewidują również, że w wielu przypadkach pliki te będą lokowane w pamięciach SSD. Polepszenie wydajności systemu o 200-400 proc. można osiągnąć dodając pamięci SSD do macierzy RAID.

Prowadzone obecnie prace rozwojowe w dziedzinie technologii pamięci SSD i inteligentnych pamięci podręcznych ICD (Intelligent Cache Device) rokują znaczną poprawę wydajności. Niektóre amerykańskie przedsiębiorstwa telekomunikacyjne, Internet, banki i instytucje finansowe - wykorzystujące systemy baz danych Oracle, Sybase i Informix - już używają tej nowej technologii. Do aplikacji, przy których korzyści są największe, należą relacyjne bazy danych, handel elektroniczny, poczta elektroniczna, serwery uwierzytelniające, systemy rozliczeniowe, wspieranie podejmowania decyzji i wykrywanie oszustw.

Chociaż można użyć w pamięci systemowej lub podręcznej sterownika napędu dyskowego do zapewnienia szybkiego dostępu do danych, oba te rozwiązania w porównaniu z pamięcią SSD mają znaczne ograniczenia. Pamięć systemowa, pracując w cyklach jednostki centralnej CPU, obciążając CPU procedurami przeglądania, może negatywnie wpływać na wydajność serwera. Pamięć SSD można skonfigurować jako urządzenie wieloportowe i zgrupowane, dzięki temu jedna pamięć SSD może obsługiwać wiele serwerów, potencjalnie uwalniając wiele jednostek CPU od funkcji przeszukiwania.

Sterowniki napędów ze zintegrowanymi pamięciami podręcznymi zaskakują wieloma problemami. Jeśli sterownik dysku zapisuje dane wykorzystując pamięć podręczną, to może się zdarzyć, że straci się je, zanim zostaną zapisane na twardym dysku. Dane zapisywane w SSD są zapamiętywane natychmiast, zmniejszając ryzyko ich straty. Co więcej, pamięci SSD są odpowiedniejsze od pamięci podręcznych sterowników w obsłudze aplikacji związanych z przetwarzaniem danych, takich jak te, które obsługują dzienniki bieżących transakcji, ponieważ dane są zapisywane natychmiast w SSD.

Przy przechodzeniu na technologię gigabitowego i wielogigabitowego Ethernetu konieczność zmniejszenia potencjalnych wąskich gardeł, wpływających negatywnie na wydajność sieci, staje się priorytetem dla chcących osiągnąć szybkości przeprowadzania transakcji udostępniane przez nowe standardy. Użycie pamięci SSD, która utrzymuje "gorące" pliki i inteligentną pamięć podręczną, będzie znaczącym krokiem w kierunku minimalizacji zatorów w sieciach, wynikających z obsługi operacji na dużych zbiorach.