Polski rynek jeszcze poczeka na szersze zastosowanie Big Data

-

- 20.11.2015, godz. 14:36

Rozwiązania do analizy wielkich zbiorów danych stosuje w niektórych obszarach biznesu już 97% firm na świecie, w Europie 25%, w Polsce 18%. Przyczyny niskiego wykorzystania u nas tych rozwiązań są złożone: od braku strategii i celu ich wykorzystania, po niedobór specjalistów i stosunkowo niewielkie wolumeny danych do analizowania.

Ilość danych rośne w zawrotnym tempie. Według IBM 90% danych na świecie zostało zgromadzonych w ciągu ostatnich 2 lat, a do 2020 roku ich ilość zwiększyć się może jeszcze 50 razy. Różnorodność danych, wśród których wiele jest danymi nieustruktryzowanymi powoduje, że ich analiza jest już nie tylko trudna, co niemożliwa bez specjalistycznych, narzędzi znanych jako Business Analytics, czy też Data Analytics. Zapotrzebowania na zaawansowana analitykę powoduje duży wzrost rynku w tym obszarze - globalny rynek analizy wielkich zbiorów danych rozwija się obecnie sześć razy szybciej niż cały sektor IT.

Światowy rynek rozwiązań Business Analytics według IDC wzrośnie w 2018 roku do 59,2 mld USD (w 2013 było to 37,7 mld USD), a roczne tempo wzrostu będzie się przez ten czas utrzymywać na poziomie 9,4%. Główni gracze na globalnym rynku to m. in: IBM, HP, Oracle, Birst, Kognitio, Adaptive Planning, BIME, Cloud9 Analytics, GoodData, Google, Host Analytics, Microsoft i inni. W obszarze Big Data firma badawcza Gartner wskazuje obecnie 700 podmiotów, które oferują rozwiązania mogące sprostać najbardziej obciążonym danymi środowiskom.

Zobacz również:

- IDC CIO Summit – potencjał drzemiący w algorytmach

- Przychody na rynku chipów wzrosną w tym roku do ponad 600 mld

- AI sercem pecetów

Szerszą możliwość korzystania z rozwiązań BA/D&A stwarza ich dostępność w chmurze. Według MarketsandMarkets rynek Cloud Analytics, który w 2013 roku był wart 5,25 mld do 2018 roku powiększy się do16,52 mld USD.

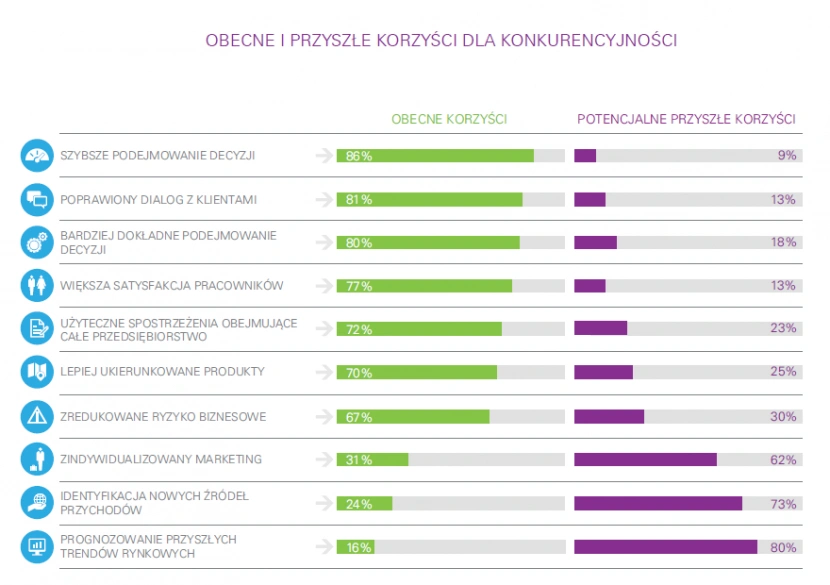

Firma consultingowa KPMG twierdzi, że już 97 % firm wykorzystuje rozwiązania D&A (Data Analytics) w niektórych obszarach biznesu. Aż 86% z ich uważa, że dzięki temu podejmuje szybsze decyzje biznesowe, a 67% redukuje ryzyko biznesowe. Jednak krajobraz nie wygląda do końca różowo, bo tylko 19% organizacji jest usatysfakcjonowanych z wiedzy której dostarczają im narzędzia D&A. I chociaż 81% poprawiło swoje zrozumienie klientów, to tylko 41% z nich stworzyło dla nich bardziej dopasowane oferty. Dlaczego tak się dzieje? Problemem jest brak kompetencji. Tylko 14% uważa, że posiada wszystkie potrzebne talenty i zdolności potrzebne do pełnego wykorzystania D&A. Wygląda na to, że specjaliści w dziedzinie analizy danych (data scientists) będą w najbliższym czasie jednymi z najbardziej poszukiwanych zawodów na rynku pracy.

Dane - cyfrowa waluta firm

Dane są dziś nie tylko zasobem przedsiębiorstwa, lecz jego cyfrowym kapitałem, który można spieniężyć i dzięki któremu można zoptymalizować procesy biznesowe wewnątrz organizacji. Deloitte wymienia monetyzację danych jako jeden z najważniejszych trendów rozwijanych w biznesie w najbliższych latach. Jak twierdzi Boston Consulting Group w raporcie „The Value of Our Digital Identity” wartość anonimowych informacji (Big Data) zgromadzonych o internautach z samej Unii Europejskiej w 2020 roku zbliży się do biliona euro.

Zgromadzone przez przedsiębiorstwa duże zasoby danych zaczynają być postrzegane jako źródło przewagi konkurencyjnej oraz możliwość precyzyjnego dostosowania oferty do potrzeb klientów. Owocuje to zwiększeniem budżetów na rozwiązania z zakresu Data Analytics. Obecnie już 30% firm przeznacza na nie 50% swoich budżetów technologicznych.

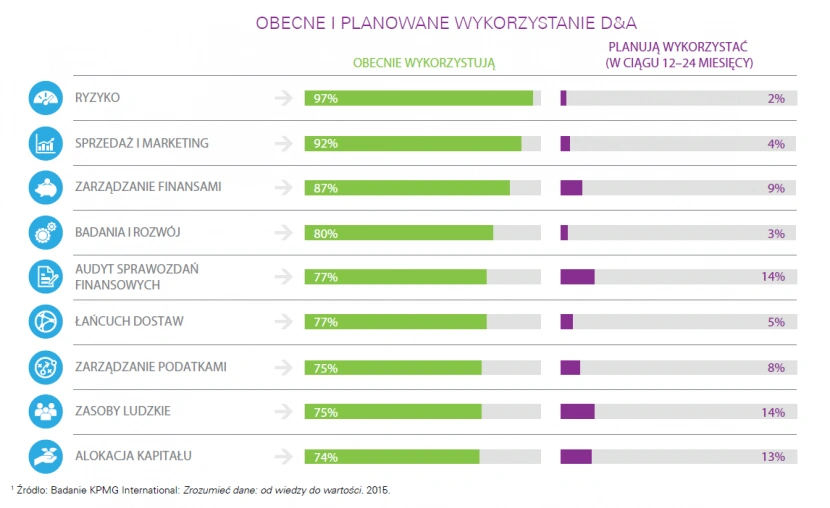

Według KPMG firmy wykorzystują D&A w niemal wszystkich obszarach swojej działalności: w zarządzaniu ryzykiem (97%), sprzedaży i marketingu (92%), zarządzaniu finansowym (87%), działalności badawczo rozwojowej (80%), audycie sprawozdań finansowych (77%), łańcuchu dostaw (77%), zarządzaniu podatkami (75%), zarządzaniu zasobami ludzkimi (75%) czy alokacji kapitału (74%). Aż 82% respondentów wskazało, że zaawansowane analizy danych pozwalają lepiej zrozumieć potrzeby i preferencje klientów. Prawie siedemdziesiąt procent przedsiębiorstw przebadanych przez Accenture i General Electric wierzy w to, że analiza Big Data w ciągu 3 lat całkowicie zmieni i przedefiniuje krajobraz ich branży a firmy, które nie wdrożą w tym czasie strategii Big Data stracą udziały w rynku.

Fenomen analizy Big Data polega na możliwości wykorzystania zaawansowanych, niezwykle wydajnych obliczeń w celu przekucie ich w realne korzyści dla firm i zwykłych ludzi. Podczas „Key Trends and Technologies in Advanced Analytics at the Gartner Business Intelligence & Analytics Summit" w Monachium w październiku 2014 analitycy Gartnera przytoczyli jako jeden z przykładów banalną z pozoru historię napoju produkowanego przez Coca Colę. Chodzi o recepturę soku pomarańczowego Minute Maid. Okazuje się, że Coca-Cola używa zaawansowanej analizy różnorodnych danych by utrzymać jego jednolitą konsystencję i smak. Używając obrazów satelitarnych, analizując warunki pogodowe, oczekiwane plony i różnice w smaku owoców, jak kwaśność czy słodycz, Coca-Cola jest w stanie dostosować swoją recepturę do obowiązującego standardu w ciągu 5 – 10 minut

Polska analizuje mało

Zgodnie z badaniem Intela 25% firm w Europie Środkowej analizuje dane i korzysta z rozwiązań Big Data. W Polsce wykorzystuje je tylko 18% firm co stanowi najniższy wynik w regionie. Jeśli jednak wierzyć zapewnieniom przedsiębiorców z polskiego rynku mamy szansę poprawić ten wynik już w kolejnym roku, ponieważ 6,7% ankietowanych firm planuje implementację rozwiązań z zakresu analityki Big Data, bądź już je wdraża.

Skąd obecnie tak niski stopień penetracji technologii Big Data na polskim rynku? Powodów jest sporo. Zacznijmy od tego, że nie tak znów wiele polskich firm ma odpowiednio duże zbiory danych, co nie jest niczym wyjątkowym, gdyż jak szacuje Oracle 90% ich klientów na całym świecie ma bazy danych poniżej 900GB – nie jest to więc Big Data i nie ma wówczas potrzeby przetwarzania danych inaczej niż robiono to dotychczas. W Polsce wsród pionierów w zakresie wykorzystania danych jest np. Grupa Allegro, która posiada jedne z największych zbiorów danych w kraju, tego typu serwisów nie ma u nas wiele. Ale wielkość zbiorów danych nie do końca hamuje rozwój rynku rozwiązań analitycznych. Jeśli dokładnie określony jest cel analizy, także z mniejszych wolumenów można wyciągnąć konkretną wartość.

-Hamulcowym Big Data jest u nas błędne przekonanie rodzimych firm, że analityka danych jest rozwiązaniem zarezerwowanym dla dużych graczy. Tymczasem to plastyczna technologia, z której z powodzeniem mogą korzystać firmy mniejsze. Druga obawa wiąże się z mitem, że chcąc pokusić się o Big Data należy dysponować niebotycznym budżetem. Nie istnieje coś takiego jak odgórny „cennik Big Data”. Trzecia obawa – to niepewność: czy inwestycja się zwróci? Jaki będzie współczynnik ROI? W „The Industrial Insights Report for 2015” czytamy, że 3 na 4 firmy (75%) przyznają, że odnotowały wzrost przychodów, właśnie dzięki wykorzystaniu analityki danych - mówi Piotr Prajsnar , CEO w Cloud Technologies. Kolejną bolączką jest niedobór odpowiednich ludzi oraz wykształconych odpowiednich procesów biznesowych. -Te dwa czynniki wpływają negatywnie na zaufanie i przekonanie do analiz typu Big Data w dużych organizacjach komercyjnych- dodaje Grzegorz Chmielowski, Big Data Practice Manager w Teradata Polska.

Według firmy PiLab specjalizującej się w przetwarzaniu i modelowaniu danych w wielu firmach zapomina się, że najpierw należy zdefiniować cel, a dopiero potem wybrać rozwiązanie wspierające ten cel. Najważniejsza jest wiedza o tym po co dane te są gromadzone i pod jakim kątem mogą być analizowane, bez tej wiedzy wdrażanie zaawansowanej analityki jest problematyczne i nieefektywne.- Wielokrotnie słyszeliśmy od różnych działów IT, że istnieją pewne naciski na wykorzystanie narzędzi Big Data do celów, w których nie do końca się sprawdzą, tylko dlatego, że akcjonariusze/zarząd chcą słyszeć, że firma ma zaimplementowane rozwiązania Big Data.

Jeszcze parę lat temu w środowisku panowało przekonanie, że wszystkie dane wrzucimy do jednego dużego kontenera ( klastra), a następnie będziemy to analizować. Problem w tym, że jeżeli zeskładujemy dane nie myśląc o tym, w jaki sposób wykorzystywać je w przyszłości i nie strukturyzując ich, to koszt analiz bardzo wzrośnie – w drastycznych przypadkach przekraczając opłacalność projektu. Dlatego coraz większe znaczenie zyskuje na świecie określenie Data Reservoir.- mówi Krystian Piećko, Chief Technology Officer (CTO) w PiLab. Termin ten oznacza inne podejście do projektów Big Data – poprzedzone przygotowaniem struktur danych i modeli, zakończone etapem zasilania danymi.

Wykorzystanie Big Data w organizacji, co jeszcze raz warto podkreślić, musi mieć jasny cel i wizję zastosowania. Gdy w przedsiębiorstwie pojawi się konkretny problem i okaże się, że jego rozwiązanie jest możliwe dzięki analizie Big Data, wówczas implementacja takiego rozwiązania będzie jak najbardziej konieczna i uzasadniona.

Polskie firmy dopiero testują Big Data

Paweł Kranzberg- menedżer w dziale usług doradczych dla sektora usług finansowych w KPMG w Polsce.

Zastosowanie Big Data w firmie wymaga integracji wielu źródeł danych i umiejętności wykorzystania wyników analiz w różnych miejscach organizacji. Przeszkodami w implementacji takich rozwiązań będą m.in. rozproszone architektury danych z niskim poziomem integracji systemów oraz brak odpowiednich kompetencji analiz w zakresie Big Data. Dodatkowo możemy zauważyć niski poziom kooperacji pomiędzy podmiotami, które powinny kreować platformy wymiany danych, będące elementem rozwoju Big Data. Inną przeszkodą mającą pośredni, lecz zauważalny wpływ jest brak sprawnych procesów zarządzania strategicznego, które są konieczne do skutecznego wypracowania i rozwoju strategii firmy – Big Data może mieć znaczący długofalowy wpływ na modele biznesowe firm i zmianę czynników konkurencyjności poszczególnych branż. Wydaje się, że świadomość polskich firm w temacie Big Data stopniowo rośnie i coraz bardziej inwestują one w budowanie kompetencji i testowanie nowych rozwiązań. Nie należy się jednak spodziewać, że rok 2016 będzie rokiem przełomu.

Dużą przeszkodą jest brak wypracowanych business cases, co sprawia, że każde wdrożenie rozwiązań Big Data jest w pewnym stopniu innowacyjne. Polska gospodarka, zajmująca niskie lokaty w rankingach innowacyjności może mieć problem z dogonieniem światowej czołówki.

Kto wykorzystuje, kto wdraża narzędzia do analizy Big Data

Firmy wykorzystujące analizę Big Data

Czechy - 33,1%

Słowacja - 30,7%

Węgry - 19,3%

Polska - 18%

Firmy planujące wdrożenie analizy Big Data przed końcem 2015 roku

Czechy - 8,6%

Słowacja - 8,9%

Węgry - 3,3%

Polska - 6,7%

źródło: Intel

Co w pierwszej kolejności blokuje wdrożenia Big Data

- Przyszłe inwestycje w Big Data w ciągu 3 lat - 12%

- Koszty analizy danych - 11%

- Czas jaki zabiera analiza - 10%

- Wysoki koszt przechowywania danych - 11%

- Niedobór specjalistów -12%

źródło: Capgemini: Big & Fast Data: The Rise of Insight-Driven Business

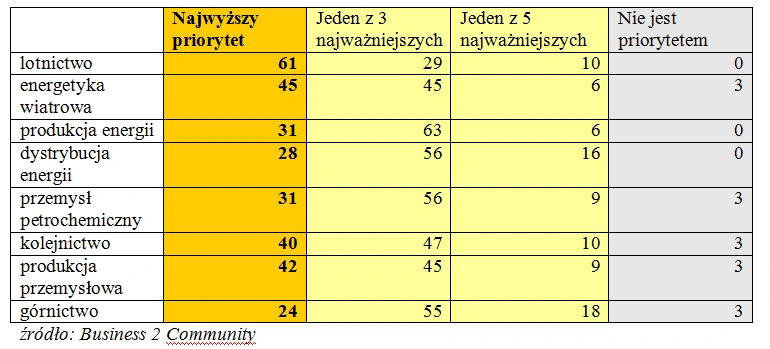

Jak ważna jest implementacja Big Data w stosunku do innych priorytetów w twojej firmie w %

źródło: badanie KPMG International "Zrozumieć dane: od wiedzy do wartości” (Going beyond the data. Turning data from insights into value), 2015