Przemysł wyrachowany

-

- Tomasz Demski,

- 21.02.2005

Dogłębna analiza danych nie jest domeną jedynie sprzedaży czy marketingu. Może być bardzo użyteczna także w przemyśle, w tym przypadku występuje jednak więcej zmiennych i parametrów.

Dogłębna analiza danych nie jest domeną jedynie sprzedaży czy marketingu. Może być bardzo użyteczna także

w przemyśle, w tym przypadku występuje jednak więcej zmiennych i parametrów.

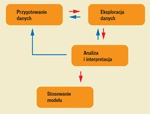

Współczesne produkty i procesy produkcyjne stają się coraz bardziej skomplikowane, rosną także wymagania odnoszące się do ich jakości. Zarówno podczas projektowania produktu, jego wytwarzania, jak i korzystania z niego przez użytkownika gromadzone są bardzo duże ilości danych. W danych tych ukryta jest wiedza, którą można wydobyć, korzystając z narzędzi data mining (zgłębiania danych).

Parametrów wiele

Można wskazać kilka specyficznych cech zgłębiania danych w przemyśle. Pierwsza z nich to bliski związek ze statystycznym sterowaniem jakością procesów (SPC). Bardzo często zgłębianie danych stosujemy jako rozwinięcie i uzupełnienie SPC. Stąd często tego typu zastosowania określa się nazwą Quality Control data mining (lub QC data mining). Nakłada to na systemy analityczne stosowane w przemyśle wymóg integracji z narzędziami do tradycyjnego SPC, jak karty kontrolne, analiza zdolności procesu i analiza niezawodności.

Na etapie projektowania użyteczna jest współpraca z aplikacjami wspomagającymi projektowanie (CAD). Kolejnym wyróżnikiem data mining dla przemysłu jest wymóg automatycznego reagowania na zmiany zachodzące w analizowanych zbiorach danych - możliwie na bieżąco. Jako ilustrację rozważmy system, który przed zakończeniem wieloetapowego procesu technologicznego ma przewidywać, które produkty prawdopodobnie będą wadliwe, aby zaoszczędzić na końcowych etapach procesu. Oczywiste, że wyniki działania systemu muszą być dostępne natychmiast, tak abyśmy mieli czas i możliwość korzystania z wyników analizy.

Dane dotyczące procesów technologicznych zawierają zazwyczaj bardzo dużo - setki lub nawet tysiące zmiennych, co stanowi ich specyfikę. Wynika ona z tego, że dane generowane są przez urządzenia automatyki przemysłowej. Zapisują one mnóstwo parametrów, których wartości często nie mają związku z wytwarzanym w danej chwili produktem, ale mogą być decydujące dla innego produktu. Duża ilość zmiennych występuje także w przypadku analizy danych o procesach wsadowych, w których zmiennymi są wyniki pomiarów parametrów procesów dokonane w różnym czasie.

Ponadto w wielu dziedzinach produkcji zmiany zachodzą bardzo szybko - czas życia produktów i okres stosowania konkretnej technologii ciągle się zmniejsza. W związku z tym najczęściej będzie potrzebne narzędzie pozwalające na budowę rozwiązania (modelu) typu "czarna skrzynka" - bowiem nie będziemy mieli po prostu czasu na zrozumienie wszystkich zachodzących zależności. Modele muszą radzić sobie z dużą ilością danych niewpływających w żaden sposób na zmienną wyjściową i łatwo adaptować się do zmienionych technologii i nowych produktów. W praktyce dogłębna analiza danych jest w przemyśle stosowana w takich obszarach, jak projektowanie i doskonalenie produktu, sterowanie i optymalizacja procesu produkcyjnego czy też analiza reklamacji i niezawodności.

Na etapie projektowania data mining może dotyczyć kwestii związanych z klientem, np. identyfikacji potrzeb klientów i prognozowania popytu. Ponadto możemy badać zależności między projektami produktów, portfelem produktów i potrzebami klientów. Z kolei w przypadku etapu wytwarzania są to głównie: statystyczne sterowanie jakością procesu, przewidywanie problemów z jakością, wykrywanie ich przyczyn czy utrzymanie maszyn (np. planowanie przeglądów i remontów tak, aby uniknąć awarii). Jest to również sterowanie przebiegiem procesów, wykrywanie przyczyn i związków pomiędzy parametrami tych procesów, a także podsumowanie wielowymiarowych danych.

Weźmy dwa przykłady praktycznego i udanego zastosowania data mining w przemyśle zaczerpnięte z literatury światowej (m.in. "Data Mining for Design and Manufacturing. Methods and Applications", Kluwer Academic Publishers 2001, "Predictive data mining. A practical guide", Morgan Kaufman Publishers 1998 czy "Mastering data mining", John Willey & Sons 2000).

Sterowanie procesem

Operator ma do dyspozycji wiele ustawień, tj. wartości zmiennych sterujących, ale faktycznie na ilość materiału w zbiorniku wpływa tylko jedna z nich. Celem analizy było przewidzenie wartości zmiennej sterującej, przy której zostanie zachowana optymalna ilość surowca w zbiorniku. Parametry opisujące stan procesu i zbiornika oraz wartość zmiennej sterującej zapisywane są co 30 s. Jako wzorzec odpowiedniego ustawienia zmiennej sterującej przyjęto działania kilku różnych operatorów. Niestety, optymalnych ustawień nie udało się wyznaczyć teoretycznie.

Potrzeba jednak pozostała, bowiem umiejętność zamodelowania działania operatora, by później dało się je naśladować, była bardzo potrzebna. Formalny, komputerowy model ma wiele zalet. Przykładowo, w przypadku odejścia doświadczonego pracownika tracimy jego doświadczenie, a dopóki nowy operator nie nabierze doświadczenia ryzyko wystąpienia problemów jest znacznie większe. Przy sterowaniu automatycznym będzie (a przynajmniej powinno być) mniej wahań losowych, a cały proces powinien być stabilniejszy.

W praktyce zmiany były dokonywane przez operatora na podstawie jego wyczucia i doświadczenia. Większość z nich to zmiany małe i nieistotne. W związku z tym zdecydowano, że przewidywana będzie zmiana poziomu zmiennej sterującej po 3 min. Jakość uzyskanych wyników zdecydowanie polepszyło stosowanie średnich ruchomych i wartości trendów zamiast surowych wartości parametrów. Pozwoliło to na wyeliminowanie losowych wahań parametrów. Ponadto w analizie uwzględniono tylko te obserwacje, w których zmienna sterująca została znacząco zmodyfikowana - drobne, wykonywane przez człowieka korekty były mylące i niedokładne.

Jednym z podstawowych narzędzi stosowanych w eksploracji danych są sieci neuronowe. Przyjmuje się, że jest to już praktycznie standardowy element wszystkich profesjonalnych pakietów służących do zaawansowanej statystycznej analizy danych. Takie programy potrafią same automatycznie dobierać najlepszą architekturę sieci neuronowej (zależnie od określonego zadania), określić jej złożoność i uczyć ją (na podstawie zewnętrznych zbiorów danych).

Sieci neuronowe zdają egzamin zwłaszcza w przypadku procesów produkcyjnych, w szczególności w obszarze kontroli jakości, bowiem mamy tam do czynienia z dużą liczbą zmiennych, odnośnie do których nie zawsze istnieją explicite reguły rządzące ich zachowaniem. Prościej i efektywniej jest więc, biorąc zebrane historyczne dane, nauczyć odpowiednich reakcji czy odpowiedzi sieć neuronową niż rekonstruować reguły.