Nawigacja w liczbach

-

- Przemysław Gamdzyk,

- 20.12.2004

Rozwiązania analizy statystycznej i data miningu na ogół oferowane są w ramach jednolitej oferty rozwiązań zaawansowanej analizy danych.

Rozwiązania analizy statystycznej i data miningu na ogół oferowane są w ramach jednolitej oferty rozwiązań zaawansowanej analizy danych.

Metody statystyczne, będące dorobkiem dojrzałej dziedziny, jaką jest dzisiaj statystyka, są włączone do funkcjonalności narzędzi wszystkich dostawców rozwiązań zaawansowanej analizy danych - to pewien fundament, którym nie sposób się już wyróżniać. Odmienności można wszakże dostrzec w sprofilowaniu poszczególnych aplikacji analitycznych pod kątem określonych zastosowań - przykładowo analizy finansowej, marketingowej czy produkcyjnej.

Natomiast różnice w wykorzystywanych technologiach widać dopiero przy narzędziach służących do data miningu - zwłaszcza tych, w których wykorzystuje się rozwiązania sztucznej inteligencji. Tutaj pomiędzy dostawcami trwa prawdziwy wyścig o to, komu uda się szybciej wprowadzić nowe rozwiązania. "Tempo adoptowania przez dostawców wyników prac naukowych w tej dziedzinie jest wyjątkowo szybkie" - twierdzi Arkadiusz Ziemba, prezes zarządu StatConsulting (co ciekawe, standardem jest już stosowanie sieci neuronowych do przetwarzania dużych zbiorów danych).

Moduły analizy statystycznej i data mining z górnej półki to bardzo drogie rozwiązania (przynajmniej kilkaset tys. zł), ale dostępna jest również oferta tańszych rozwiązań, bardzo różnorodnych pod względem oferowanej funkcjonalności. Na tym rynku w Polsce najbardziej liczą się SAS Institute, StatSoft i SPSS, a od jakiegoś czasu zauważalna jest obecność rodzimej firmy StatConsulting. Światowa oferta firm oferujących narzędzia data mining i analizy statystycznej jest bardzo szeroka, często są to produkty ściśle wyspecjalizowane w konkretnych zastosowaniach. Kłopot sprawia jednak brak jednolitych standardów - każdy z tych produktów inaczej realizuje procesy data miningu, co utrudnia prowadzenie dużych projektów, wymagających zastosowania kilku narzędzi. Dlatego prowadzone są obecnie prace nad projektem zbudowania standardu CRISP-DM (obecnie w wersji 1.0 - więcej informacji podhttp://www.crisp-dm.org ).

Rodzime rozwiązanie

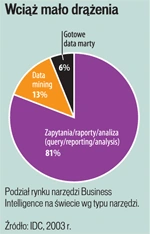

Wciąż mało drążenia

"To, że mamy własny produkt, nad którym sprawujemy pełną kontrolę poprzez posiadane kody źródłowe, sprawia, że możemy elastycznie dopasować oferowane narzędzia do potrzeb klienta w stopniu, który jest trudny do osiągnięcia dla dostawców gotowych rozwiązań zagranicznych" - twierdzi Arkadiusz Ziemba. Posłużono się tutaj standardem Common Warehouse MetaModel oraz technologią obiektową NetBeans i językiem skryptowym zbudowanym na bazie Pythona. W ten sposób powstał system Górnik, obejmujący swoją funkcjonalnością wstępne przetwarzanie i wizualizację danych, konstrukcję i testowanie modeli analitycznych aż po aplikację modeli dla danych produkcyjnych. Modele można budować zarówno z wykorzystaniem interaktywnego interfejsu, jak i wspomnianego obiektowego języka skryptowego. Dzięki wykorzystaniu skryptów analityk może uzyskać pełną kontrolę nad procesem modelowania i w tym właśnie StatConsulting upatruje przewagi swojego produktu.

Analityka dla wiedzących

Wykorzystanie rozwiązań zaawansowanej analizy statystycznej i data mining wymaga specyficznej wiedzy - chodzi przede wszystkim o kierunki ścisłe. "Widać coraz większe zainteresowanie uczelni wykorzystywaniem rozwiązań data miningowych" - mówi Arkadiusz Ziemba. Ta uwaga nie odnosi się jednak do użytkowników zbudowanych rozwiązań. Menedżer nie musi wnikać w strukturę zbudowanego modelu data mining, ale żeby chciał z niego rzeczywiście korzystać, musi mieć zaufanie do analityka, który taki model buduje.

"Rozwiązania data mining generalnie przeznaczone są dla świadomych użytkowników, czyli tych, którzy wiedzą, jaki użytek można zrobić z posiadanych danych" - twierdzi Piotr Wójtowicz, kierownik działu kluczowych klientów w StatSoft Polska. Nie chodzi tutaj o tworzenie zestawień i raportów dotyczących tego, co było kiedyś - to raczej zdolność do takiej interpretacji zjawisk z przeszłości, by zbliżyć się do wiedzy dotyczącej jutra, tego, co dopiero się wydarzy. Zawsze powinien być jasno określony cel analizy - bez wizji docelowej takie wdrożenie może się nigdy nie skończyć.

Dopiero teraz widać u nas początki rozwoju systemów analitycznego CRM (do tej pory głównie chodziło o CRM operacyjny). Rynek zaawansowanej analizy tak naprawdę dopiero się rodzi, a zrealizowane wdrożenia mają charakter raczej wyspowy. Wdrożenia są bardzo pracochłonne w realizacji, wymagając długotrwałych prac nad budową właściwych modeli, eksperymentowania z danymi. Na przykład ponad rok zajęło przeprowadzone przez StatSoft wdrożenie rozwiązania analitycznego opartego m.in. na data mining programu lojalnościowego dla jednego z największych polskich przedsiębiorstw.

Nowe trendy

Wskazać można obszary nowych zastosowań i form prowadzenia zaawansowanej analizy. Pojawiła się oferta świadczenia usług analizy danych na zlecenie klienta. Usługi outsourcingowe polegają tutaj nie tylko na budowaniu modeli analitycznych na zamówienie klienta (do czego trzeba solidnej porcji wiedzy dotyczącej statystyki i metod data mining), lecz także na oddaniu w pacht outsourcera posiadanych zbiorów danych, by ten sobie je sam przetwarzał. To ostatnie rozwiązanie ma tę zaletę, że taka firma jest w stanie, gromadząc dane pochodzące od różnych podmiotów (konkurencyjnych), uzyskiwać wiarygodne próbki statystyczne, istotne do benchmarkingu i korekty budowanych modeli.

Innym trendem jest budowanie modeli symulacyjnych, gdzie dane gromadzone w systemach Business Intelligence służą jako medium weryfikacji zbudowanych modeli (przy czym symulacja jest tutaj komputerowym odwzorowaniem organizacji funkcjonowania firmy - symulować można każdą działalność, np.: funkcjonowanie działu operacyjnego w banku, linię produkcyjną w fabryce, przypisanie pracowników do zmiany w call center czy szpitalu). Chodzi o rozpoznanie związków przyczynowo-skutkowych pomiędzy wszystkimi (ilościowymi i jakościowymi) elementami modelu biznesowego przedsiębiorstwa, uwzględnienie wielokierunkowych związków przyczynowo-skutkowych (sprzężeń zwrotnych) czy dynamiczne śledzenie zachowania się głównych zmiennych decydujących o zachowaniu się przedsiębiorstwa i jego wynikach finansowych.

"Za pomocą modelu komputerowego prowadzi się eksperymenty polegające na symulacji zmian organizacyjnych. Głównym celem tego typu działań jest optymalizacja funkcjonowania firmy i badanie wpływu zmian organizacyjnych na prowadzony biznes przed ich wprowadzeniem" - mówi Konrad Kowalczyk z Altkom Akademia, która zrealizowała taki projekt dla polskiego oddziału jednego z liderów rynku paliwowego.

Oprócz dominujących to tej pory technik analizy liczb ostatnio coraz większego znaczenia zaczyna nabierać poszukiwanie rozwiązań przeszukiwania danych tekstowych (text mining) i innych danych w postaci niestrukturalnej. Ocenia się, że tak naprawdę to w typowym przedsiębiorstwie aż 85% wszystkich danych ma postać niestrukturalną. Natomiast techniki przeszukiwania zbiorów danych tekstowych oraz tworzenia taksonomii i hierarchii nabrały gwałtownie znaczenia nie tylko za sprawą rozwoju Internetu i internetowych wyszukiwarek, lecz także nowych regulacji prawnych wymagających od firm dysponowania informacjami, które trzeba wydobywać z tekstowych zbiorów danych.

Chociaż dostępne są już narzędzia pozwalające na jednoczesną analizę danych strukturalnych i pozbawionych wyraźnej struktury, to w praktyce najczęściej wykorzystuje się narzędzia Business Intelligence do analizy tych pierwszych, by dopiero potem uwzględniać osiągane wyniki w przeszukiwaniu zbiorów tekstowych z wykorzystaniem zupełnie innych narzędzi. Przykładowo, w firmie Electronic Data Systems (EDS) do analizy kwestionariuszy wypełnianych online przez ok. 130 tys. pracowników tej firmy wykorzystywano narzędzia Sasa czy SPSS, które dane agregowały, segregowały i analizowały. Jednak część odpowiedzi - czasem tych najbardziej istotnych - sprowadzała się do pisanych komentarzy, pozbawionych oczywiście struktury niezbędnej klasycznym narzędziom BI. Te odpowiedzi były analizowane "ręcznie" z całą niedokładnością ludzkiego subiektywizmu tych, którzy te wypowiedzi oceniali. EDS wdrożył więc rozwiązanie PolyAnalyst firmy Magaputer Intelligence (oparte z kolei na implementacji słownika semantycznego WordNet stworzonego przez Cognitive Science Laboratory na Princeton University), dzięki któremu można tworzyć zestawienia odpowiedzi "pisanych" (słowa i związki frazeologiczne zostają przypisane poszczególnym kategoriom tematycznym).

Narzędzia text mining to zarówno dedykowane narzędzia, jak i moduły zawarte w większych systemach. Ich dostawców można podzielić na następujące grupy:

- Dostawcy baz danych - jak IBM czy Oracle - którzy wbudowują algorytmy rozpoznawania wzorców do swoich baz danych.

- Producenci korporacyjnych narzędzi wyszukiwawczych, jak Autonomy czy Verity

- Dostawcy rozwiązań do zarządzania zawartością, jak Interwoven, którzy wykorzystują do zarządzania cyklem życia informacji taksonomie i kategoryzacje tekstu.

- Dostawcy rozwiązań data mining, jak SAS Institute, SPSS czy Science Applications, którzy swoją ofertę wzbogacili o text mining.

- Firmy wyspecjalizowane w ofercie text mining, jak Inxight Software czy Stratify.

Podstawową grupę użytkowników rozwiązań analizy statystycznej i data mining tworzą: sektor bankowy, finansowo-ubezpieczeniowy, telekomunikacyjny i handlu detalicznego czy dóbr szybkozbywalnych, a ostatnio również portale internetowe (do analizy ruchu). Rzeczywistych obszarów zastosowań jest jednak znacznie więcej, przykładowo:

- prognozowanie przychodów z ogłoszeń

- kontrolowanie procesów odchodzenia klientów (churn management)

- przetwarzanie reklamacji

- analiza ryzyka kredytowego

- cross-marketing

- profilowanie i segmentacja klientów

- analiza raportów o błędach

- analiza zamówień w barach szybkiej obsługi

- wykrywanie nadużyć

- wspomaganie procesu rekrutacji

- tworzenie zryczałtowanych cenników

- kontrola jakości i procesów

- analiza wykorzystania gwarancji na produkty