Zarządzanie wydajnością sieci

-

- NetWorld,

- 01.12.2004

Rośnie liczba i złożoność aktywnych elementów w sieci, a także ich funkcjonalność. Tradycyjne zarządzanie siecią koncentruje się zazwyczaj na utrzymaniu w dobrej kondycji poszczególnych jej komponentów. Wynika to z założenia, że dobry stan każdego z nich gwarantuje dobrą kondycję całej sieci. Jednak w rozbudowanych sieciach niekoniecznie musi się to sprawdzać.

Rośnie liczba i złożoność aktywnych elementów w sieci, a także ich funkcjonalność. Tradycyjne zarządzanie siecią koncentruje się zazwyczaj na utrzymaniu w dobrej kondycji poszczególnych jej komponentów. Wynika to z założenia, że dobry stan każdego z nich gwarantuje dobrą kondycję całej sieci. Jednak w rozbudowanych sieciach niekoniecznie musi się to sprawdzać.

Wzrost liczby elementów infrastruktury sieciowej i topologiczna złożoność rozszerzającej się sieci powodują, że monitorowanie i zarządzanie jej elementami staje się coraz bardziej skomplikowane. Zarządzanie ruchem sieciowym przechodzącym przez ciągle zmieniający się labirynt połączeń oznacza nieuchronny wzrost objętości informacji statystycznej. W miarę zwiększania się wymagań odnośnie do redundancji, wydajności i liczby aplikacji krytycznych, rośnie też złożoność całej architektury. Zwiększa się również obciążenie sieci związane z monitorowaniem, co wymusza potrzebę nowego podejścia do gromadzenia danych i ich analizy.

Zrozumienie współzależności pomiarów (jak sieć, serwer i komponenty aplikacji mogą wpływać na siebie nawzajem) oraz konieczności stosowania alarmów - zarówno wyprzedzających, jak i będących bezpośrednią odpowiedzią na zdarzenie, wymaga efektywnych metod analiz i niekonwencjonalnego podejścia do ustawiania progów alarmowych.

Problem z nadmiarem danych

W ciągu kilku ostatnich lat elementy sieciowe stały się bardziej złożone. I tak ethernetowe huby zostały wyparte przez przełączniki warstwy 3, obsługujące wirtualne LAN-y. To prowadzi do prawdziwej eksplozji statystyk i informacji konfiguracyjnych pochodzących z tych elementów.

Duża ilość z trudem gromadzonych danych nie musi oznaczać, że informacja z nich uzyskana prowadzi do użytecznej wiedzy, którą można by wykorzystać przy podejmowaniu decyzji administracyjnych. Wręcz przeciwnie, wolumen informacji przechwytywanej z sieci może uniemożliwiać analitykom i projektantom systemów ich szybkie przetworzenie w celu uzyskania użytecznych analiz. W efekcie duże wolumeny danych mogą sabotować podstawowy cel ich zbierania: efektywne zarządzanie infrastrukturą sieciową.

Problem selekcji danych

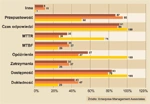

Pomiary istotne dla jakości usług w opinii usługodawców i przedsiębiorstw

Decyzja, jakie dane należy zbierać, dotyczy specyficznych statystyk zbieranych z każdego elementu sieci, wymagań stawianych przez algorytmy analiz powiązań (między elementami i wewnątrz elementów) oraz doświadczalnie wyznaczonego modelu monitorowania i zarządzania. Większość tego typu mechanizmów decyzyjnych jest zawarta w systemach zarządzania, które stosują unikatowe metody i mechanizmy do zarządzania wolumenami danych.

Przykłady możliwości systemów zarządzania w zakresie radzenia sobie z eksplozją danych monitorowania można znaleźć w narzędziach dynamicznie zmieniających zakres zbierania danych na podstawie informacji w nich zawartych. Na przykład: jeżeli port przełącznika zaczyna generować nadmierną liczbę błędów, system zarządzania może zbierać dodatkowe informacje z tego portu, obejmujące możliwość przechwytywania całych pakietów do analizy. Kiedy port powróci do stanu normalnego, ta dodatkowa informacja nie będzie już dłużej gromadzona.

Chociaż podejście takie generalnie redukuje wolumen informacji zbieranej w sposób ciągły, to jednak może się zdarzyć, że dane, które mogą być użyteczne dla zrozumienia przyczyny problemu, nie zostaną zgromadzone przed jego pojawieniem. Nieregularne powtarzanie się problemu może wymagać zbierania dodatkowych danych, aż do momentu, kiedy będą one wystarczające do wyjaśnienia przyczyny. W niektórych przypadkach rozwiązania zarządzania mogą mieć zdolność do automatyzacji takich działań, jak również wyprzedzającego diagnozowania - przy użyciu tzw. wyzwalaczy. Wyzwalacze mogą być konfigurowane wewnętrznie lub przez reguły polityki będące w gestii zespołu operacyjnego.

Przy ogromnych wolumenach danych produkowanych przez systemy zarządzania dużymi sieciami selekcja danych przydatnych dla konkretnego potencjalnego problemu lub naprawy uszkodzenia jest dużym wyzwaniem. Dane, które w wielu przypadkach same w sobie mają niewielką użyteczność, stają się bardzo istotne w korelacji z innymi. Na przykład adresy fizyczne stacji roboczych w sieci lokalnej rzadko bywają użyteczną informacją. Jednak notebook z uszkodzonym interfejsem ethernetowym, który zaczyna generować nadmierny ruch lub rzadkie błędy, przemieszczając się z sieci do sieci, będzie łatwiejszy do namierzenia, jeśli ustali się, że przypadkowe błędy pojawiające się w różnych sieciach są związane z tym samym adresem fizycznym.

Inny przykład tego typu: po utracie danych spowodowanej serią wielu niewykrytych błędów, analiza przyczyny pierwotnej może zidentyfikować zapis w logu składowania wskazujący na błędy składowania w okresie kilkunastu dni, które nigdy nie były raportowane przez system alarmowy. Wolumen danych w raportach składowania był tak duży, że człowiek i procesy, jakie zastosowano do znalezienia błędów, zawiodły. Należy przy tym zauważyć, że istnieje dużo więcej punktów generujących dane w sieci dla systemów monitorowania, niż tylko logi składowania, i potrzeba rozwiązania problemu efektywnego powiadamiania staje się oczywista.

Problem z danymi monitorowania sieci polega na tym, że większość z nich jest użyteczna dopiero po ścisłym skorelowaniu z technologią usług, możliwymi przyczynami pierwotnymi i procesami biznesowymi. Bez takiej korelacji większość statystyk sieciowych ma ograniczoną użyteczność w codziennym zarządzaniu siecią. Różne procesy biznesowe i usługi technologiczne mają tendencję przekraczania granic wielu sieci i systemów. Problem z pojedynczym komponentem, takim jak serwer bazodanowy, wpływa na wydajność całej usługi. Powiązanie komponentów w kontekście tej usługi zapewnia istotną informację przydatną do rozwiązania problemu.

Jednak takie korelacje wymagają dogłębnego zrozumienia architektury sieci i jej założeń projektowych, aplikacji i procesów biznesowych wykonywanych w niej oraz poszerzonej analizy przyczyny źródłowej.

Wolumen danych nie jest jednak jedynym problemem: muszą być one jeszcze wysłane do systemu zarządzania, gdzie są przechowywane i analizowane.