Superkomputery dla mas

-

- Przemysław Gamdzyk,

- 21.07.2003

Amerykańskie superkomputery straciły pozycję lidera na liście 500. największych superkomputerów na świecie. Pod względem wydajności japoński superkomputer Earth Simulator po prostu je znokautował. Nadzieją na odzyskanie dawnej pozycji Stanów Zjednoczonych jest projekt IBM zbudowania dwóch superkomputerów o potencjalnej wydajności przekraczającej 100 teraflopów.

Amerykańskie superkomputery straciły pozycję lidera na liście 500. największych superkomputerów na świecie. Pod względem wydajności japoński superkomputer Earth Simulator po prostu je znokautował. Nadzieją na odzyskanie dawnej pozycji Stanów Zjednoczonych jest projekt IBM zbudowania dwóch superkomputerów o potencjalnej wydajności przekraczającej 100 teraflopów.

Przedrostek super w nazwie najpotężniejszych komputerów nie jest przesadą - chodzi bowiem o najbardziej zaawansowane rozwiązania technologiczne zastosowane, aby osiągnąć maksymalnie dużą wydajność. Cena odgrywa mniejszą rolę, ponieważ chodzi o problemy obliczeniowe bliskie granicy ludzkiego poznania, za przekroczenie której jesteśmy gotowi wiele zapłacić. Sytuacja jednak zaczęła się zmieniać, gdy pojawiły się możliwości wykorzystania efektu mnożnikowego - po co przeznaczać ogromne sumy na jeden superwydajny komputer, skoro można złożyć razem wiele tanich elementów, osiągając ten sam efekt?

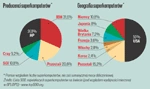

Producenci i geografia superkomputerów.

Przetwarzanie kratowe, w którym obliczenia wykonuje duża liczba komputerów połączonych siecią rozległą (także za pośrednictwem Internetu), jest ograniczone do wąskiego zakresu zastosowań - zasadniczo przypadków, w których dysponuje się dużym zbiorem danych, obliczenia są stosunkowo nieskomplikowane i można je przeprowadzać na wybranych fragmentach zbioru danych. Jest to np. wyszukiwanie nietypowych wzorców w dużych blokach danych pomiarowych (jak w projekcie SETI, który polega na poszukiwaniu potencjalnych śladów istnienia istot pozaziemskich w wynikach nasłuchu radiowego w przestrzeni kosmicznej).

Wysoko wydajne klastry obliczeniowe (High Performance Computing Clusters - HPCC) mogą już zdziałać więcej. Po pierwsze, same węzły takiego klastra są znacznie bardziej wydajne (choć nadal oparte na procesorach pracujących w komputerach PC lub podobnych), po drugie zaś, komunikacja w klastrze pomiędzy poszczególnymi węzłami jest nieporównanie bardziej efektywna niż w sieci rozległej. Nadal jednak superkomputery wektorowe przetwarzające w pojedynczych operacjach duże bloki danych, w pewnych zastosowaniach okazują się niezastąpione (zasadniczo tam, gdzie obliczeniom musi towarzyszyć intensywna komunikacja między procesorem a pamięcią komputera).

"Pole zastosowań superkomputerów nie tyle się zmniejsza, ile przesuwa. Stale musimy na nowo definiować pojęcie wielkiego problemu obliczeniowego. Dzisiaj jest to np. symulowanie procesów biologicznych w skali organizmów" - wyjaśnia prof. Marek Niezgódka.

Klastry przemysłowe

Rozwój systemów HPCC przekroczył już fazę eksperymentu. Wysoko wydajne klastry obliczeniowe są produktami "rzemieślniczymi", a na ich wytwarzanie w skali przemysłowej trzeba jeszcze poczekać. Co prawda systemy HPCC wychodzą już poza środowiska naukowo-akademickie, ale nie są jeszcze standardowymi rozwiązaniami, wciąż bowiem każdy klaster jest produktem jednostkowym. Do zbudowania superkomputera nie wystarczy połączenie szybką siecią dowolnych komputerów PC, potrzebna jest praca koncepcyjna nad odpowiednim doborem poszczególnych komponentów oraz - co nie mniej istotne - przygotowanie oprogramowania, które będzie na takim klastrze efektywnie pracować. Dostępne są wprawdzie bazy danych (jak DB2 czy Oracle9i RAC), wykorzystujące możliwości klastrów, ale nie da się zrekompilować istniejących aplikacji tak, aby bez większych modyfikacji kodu potrafiły one efektywnie w tym środowisku działać (w przypadku bardziej skomplikowanych zadań obliczeniowych znacznie łatwiej jest oprogramować tradycyjny superkomputer niż HPCC).

"Uruchomienie systemu klastra obliczeniowego musi poprzedzać poważna praca koncepcyjna" - uważa prof. Marek Niezgódka (w ICM powstaje ponad 100-węzłowy klaster o architekturze niejednorodnej, tzn. będą w nim funkcjonować komputery wieloprocesorowe; jego powstanie poprzedziły testy prowadzone na małych instalacjach klastrowych).

Co ciekawe, wiele klastrów HPCC działa pod kontrolą systemu Linux (z czego największy w Lawrence Livermore National Laboratory ma teoretyczną wydajność 6 tys. gigaflopów, tj. 6 bln operacji zmiennoprzecinkowych na sekundę). W biznesie rozwiązania HPCC powinny znaleźć zastosowanie przede wszystkim w eksploracji zasobów naturalnych (np. lokalizowania złóż ropy naftowej), bioinformatyce (koncerny farmaceutyczne) czy symulacjach (np. próbach zderzeniowych). Chrysler, znany amerykański producent samochodów, wykorzystuje klaster złożony z komputerów RISC i Pentium Itanium.

Produkcją tego typu klastrów zajmuje się nawet Dell, firma kojarzona raczej ze standardowymi produktami. W centrum superkomputerowym University of Illinois przeprowadzono udany eksperyment budowy wydajnej maszyny obliczeniowej opartej na 70 konsolach gier Sony PlayStation 2. Te stosunkowo tanie urządzenia są wyposażone w bardzo wydajne koprocesory matematyczne, które w grach są wykorzystywane do generowania fotorealistycznej grafiki komputerowej. W tym eksperymencie wykorzystano je jednak do przeprowadzenia zaawansowanych symulacji z obszaru fizyki kwantowej.